生成 AI と基盤モデルにより、自律マシンはトレーニング済みの運用設計ドメインを超えて汎用化できます。トークン化、大規模言語や拡散モデルなどの新しい AI 技術を使用することで、開発者と研究者は自律化への長年の障害に対処できるようになりました。

これらの大規模なモデルでは、トレーニング、ファインチューニング、検証のために、膨大な量の多様なデータが必要です。しかし、夜間に歩行者が自動運転車 (AV) の前を横断したり、人間が溶接ロボットの作業セルに入ったりするなど、まれなエッジ ケースや潜在的に危険なシナリオからデータを収集することは、非常に困難でリソースを大量に消費する可能性があります。

開発者がこのギャップを埋めるのを支援するために、NVIDIA Omniverse Cloud Sensor RTX API は、大規模なデータセットを生成するための物理的に正確なセンサー シミュレーションを可能にします。アプリケーション プログラミング インターフェイス (API) は、カメラ、レーダー、LiDAR など、自律走行に一般的に使用されるセンサーをサポートするように設計されており、既存のワークフローにシームレスに統合して、あらゆる種類の自動運転車やロボットの開発を加速できます。

Omniverse Sensor RTX API は現在、一部の開発者に早期アクセスで提供されています。Accenture、Foretellix、MITRE、Mcity などの組織は、ドメイン固有のブループリントを介してこれらの API を統合し、次世代の産業用製造ロボットや自動運転車を展開するために必要なツールをエンド カスタマーに提供しています。

Omniverse Blueprintで産業用 AI を強化

工場や倉庫などの複雑な環境では、ロボットが機械や人間の作業員と並んで安全かつ効率的に作業できるように調整する必要があります。これらの可動部品はすべて、中断を回避しながら操作を設計、テスト、検証する際に大きな課題となります。

Mega は、NVIDIA アクセラレーテッド コンピューティング、AI、NVIDIA Isaac、NVIDIA Omniverse テクノロジのリファレンス アーキテクチャを企業に提供する Omniverse Blueprintです。企業はこれを使用してデジタル ツインを開発し、ロボット、カメラ、機器などを動作させる膨大な複雑さと規模を処理する AI 搭載のロボット ブレインをテストできます。

Omniverse Sensor RTX を統合したこのブループリントにより、ロボット開発者は工場内のあらゆる種類のインテリジェント マシンからのセンサー データを同時にレンダリングして、忠実度の高い大規模なセンサー シミュレーションを実行できます。

シミュレーションで操作とワークフローをテストする機能により、製造業者は時間と投資を大幅に節約し、まったく新しい方法で効率を向上させることができます。

国際的なサプライチェーン ソリューション企業である KION Group と Accenture は、Mega ブループリントを使用して、スマート カメラ、フォークリフト、ロボット機器、デジタル ヒューマンからのデータを活用し、産業用 AI のロボット ブレインに向けた仮想トレーニングおよびテスト環境として機能する Omniverse デジタル ツインを構築しています。

ロボット ブレインは、Omniverse Sensor RTX API によってレンダリングされた物理的に正確なセンサー データを使用して、シミュレートされた環境を認識します。このデータを使用して計画と行動を行い、各アクションは Mega で正確に追跡され、デジタル ツイン 内のすべてのアセットの状態と位置も追跡されます。これらの機能により、開発者は新しいレイアウトを物理世界に実装する前に継続的に構築したテストが可能になります。

AV 開発と検証の推進

自動運転車は 10 年以上にわたって開発されてきましたが、適切なトレーニングと検証データの取得における障壁と、反復サイクルの遅さが、大規模な展開を妨げてきました。

センサー データのニーズに対応するために、企業は NVIDIA Omniverse Blueprint for AV simulation を活用することができます。これは、物理的に正確なセンサー シミュレーションを可能にするリファレンス ワークフローです。このワークフローは、Omniverse Sensor RTX API を使用して、AV 開発と検証に必要なカメラ、レーダー、および LiDAR データをレンダリングします。

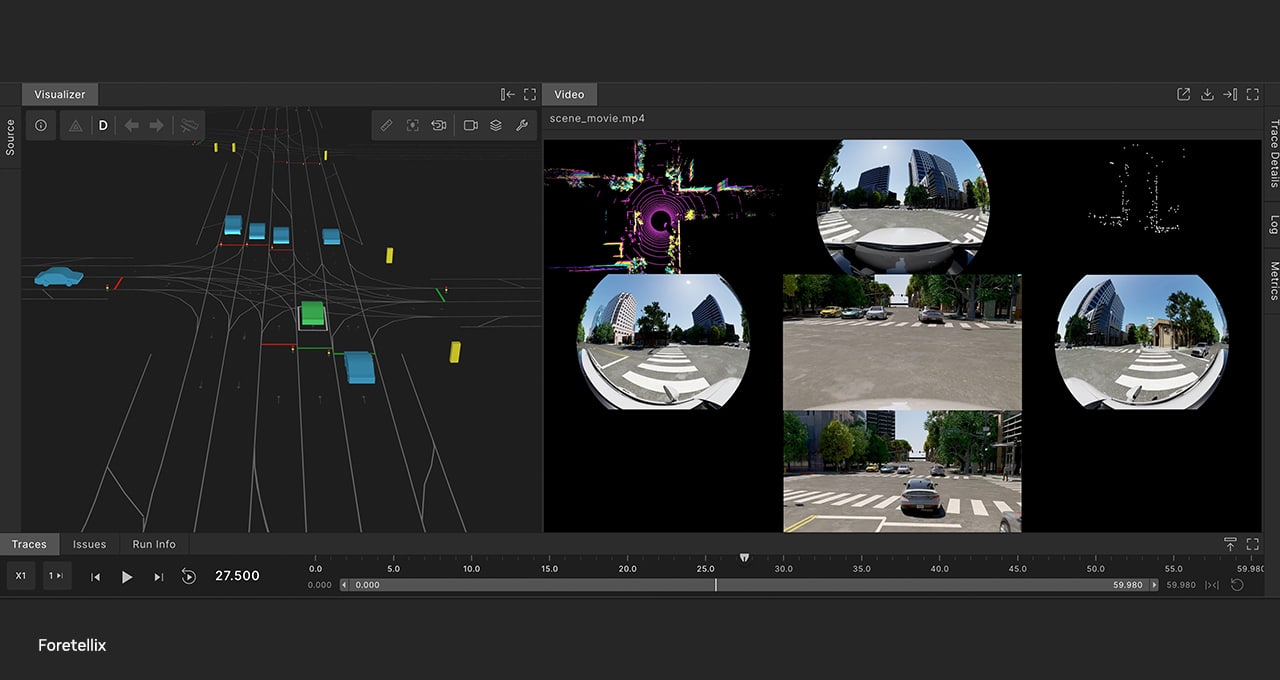

AV ツールチェーン プロバイダーの Foretellix は、このブループリントを Foretify AV 開発ツールチェーンに統合し、オブジェクト レベルのシミュレーションを物理的に正確なセンサー シミュレーションに変換しました。

Foretify ツールチェーンは、任意の数のテスト シナリオを同時に生成できます。これらのシナリオにセンサー シミュレーション機能を追加することで、Foretify は、開発者が AV 開発の完全性を評価し、大規模で安全な展開を実現するために必要な忠実度とスケールのレベルでトレーニングとテストを行えるようにしました。さらに、Foretellix は、新たに発表された NVIDIA Cosmos プラットフォーム を使用して、検証と妥当性確認のためのシナリオをさらに多様化します。

米国で最大規模のレベル 4 展開を誇る自動運転技術プロバイダーの Nuro は、展開前に自動運転車のトレーニング、テスト、検証を行うために Foretify ツールチェーンを使用しています。

さらに、研究機関の MITRE はミシガン大学の Mcity テスト施設と連携して、規制での使用を目的としたデジタル AV 検証用フレームワークを構築しています。これには、Mcity の 32 エーカー (約38,000坪) の自動運転車試験場のデジタル ツインも含まれます。このプロジェクトでは、AV シミュレーション ブループリントを使用して、物理的に正確なセンサー データを仮想環境で大規模にレンダリングし、トレーニングの有効性を高めています。

高精度なセンサー シミュレーションの力により、ロボティクスと自律性の未来が鮮明になってきています。

NVIDIA の創業者/CEO であるジェンスン フアン (Jensen Huang) のCESオープニング基調講演のリプレイをご視聴ください。

ソフトウェア製品情報についてのお知らせはこちらをご覧ください。