発表からわずか数週間で NVIDIA A100 GPU がGoogle Compute Engine に採用

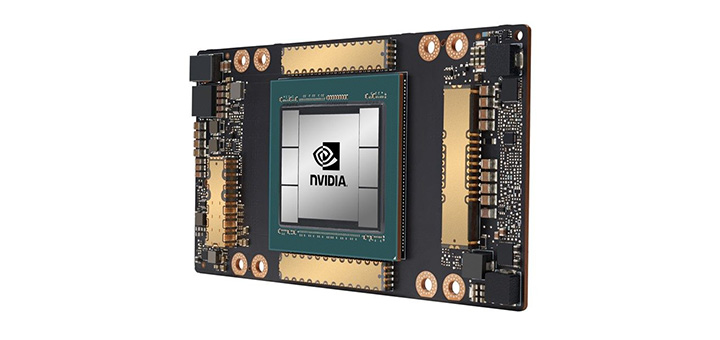

NVIDIA A100 Tensor コア GPU が Google Cloud で利用可能になりました。

A100 は発表からわずか 1 か月あまりで Google Compute Engine にてアルファ版が利用可能になり、これまでのどの NVIDIA GPU と比べても速くクラウドに採用されました。

A100 に対応した Accelerator-Optimized VM (A2) インスタンス ファミリーが本日利用開始となったことで、Google はこの新しい NVIDIA GPU を提供する初のクラウド サービス プロバイダーとなりました。

A100 は新たに導入された NVIDIA Ampere アーキテクチャに基づいて構築されており、NVIDIA 史上最大の世代間の飛躍をもたらします。学習と推論のコンピューティングの性能が従来の 20 倍に向上し、ワークロードを格段にスピードアップさせることで、AI 革命を促進します。

Google Cloud の製品管理ディレクターであるマニシュ サイナニ (Manish Sainani) 氏は次のように述べています。「Google Cloud のお客様は、AI と科学的コンピューティング ワークロードのイノベーションを促進するために、私たちに最新のハードウェアやソフトウェアのサービスを提供することを求めています。新しい A2 VM ファミリーにより、当社が NVIDIA T4 GPU と同様に NVIDIA A100 GPU を提供する初の大手クラウド プロバイダーになれることを誇りに思っています。この新機能をお客様がどう活用するのか、とても楽しみにしています。」

クラウド データ センターにて A100 は、AI の学習や推論、データ分析、科学計算、ゲノミクス、エッジ ビデオ分析、5G サービスなど、幅広いコンピューティング集約型アプリケーションにパワーを提供します。

急成長中のクリティカルな業界は、Google Compute Engine で A100 を使用すれば、その画期的性能によって発見を加速することができます。AI 学習や科学計算のスケールアップから、推論アプリケーションのスケールアウト、さらにはリアルタイムの対話型 AI の実現まで、A100 はクラウド上で実行されるあらゆる規模の複雑で予測不可能なワークロードを加速します。

あらゆる規模のワークロードに対応する、クラウドでの A100 の画期的な性能

新しい A2 VM インスタンスは、CUDA による機械学習のトレーニングや推論、データ分析、さらにはハイパフォーマンス コンピューティングまで、ワークロードを効率的に加速するために、さまざまなレベルのパフォーマンスを提供します。

大規模で要求の厳しいワークロードには、Google Compute Engine の a2-megagpu-16g インスタンスが利用できます。このインスタンスは 16 基の A100 GPU を搭載し、合計 640GB の GPU メモリと、合計 1.3TB のシステムメモリを提供します。すべての GPU は、総帯域幅が最大 9.6TB/秒の NVSwitch を介して接続されます。

また、小規模なワークロードには、Google Compute Engine の小規模構成の A2 VM を利用すれば、個別のアプリケーションのニーズを満たすことができます。

Google Cloud は、さらに Google Kubernetes Engine や Cloud AI Platform などの Google Cloud サービスに NVIDIA A100 のサポートがまもなく追加されることを発表しました。新しい A2 VM ファミリーの技術的な詳細や、アクセスの登録方法などの詳細については、Google Cloud のブログをご覧ください。