オープンソース AI はさまざまな業界でイノベーションを加速させており、NVIDIA DGX Spark と DGX Station は、開発者がイノベーションをインパクトに変えることを支援するために設計されています。

NVIDIA は本日、CES において、DGX Spark とデスクサイド AI スーパーコンピューターである DGX Station により、開発者が最新のオープンかつ最先端の AI モデルをローカルのデスクサイド システムで活用できるようになることを発表しました。DGX Spark の 1,000 億パラメータモデルから DGX Station の 1 兆パラメータモデルまで、幅広いモデルが利用可能です。

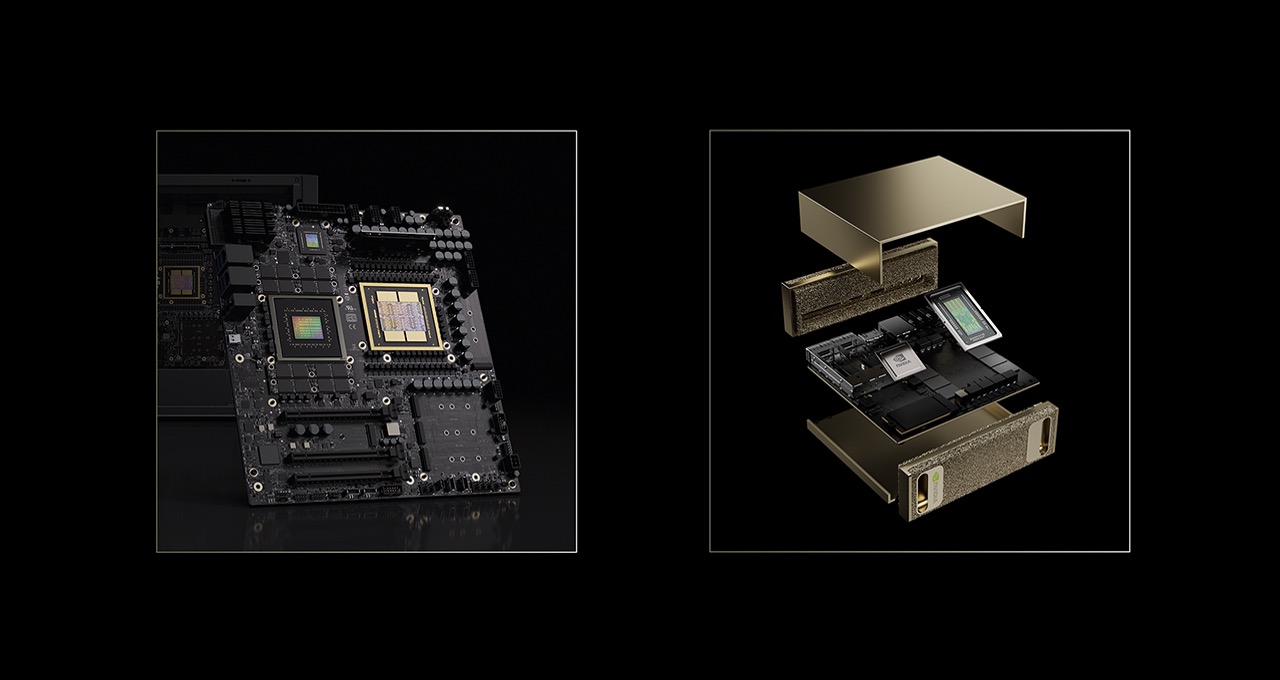

NVIDIA Grace Blackwell アーキテクチャを搭載し、大容量の統合メモリとペタフロップスレベルの AI パフォーマンスを備えたこれらのシステムは、開発者にローカルでの開発と、クラウドへの容易なスケーリングを可能にする新たな機能を提供します。

オープンソースAIモデルのパフォーマンス向上

モデル最適化の継続的な進歩とオープンソースコミュニティとの連携により、これまではデータセンターでの実行が必要だった高度に最適化されたオープンモデルを、DGX Spark と DGX Station のデスクトップで高速化できるようになりました。

NVIDIA AI ソフトウェアと NVIDIA CUDA-X ライブラリが事前構成された DGX Sparkは、開発者、研究者、データサイエンティストが AI を構築、ファインチューニング、実行するための強力なプラグアンドプレイの最適化を提供します。

Spark は、すべての開発者が最新の AI モデルをデスクで実行するための基盤を提供します。Station は、企業や研究機関がより高度で大規模な最先端の AI モデルを実行できるようにします。これらのシステムは、最近発表された NVIDIA Nemotron 3 モデル を含む最新のフレームワークとオープンソースモデルをデスクトップから直接実行することをサポートします。

DGX Spark を支える NVIDIA Blackwell アーキテクチャには、AI モデルを最大 70 % 圧縮し、インテリジェンスを損なうことなくパフォーマンスを向上させる NVFP4 データ形式が含まれています。

llama.cpp との連携をはじめとするオープンソース ソフトウェア エコシステムとの NVIDIA の協業により、パフォーマンスはさらに向上し、DGX Spark で最先端の AI モデルを実行すると平均 35% のパフォーマンス向上が実現します。Llama.cpp には、LLM の読み込み時間を短縮する QOL アップグレードも含まれています。

DGX Station は、GB300 Grace Blackwell Ultra スーパーチップと FP4 精度の 775GB コヒーレントメモリを搭載し、最大 1 兆パラメータのモデルを実行できます。これにより、最先端の AI ラボはデスクトップから大規模モデルを実行できる最先端のコンピューティング能力を活用できます。これには、Kimi-K2 Thinking、DeepSeek-V3.2、Mistral Large 3、Meta Llama 4 Maverick、Qwen3、OpenAI gpt-oss-120b など、さまざまな高度な AI モデルが含まれます。

vLLM のコアメンテナーである Kaichao You 氏は次のように述べています。「NVIDIA GB300 は通常、ラックスケール システムとして導入されます。そのため、vLLM のようなプロジェクトでは、強力な GB300 スーパーチップ上で直接テストや開発を行うことが困難でした。DGX Station はこの状況を打破します。コンパクトなシングルシステムフォームファクターのデスクサイドで GB300 を提供することで、DGX Station は vLLM が GB300 固有の機能を大幅に低コストでテスト・開発することを可能にします。これにより開発サイクルが加速し、vLLM は GB300 に対する継続的な検証と最適化を容易に行うことができるのです」

SGLang のコミュニティ貢献者である Jerry Zhou 氏は次のように述べています。「DGX Station は、データセンタークラスの GPU 機能を私の部屋に直接もたらします。Qwen3-235B のような非常に大規模なモデルを処理し、大規模なモデル構成のトレーニングフレームワークをテストし、非常に大きな行列サイズの CUDA カーネルを開発するのに十分なパワーを備えています。これらはすべて、クラウドラックに依存せずにローカルで実行できます。これにより、システムとフレームワーク開発の反復ループが大幅に短縮されます」

NVIDIA は CES で DGX Station の機能をライブで紹介し、以下のデモを行います。

- 毎秒 25 万トークンという驚異的な速度で動作する LLM 事前トレーニング。

- カテゴリクラスター内の数百万のデータポイントを可視化する大規模データ。トピックモデリングワークフローでは、NVIDIA cuML ライブラリによって高速化された機械学習技術とアルゴリズムを採用。

- Text to Knowledge Graph と Llama 3.3 Nemotron Super 49B を使用、大規模な知識データベースを高精度に可視化。

AI とクリエイターのワークフローを拡張

DGX Spark と Station は、プロトタイピング、ファインチューニングから推論、データサイエンスまで、AI 開発ライフサイクル全体をサポートするように特別に設計されており、医療、ロボティクス、小売、クリエイティブワークフローなど、幅広い業界固有の AI アプリケーションに対応します。

クリエイター向けには、Black Forest Labs の FLUX.2 と FLUX.1、Alibaba の Qwen-Image といった最新の拡散モデルとビデオ生成モデルが NVFP4 をサポートし、メモリ使用量を削減してパフォーマンスを向上しています。また、Lightricks の新しい LTX-2 ビデオモデルもダウンロード可能になりました。NVIDIA GPU 用の NVFP8 量子化チェックポイントが含まれており、トップクラスのクラウドモデルに匹敵する品質を提供します。

CES のライブデモンストレーションでは、DGX Spark がクリエイター向けラップトップから要求の厳しいビデオ生成ワークロードをオフロードする方法が紹介されています。M4 Max を搭載した最上位 MacBook Pro と比較して 8 倍の高速化を実現し、ローカルシステムを解放して途切れのないクリエイティブワークを可能にします。

オープンソースの RTX Remix モッディングプラットフォームは、3D アーティストや MOD 開発者が DGX Spark を使用して生成 AI を活用し、より迅速に制作できるようになると期待されています。追加の CES デモでは、MODチームがアセット作成を全て DGX Spark にオフロードし、PC を MOD 作業に専念させられる様子を実演しました。これにより開発者は中断なく作業を進め、ゲーム内変更をリアルタイムで確認可能となります。

AI コーディングアシスタントは、開発者の生産性にも変革をもたらしています。CES では、NVIDIA は DGX Spark 上で NVIDIA Nsight を搭載したローカル CUDA コーディングアシスタントのデモを行いました。これにより、開発者はソースコードをローカルかつ安全に保管しながら、AI を活用したエンタープライズ開発のメリットを享受できます。

業界リーダーがローカル AI への移行を実証

エッジにおける安全で高性能な AI への需要が高まる中、DGX Spark は業界全体で勢いを増しています。

ソフトウェアリーダー、オープンソースのイノベーター、そして世界中のワークステーションパートナーが、DGX Spark を採用し、集中型インフラの複雑さを排除しながら、ローカル推論、エージェント型ワークフロー、そして検索拡張生成を実現しています。

彼らの視点は、DGX Spark がいかにして反復処理の高速化、データと IP のより優れた制御、そしてデスクトップ上でよりインタラクティブな新しい AI エクスペリエンスを実現するかを強調しています。

CES において、NVIDIA は Hugging Face Reachy Mini ロボットで DGX Spark の処理能力を活用し、AI エージェントを現実世界に導入する方法を実演します。

Hugging Face の製品担当副社長である Jeff Boudier 氏は次のように述べています。「オープン モデルは開発者に AI を独自の方法で構築する自由を与え、DGX Spark はそのパワーをデスクトップに直接もたらします。Reachy Mini に接続すると、ローカル AI エージェントが具現化し、独自の音声を獲得します。エージェントはあなたを見て、あなたの話を聞き、表情豊かな動きで応答します。これにより、強力な AI が真にインタラクションできるものへと変わるのです」

Hugging Face と NVIDIA は、DGX Spark と Reachy Mini を使用してインタラクティブな AI エージェントを構築するためのステップバイステップ ガイドを公開しました。

IBM のデータおよび AI プラットフォーム戦略担当バイスプレジデント、Ed Anuff 氏は次のように述べています。「DGX Spark はエッジに AI 推論をもたらします。Spark 上の OpenRAG により、ユーザーは抽出、埋め込み、検索、推論といった機能を備えた、包括的な自己完結型 RAG スタックをワンボックスで手に入れることができます」

JetBrains の CEO、Kirill Skrygan 氏は次のように述べています。「セキュリティ、ガバナンス、知的財産を完全に管理する必要がある組織にとって、NVIDIA DGX Spark はペタフロップス級の AI パフォーマンスを JetBrains のお客様に提供します。顧客がクラウド、オンプレミス、ハイブリッドのいずれの導入形態を希望されるとしても、JetBrains AI は顧客のニーズを満たすように設計されています」

都市交通向けに設計されたインテリジェントな自立型三輪一人乗り車両 TRINITY は、CES で展示されます。この車両は、オープンソースのリアルタイムビジョン言語モデルワークロードの AI 推論に、DGX Spark を AI 搭載の頭脳として採用しています。

will.i.am は次のように述べています。「TRINITY は、人間、車両、そして AI エージェントがシームレスに連携するマイクロモビリティの未来を体現しています。NVIDIA DGX Spark を AI 頭脳として搭載した TRINITY は、コネクテッドシティにおける人々とモビリティの関わり方を変革する、会話型の目標追跡ワークフローを提供します。まさにエージェントから設計された、車輪の上の頭脳と言えるでしょう」

AI 開発者の導入を加速

DGX Spark プレイブック は、開発者が実世界の AI プロジェクトを迅速に開始するのに役立ちます。CES において、NVIDIA は 6 つの新しいプレイブックと 4 つのメジャーアップデートを追加し、このライブラリを拡張します。これらのトピックは、最新の NVIDIA Nemotron 3 Nano モデル、ロボティクストレーニング、ビジョン言語モデル、2 つの DGX Spark システムを使用した AI モデルのファインチューニング、ゲノミクス、金融分析など多岐にわたります。

DGX Station は今年後半に提供開始予定で、開発者が NVIDIA GB300 システムを使い始めるためのプレイブックがさらに追加される予定です。

NVIDIA AI Enterprise ソフトウェアのサポートは、DGX Spark およびメーカーパートナーの GB10 システムで現在利用可能です。AI アプリケーション開発とモデルインストールのためのライブラリ、フレームワーク、マイクロサービス、GPU 最適化のためのオペレーターとドライバーを含む NVIDIA AI Enterprise は、迅速で信頼性の高い AI エンジニアリングと展開を実現します。ライセンスは 1 月末に提供開始予定です。

提供開始時期

DGX Spark およびメーカーパートナーの GB10 システムは、Acer、Amazon、ASUS、Dell Technologies、GIGABYTE、HP Inc.、Lenovo、Micro Center、MSI、PNY からご購入いただけます。

DGX Station は、2026 年春より ASUS、Boxx、Dell Technologies、GIGABYTE、HP Inc.、MSI、Supermicro からご購入いただけます。

DGX Spark の詳細については、こちらのテクニカルブログ をご覧ください。

ソフトウェア製品情報に関するお知らせもご覧ください。