Gamescom で発表された Amazing Seasun Games の『Mecha BREAK』は、より速くより適切な応答を実現する NVIDIA Nemotron-4 4B を含み ACE テクノロジを披露する初のゲームです。

本ブログは、AI をもっと身近なものにすることでこのテクノロジの謎を解き明かし、RTX PC や RTX ワークステーションのユーザー向けに新しいハードウェア、ソフトウェア、ツール、アクセラレーションについて紹介する『AI Decoded シリーズ』の最新号です。

Gamescom において、NVIDIA は、生成 AI によりデジタル ヒューマンに命を吹き込むテクノロジ スイートの NVIDIA ACE に、RTX AI によってローカルに駆動する、NVIDIA 初のオンデバイス小規模言語モデル (SLM) が追加されたことを発表しました。

Nemotron-4 4B Instruct と呼ばれるこのモデルは、より優れたロールプレイ、Retrieval-Augmented Generation、関数呼び出し機能を提供することで、ゲーム キャラクターがプレイヤーの指示をより直観的に理解してゲーマーに応答し、より正確で適切なアクションを実行できるようにします。

このモデルは、ゲーム開発者によるクラウドおよびオンデバイス展開用の NVIDIA NIM マイクロサービスとして利用できます。メモリ使用量が少なくなるように最適化されており、より速い応答時間を提供し、開発者は 1 億台以上の GeForce RTX 搭載 PC やノート PC、および NVIDIA RTX 搭載ワークステーションを活用できるようになります。

SLM の利点

AI モデルの精度とパフォーマンスは、トレーニングに使用するデータセットのサイズと品質に依存します。大規模言語モデルは膨大な量のデータでトレーニングされますが、通常は汎用的で、ほとんどの用途には過剰な情報が含まれています。

一方、SLM は特定のユース ケースに焦点を当てています。そのため、少ないデータでもより正確な応答をより迅速に提供することができます。これは、デジタル ヒューマンと自然に対話するために重要な要素です。

Nemotron-4 4B は、まず大規模な Nemotron-4 15B LLM から蒸留されました。このプロセスでは、「生徒」と呼ばれる小さなモデルが、「教師」と呼ぶに値する大きなモデルの出力を模倣する必要があります。このプロセスにおいて、生徒モデルの重要ではない出力が枝刈り (削除) され、モデルのパラメータ サイズが削減されます。その後、SLM は量子化され、モデルの重みの精度が低下します。

Nemotron-4 4B は、パラメータが少なく重みの精度が低いため、より大きな Nemotron-4 LLM よりメモリ フットプリントが小さく、最初のトークンまでの時間 (応答を開始できるまでの時間) が速くなる一方で、蒸留によりモデルの精度は高いレベルに維持されています。メモリ フットプリントが小さいということは、NIM マイクロサービスを統合するゲームやアプリが、現在ユーザーが所有している GeForce RTX AI PC やノート PC、および NVIDIA RTX AI ワークステーションの多くでローカルに実行できることを意味します。

この最適化された新しい SLM はまた、指示チューニングを使用して特別に構築されています。指示チューニングとは、特定のタスクをより適切に実行するために、指示プロンプトでモデルのファインチューニングを行う手法です。このテクノロジは、プレイヤーがメカニック ゲームのキャラクターと対話して、メカの交換やカスタマイズを行うように指示することができるビデオ ゲームの『Mecha BREAK』で実演されています。

ACE の切り札

ACE NIM マイクロサービスにより、開発者はクラウドまたは RTX AI PC およびワークステーション上で最新の生成 AI モデルを展開し、AI をゲームやアプリケーションに導入できます。ACE NIM マイクロサービスを使用すれば、ゲーム内でノンプレイヤー キャラクター (NPC) がリアルタイムでプレイヤーと動的にやり取りし、対話することができます。

ACE は、音声の文字起こし、言語、テキスト読み上げ、フェイシャル アニメーションのための主要な AI モデルで構成されます。また、モジュール式となっているため、開発者は特定のプロセスの各要素に必要な NIM マイクロサービスを選択することができます。

NVIDIA Riva の自動音声認識 (ASR) 機能は、ユーザーの話し言葉を処理し、AI を利用して非常に正確な文字起こしをリアルタイムで行います。このテクノロジは、GPU で高速化された多言語音声および翻訳マイクロサービスを使用して、完全にカスタマイズ可能な対話型 AI パイプラインを構築します。他にサポートされている ASR としては、英語の音声認識において人間レベルの堅牢性と精度に迫るオープンソースのニューラルネットである OpenAI の Whisper があります。

デジタル テキストに変換されると、その文字起こしデータは Google の Gemma、Meta の Llama 3、またはこの度の NVIDIA Nemotron-4 4B などの LLM に送られ、ユーザーの元の音声入力に対する応答の生成が開始されます。

次に、Riva のもう 1 つのテクノロジであるテキスト読み上げにより、音声応答が生成されます。ElevenLabs 独自の AI 音声テクノロジも、上記のデモで見られるように、ACE の一部としてサポートされ、披露されています。

さらに、NVIDIA Audio2Face (A2F) により、顔の表情が生成され、多言語での対話に同期させることができます。このマイクロサービスにより、デジタル アバターは、ライブ ストリーミングでも後処理でのベイクでも、動的かつリアルな感情を表現できます。

AI ネットワークは、選択された感情の範囲と強度レベルに合わせて、顔、目、口、舌、頭の動きを自動的にアニメーション化します。また、A2F は自動的にオーディオ クリップから直接感情を推測できます。

最後に、Unreal Engine や NVIDIA Omniverse プラットフォームのようなレンダラーで、完全なキャラクターまたはデジタル ヒューマンがアニメーション化されます。

NIM による機敏な AI

ACE では、NVIDIA およびサードパーティによるさまざまな AI モデルに対するモジュールのサポートに加えて、開発者がクラウド内または RTX AI PC およびワークステーション上でローカルに各モデルに対して推論を行うことができます。

NVIDIA AI Inference Manager ソフトウェア開発キットにより、開発、ワークロード、コストなど、さまざまなニーズに基づいたハイブリッド推論が実現できます。必要な AI モデル、エンジン、依存関係を PC に事前構成することで、PC アプリケーション開発者の AI モデルの展開と統合を効率化します。これにより、アプリやゲームは、PC やワークステーションからクラウドまでシームレスに推論を調整できます。

ACE NIM マイクロサービスは、クラウドでも、RTX AI PC およびワークステーション上のローカルでも実行できます。現在ローカルで実行されているマイクロサービスには、Covert Protocol 技術デモの Audio2Face、『Mecha BREAK』内の新しい Nemotron-4 4B Instruct と Whisper ASR があります。

無限の彼方へ

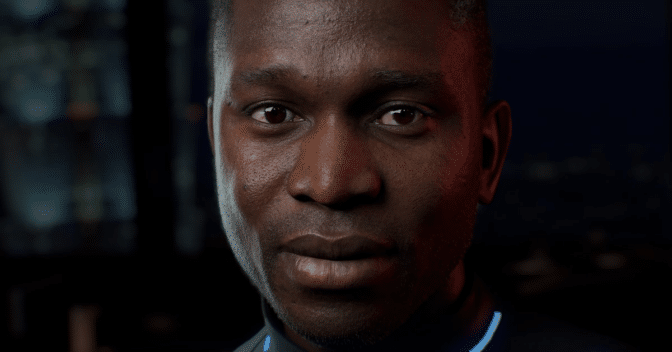

デジタル ヒューマンはゲーム内の NPC をはるかに超えています。SIGGRAPH カンファレンスで、NVIDIA は「James」のプレビューを行いました。これは、感情やユーモアなどを使用して人間とやり取りできるインタラクティブなデジタル ヒューマンです。James は、ACE を使用したカスタマーサービス ワークフローに基づいています。

ai.nvidia.com. での James との対話

ai.nvidia.com. での James との対話数十年にわたる人間とテクノロジとのコミュニケーション方法の変化は、最終的にデジタル ヒューマンの創造につながりました。人間とコンピューターのインターフェースは、親しみやすい顔を持ち、物理的な入力を必要としないものになるでしょう。

デジタル ヒューマンは、より魅力的で自然な対話を促進します。Gartner によれば、2025 年までに対話型サービスの 80% に生成 AI が組み込まれ、顧客向けアプリケーションの 75% に感情を伴う対話型 AI が組み込まれるとのことです。デジタル ヒューマンは、ゲーミングだけでなく、カスタマー サービス、ヘルスケア、小売り、テレプレゼンス、ロボティクスなど、複数の業界やユース ケースを変革します。

ai.nvidia.com で James とリアルタイムに対話すると、今すぐこの未来を垣間見ることができます。

生成 AI はゲーミングやビデオ会議など、あらゆるインタラクティブ体験に変革をもたらしています。AI Decoded ニュースレターに登録して、最新情報や今後の注目テクノロジをチェックしましょう。