企業のAIを守ることは、既存のセキュリティ対策を強化することから始まる旅です

ChatGPT をきっかけに、どの企業も AI 戦略に取り組んでいますが、セキュリティはどうでしょうか?

新しいテクノロジの安全を確保することには不安を感じる人もいるかもしれません。良いニュースは、現在実施されている方針と対策が、素晴らしい出発点となることです。

実際、企業やクラウドのセキュリティの既存の基盤を拡張することにこそ、前進の道があるのです。それは以下の 6 つのステップに要約できます。

- 脅威の分析を拡大する

- 応答メカニズムを広げる

- データ サプライチェーンを保護する

- AI を活用して取り組みを拡大する

- 透明性を保つ

- 継続的な改善を行う

広がる地平線

最初のステップは、新しい状況に慣れることです。

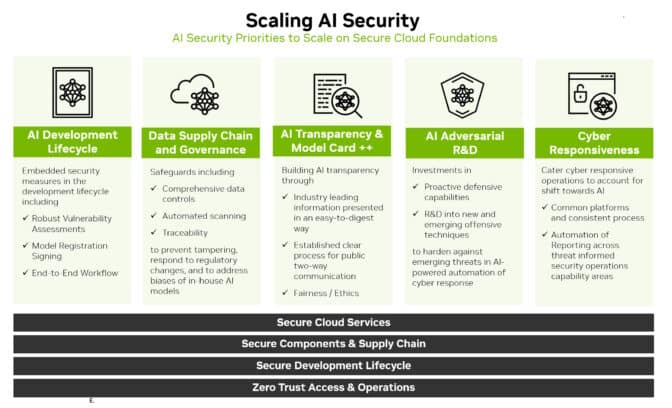

現在、セキュリティは AI 開発のライフサイクルをカバーする必要があります。これには、トレーニングデータ、モデル、それらを使用する人々やプロセスといった新たな攻撃対象も含まれます。

既知の脅威の種類から類推し、新たな脅威を特定し予測します。例えば、攻撃者はクラウドサービス上でモデルをトレーニングしている間にデータにアクセスし、 AI モデルの動作を変更しようとするかもしれません。

過去に脆弱性を探ったセキュリティ研究者やレッドチームは、再び大きなリソースとなるでしょう。新たな脅威を特定し対処するためには、AI システムやデータにアクセスする必要があり、またデータサイエンスの担当者との強固な協力関係を構築する手助けも必要でしょう。

防御の幅を広げる

脅威の全体像が明らかになったら、それに対する防御方法を定義します。

AI モデルのパフォーマンスを注意深く監視します。従来のセキュリティ防御が破られるときに想定されるように、AIがさまよいし、新たな攻撃対象が出現することを想定してください。

加えて、すでに実施されているはずの PSIRT(製品セキュリティ インシデント対応チーム)の実践を基本とします。

例えば、NVIDIA は AI ポートフォリオを網羅する製品セキュリティ ポリシーを発表しました。Open Worldwide Application Security Project を含むいくつかの組織は、従来のIT 脅威を特定するため、使用される一般的な脆弱性列挙手法など、主要なセキュリティ要素を AI に合わせて実装したものをリリースしています。

以下のような従来の防御方法を AI モデルやワークフローに適用しています。

- ネットワーク制御プレーンとデータプレーンの分離

- 危険なデータや個人を特定するデータの削除

- ゼロトラスト セキュリティと認証の使用

- 適切なイベントログ、アラート、テストの定義

- 適切なフロー制御の設定

既存のセーフガードを拡張

AI モデルの学習に使用するデータセットを保護します。データセットは貴重かつ脆弱です。

繰り返しになりますが、企業は既存の手法を活用することができます。ソフトウェアの安全を確保するために作られた時と同様に、安全なデータサプライチェーンを構築します。他の社内データが保護されているのと同様に、トレーニング データに対するアクセス コントロールを確立することが重要です。

ギャップを埋めなければならない場合もあります。今日、セキュリティの専門家は、アプリケーションのハッシュファイルを使用して、誰もコードを変更していないことを確認する方法を知っています。このプロセスを、 AI のトレーニングに使用されるようなペタバイトサイズのデータセットに拡大するのは難しいかもしれません。

良いニュースは、研究者がその必要性を認識し、それに対処するためのツール開発に取り組んでいることです。

AI でセキュリティを拡張

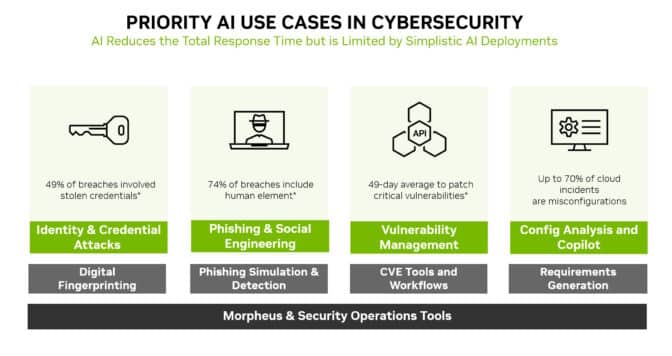

AI は防御すべき新たな攻撃対象であるだけでなく、新たな強力なセキュリティツールでもあります。

機械学習モデルは、ネットワーク トラフィックの山から人間には見えない微妙な変化を検出することができます。そのため AI は、個人情報の盗難、フィッシング、マルウェア、ランサムウェアなど、最も広く利用されている攻撃の多くを防止する理想的なテクノロジとなっています。

サイバーセキュリティ フレームワークである NVIDIA Morpheus は、多くの種類の脅威をスキャンするデジタル フィンガープリントを作成、読み取り、更新するAIアプリケーションを構築することができます。さらに、生成 AI と Morpheus は、スピアフィッシングの試みを検出する新しい方法を可能にします。

セキュリティは透明性が重要

透明性は、あらゆるセキュリティ戦略の重要な要素です。新たなAIのセキュリティの方針や対策を導入した場合は、顧客に知らせします。

例えば、NVIDIA はアクセラレーション ソフトウェアのハブである NGC の AI モデルの詳細を公開しています。モデルカードと呼ばれるこのカード(記述 AI )は、トレーニングされたデータとその使用に関する制約を示す、貸付真実法のような役割を果たします。

NVIDIA は、モデルカードに拡張されたフィールドセットを使用しているため、ユーザーはニューラルネットワークの履歴と限界について、実稼働させる前に明確に知ることができます。これは、セキュリティの向上、信頼の確立、モデルの堅牢性の確保に役立ちます。

目的地ではなく旅の過程を定義する

この6つのステップは旅の始まりに過ぎません。このようなプロセスや方針は進化していく必要があります。

例えば、コンフィデンシャル コンピューティングの新たな実践は、セキュリティを拡張している業界ではすでに、AI モデル用のコードスキャナーの基本バージョンが見られ始めています。これは今後への予兆です。チームは、ベストプラクティスやツールの登場を常に注視しておく必要があります。

その過程で、コミュニティは学んだことを共有する必要があります。その好例が、Generative Red Team Challengeでした。

最終的な目標は、集団的な防衛を構築することです。私たちは皆、AI セキュリティへの旅を共に歩み、一歩ずつ前進しています。