マイクロサービス、分析、シミュレーションなどでメインストリーム アプリケーションがエネルギー効率パフォーマンスを x86 の 2 倍に

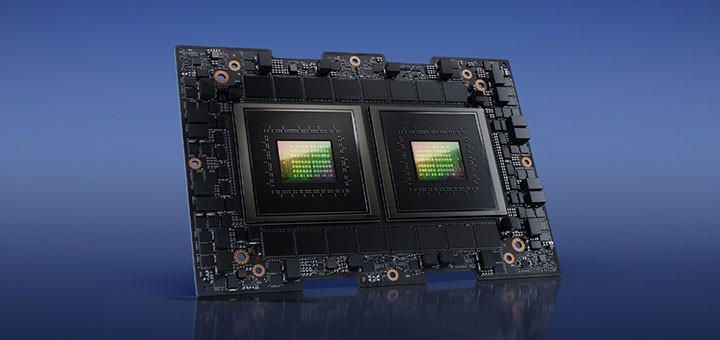

NVIDIA Grace CPU Superchip のテスト結果が、エネルギー効率の高いコンピューティングの新時代を示しています。

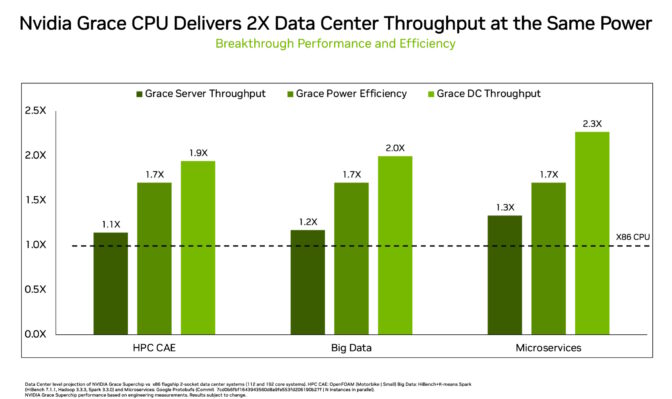

実際のワークロードのテストで、NVIDIA Grace CPU Superchip は、主要なデータセンター CPU アプリケーション全体で、同じ電力範囲で x86 プロセッサの 2 倍のパフォーマンス向上を記録しました。これにより、まったく新しい可能性が開かれることになります。

これはつまり、データセンターが 2 倍のピーク トラフィックを処理できることを意味し、電気料金を最大で半分に削減できます。ネットワークのエッジにある限られたスペースで、より多くの機能を詰め込むことができます。または上記のいずれかの組み合わせが可能になるでしょう。

データセンターの優先事項であるエネルギー効率

データセンターの管理者は、今日のエネルギー効率の高い時代で優れた運用をするため、これらのオプションを必要としています。

ムーアの法則は事実上通用しなくなりました。物理学的な理由から、エンジニアは同じ電力で同じスペースにより多くのトランジスタを詰めることができなくなりました。

そのため、新しい x86 CPU は通常、前世代モデルよりも 30% 未満しか性能が向上しません。これは電力制限されているデータセンターの数が増加し続ける理由でもあります。

地球温暖化の脅威が増す中、データセンターは能力を拡大する余裕はありませんが、コンピューティングに対する高まる需要に対応する必要があります。

求めるもの: 同じ電力、より高いパフォーマンス

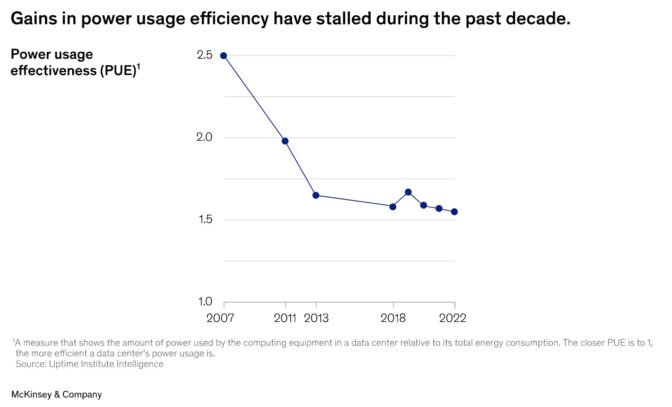

マッキンゼーの調査によると、コンピューティングの需要は米国で年率 10% 増加しており、2022 年から 2030 年までの 8 年間で 2 倍になる見込みです。

「このためデータセンターを持続可能にするための圧力は高く、一部の規制当局や政府は、新しく建設されたデータセンターに持続可能性基準を課しています」と、同調査は述べています。

ムーアの法則の終焉により、データセンターのコンピューティング効率の進歩は停滞していることが、マッキンゼーの調査で明らかになっています (下グラフ参照)。

今日の環境では、NVIDIA Grace がもたらす 2 倍の向上は、数世代の飛躍に相当する目を見張るものがあります。これは、今日のデータセンターの経営陣が求める要件を満たしています。

240 以上のデータセンターを管理するグローバル サービス プロバイダーである Equinix のエッジ インフラストラクチャの責任者、Zac Smith 氏は、エネルギー効率の高いコンピューティングに関する記事で、これらのニーズを明確に指摘しています。

「カーボン インパクトに対して得られるパフォーマンスこそ、我々が推進すべきものなのです」と彼は述べています。

「私たちにはこの旅に対する支援を求める 1 万もの顧客がいます。彼らは、多くの場合 AI を使用して、より多くのデータとインテリジェンスを求めており、それを持続可能な方法で必要としています」と付け加えています。

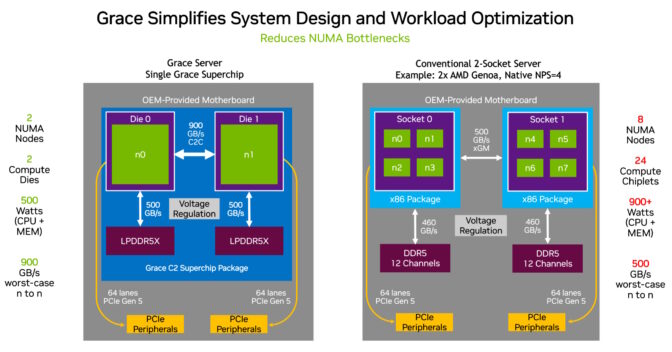

3 つの CPU イノベーション

Grace CPU は、3 つのイノベーションにより効率的なパフォーマンスを提供します。

超高速ファブリックを使用して、72 個の Arm Neoverse V2 コアを単一のダイに接続し、ファブリック二分帯域幅で毎秒 3.2 TB (スループットの標準測定値) を発揮します。次に、スーパーチップ パッケージ内の 2 つのダイを NVIDIA NVLink-C2C インターコネクトで接続し、毎秒 900 GB の帯域幅を提供します。

最後に、サーバークラスの LPDDR5X メモリを使用する最初のデータセンター CPU です。これにより、同様のコストで最大 50% 多いメモリ帯域幅が提供されますが、一般的なサーバー メモリの 8 分の 1 の電力で済みます。また、そのコンパクトなサイズにより、一般的なカードベースのメモリ設計の 2 倍の密度を可能にします。

最初の結果

NVIDIA のエンジニアは現在、Grace で実際のデータセンター ワークロードを実行しています。

彼らは、Grace と同じ電力フットプリントを使用するデータセンターの主要な x86 CPU と比較して、Graceについて次のことを発見しました。

- マイクロサービスの速度が 2.3 倍

- メモリ集約型のデータ処理が 2 倍高速化

- 多くの技術計算アプリで使用されている計算流体力学では 1.9 倍高速

データセンターは通常、これらの利点を得るために 2 世代以上の CPU を待つ必要があります。そのことは以下のグラフにまとめられています。

総合的なスループットの向上 (薄緑色) は、サーバー間の進歩 (濃緑色) と、Grace のエネルギー効率により x86 と同じ電力範囲に収まる Grace サーバーの追加分 (真ん中のグラフ) の積によって求められます。

総合的なスループットの向上 (薄緑色) は、サーバー間の進歩 (濃緑色) と、Grace のエネルギー効率により x86 と同じ電力範囲に収まる Grace サーバーの追加分 (真ん中のグラフ) の積によって求められます。稼働中の CPU でこれらの結果が出る前から、ユーザーは Grace のイノベーションに反応していました。

ロスアラモス国立研究所は 5 月に、材料科学や再生可能エネルギーなどの分野でラボの研究を進める 10 エクサフロップ AI スーパーコンピューターである Grace in Venado を使用すると発表しました。一方、ヨーロッパとアジアのデータセンターは、自らのワークロードで Grace を評価しています。

NVIDIA Grace は現在サンプル出荷中で、製品は今年後半に提供されます。ASUS、Atos、GIGABYTE、Hewlett Packard Enterprise、QCT、Supermicro、Wistron、ZT Systems が、Grace を搭載したサーバーを構築しています。

持続可能なコンピューティングについて深く知る

詳細については、Grace アーキテクチャに関するホワイトペーパーをお読みください。

先週開催されたNVIDIA GTC のセッション、Three Strategies to Maximize Your Organization’s Sustainability and Success in an End-to-End AI World で持続可能なコンピューティングの詳細をご覧ください。

NVIDIA BlueField DPU に関するホワイトペーパーを読み、エネルギー効率の高いネットワークを構築する方法を見つけてください。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE