NVIDIA H100 GPU が AI 推論の業界標準テストにおいて世界記録を樹立し、A100 GPUはメインストリーム パフォーマンスを牽引、さらに Jetson AGX Orin もエッジ コンピューティングをリード

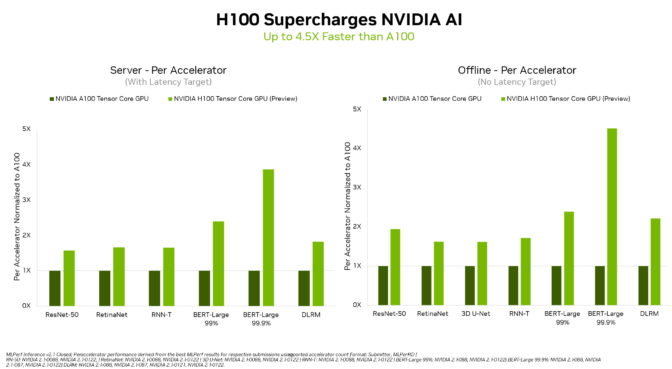

NVIDIA H100 Tensor コア GPU が、MLPerf 業界標準の AI ベンチマークでのデビューにおいて、すべてのワークロードの推論で世界記録を樹立し、前世代 GPU より最大 4.5 倍のパフォーマンスを実現しました。

この結果は、高度な AI モデルで最大限のパフォーマンスを求めるユーザーにとって、Hopper が最高の選択肢であることを示しています。

さらに、NVIDIA A100 Tensor コア GPU と AI 搭載ロボティクス用の NVIDIA Jetson AGX Orin モジュールは、すべての MLPerf テスト (画像と音声認識、自然言語処理、レコメンダー システム) で他をリードする推論パフォーマンスを引き続き実現しました。

H100、別名 Hopper は、今回のラウンドの 6 つのニューラル ネットワークすべてでアクセラレータあたりのパフォーマンスの基準を引き上げました。また、個別のサーバー シナリオおよびオフライン シナリオで、スループットと速度の両方でリードしていることを示しました。

NVIDIA Hopper アーキテクチャは、NVIDIA Ampere アーキテクチャ GPU よりも最大 4.5 倍のパフォーマンスを発揮し、MLPerf のすべてのテストの結果をリードし続けています。

Transformer Engine の搭載により、Hopper は自然言語処理の一般的な BERT モデルにおいて特に優れていました。これは、MLPerf AI モデルの中で最大かつ最もパフォーマンスを必要とするモデルの 1 つです。

これらの推論ベンチマークは、今年後半に利用可能になる H100 GPU の性能が初めて一般公開されたデモンストレーションです。H100 GPU は、今後の MLPerf のトレーニングのテストにも参加し、結果が提出される予定です。

A100 GPU がリーダーシップを発揮

主要なクラウド サービス プロバイダーおよびシステム メーカーから現在入手可能な NVIDIA A100 GPU は、最新のテストで、AI 推論のメインストリーム パフォーマンスにおいて引き続き全体をリードしました。

A100 GPU は、データセンターおよびエッジ コンピューティングのカテゴリとシナリオにおいて、他社製品よりも多くのテストで首位を獲得しました。6 月のMLPerf トレーニング ベンチマークでも、A100 は全体をリードし、AI ワークフロー全体においてその能力を実証しました。

2020 年 7 月に MLPerf でデビューして以来、A100 GPU は、NVIDIA AI ソフトウェアの継続的な改善により、パフォーマンスを 6 倍向上させました。

NVIDIA AI は、データセンターとエッジ コンピューティングですべての MLPerf 推論ワークロードとシナリオを実行する唯一のプラットフォームです。

ユーザーは多彩なパフォーマンスを必要としている

すべての主要な AI モデルをリードする NVIDIA GPU の能力により、ユーザーが真の勝者となります。実際のアプリケーションでは、通常、さまざまな種類の多くのニューラル ネットワークが採用されています。

たとえば、ある AI アプリケーションは、ユーザーの音声による要求を理解し、画像を分類し、レコメンデーションを行い、人間の声で音声メッセージとして応答する必要があります。各ステップには、異なるタイプの AI モデルが必要です。

MLPerf のベンチマークは、これらおよびその他の一般的な AI ワークロードとシナリオ (コンピューター ビジョン、自然言語処理、レコメンダー システム、音声認識など) を網羅しています。これらのテストにより、ユーザーは信頼性が高く柔軟に展開できるパフォーマンスを得られることが保証されます。

テストは透明で客観的であるため、ユーザーは MLPerf の結果を信頼して、情報に基づいた購入決定を下すことができます。ベンチマークは、Amazon、Arm、百度、Google、ハーバード大学、Intel、Meta、Microsoft、スタンフォード大学、トロント大学を含む幅広い企業や機関から支持されています。

Orin がエッジでリード

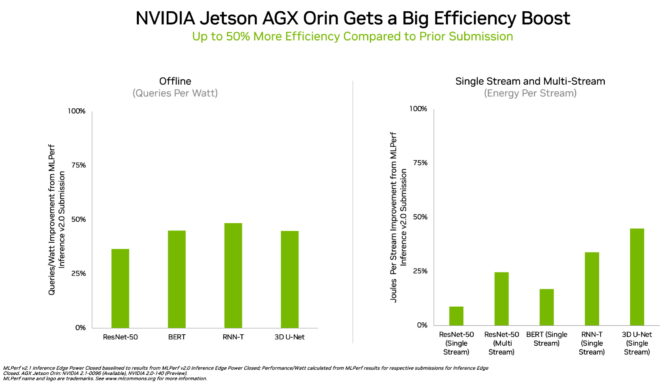

エッジ コンピューティングでは、NVIDIA Orin がすべての MLPerf ベンチマークを実行し、他のあらゆる低電力なシステム オン チップ (SoC) よりも多くのテストでトップの結果を獲得しました。また、4 月に MLPerf にデビューしたときと比較して、エネルギー効率が最大 50% 向上しました。

前回のラウンドでは、Orin は前世代の Jetson AGX Xavier モジュールよりも平均 2 倍のエネルギー効率と最大 5 倍の高速化を実現しました。

Orin は、NVIDIA Ampere アーキテクチャ GPU と強力な Arm CPU コアのクラスターをシングル チップに統合します。現在、NVIDIA Jetson AGX Orin 開発者キットおよびロボティクスや自律システム用の生産モジュールで利用可能です。自動運転 (NVIDIA Hyperion)、医療機器 (Clara Holoscan)、ロボティクス (Isaac) 向けのプラットフォームを含む完全な NVIDIA AI ソフトウェア スタックをサポートしています。

広範な NVIDIA AI エコシステム

MLPerf の結果は、NVIDIA AI が業界で最も広範な機械学習エコシステムに支えられていることを示しています。

このラウンドの 70 以上の提出結果が NVIDIA プラットフォーム上で実行されました。例えば、Microsoft Azureは同社のクラウド サービス上で NVIDIA AI を実行したテスト結果を提出しました。

さらに、ASUS、Dell Technologies、富士通、GIGABYTE、Hewlett Packard Enterprise、Lenovo、Supermicro を含む 10 社のシステム メーカーから 19 の NVIDIA-Certified Systemsがこのラウンドに参加しました。

これらの成果は、ユーザーがクラウドおよび独自のデータセンターで実行されているサーバーの両方で NVIDIA AI を使用して優れたパフォーマンスを得ることができることを示しています。

NVIDIA のパートナーが MLPerf に参加する理由は、MLPerf が AI プラットフォームやベンダーを評価する顧客にとって価値のあるツールだからです。最新のラウンドの結果は、現在ユーザーに提供しているパフォーマンスが NVIDIA プラットフォームによって向上することを示しています。

これらのテストに使用されたすべてのソフトウェアは MLPerf リポジトリから入手でき、誰でもこの世界クラスのパフォーマンスを得ることができます。NVIDIA の GPU アクセラレーテッド ソフトウェアのカタログである NGC で利用可能なコンテナーでは継続的な最適化が組み込まれています。今回、AI 推論を最適化するためにすべての提出結果で NVIDIA TensorRT が使用されていますが、こちらも NGC より入手することができます。

NVIDIA の MLPerf のパフォーマンスを支えているテクノロジについて、NVIDIA の技術ブログで詳しくご紹介しています。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE