NVIDIA Jetson AGX Orin は販売開始直後にもかかわらず、エッジでの AI の水準を引き上げ、業界の最新推論ベンチマークにおいてトップクラスにランクイン

NVIDIA Ampere アーキテクチャをベースとする低消費電力のシステムオンチップである NVIDIA Orin が、業界ベンチマークの MLPerf へのデビューを果たしました。Orin は AI 推論における新記録を樹立し、エッジでのアクセラレータあたりの性能の水準を引き上げました。

総じて、NVIDIA およびパートナー企業は、本稼働を想定した AI の業界指標の第 5 ラウンドで、機械学習の全ワークロードおよびシナリオを実行できる最高のパフォーマンスと非常に幅広いエコシステムを有していることを引き続き示しました。

エッジ AI では、量産前バージョンのNVIDIA Orin が 6 つの性能テストのうち 5 つでトップを記録しました。前世代の Jetson AGX Xavier と比較して最大 5 倍の速度で動作し、平均 2 倍のエネルギー効率を実現しています。

NVIDIA Orin は現在、ロボティクスおよび自律システム向けの NVIDIA Jetson AGX Orin開発者キットとして利用可能です。Amazon Web Services、John Deere、コマツ、Medtronic、Microsoft Azure など 6,000 以上の企業が、AI 推論やその他のタスクに NVIDIA Jetson プラットフォームを使用しています。

また、Orin は自動運転車向けの NVIDIA Hyperionプラットフォームの主要コンポーネントでもあります。中国における EV メーカーの最大手 BYD は、Orin ベースの DRIVE Hyperion アーキテクチャを次世代の自動 EVに採用することをつい先日発表しました。

Orin は、システム メーカーや研究者が次世代 AI 機器を開発するための医療デバイス向けプラットフォーム、NVIDIA Clara Holoscanの重要な構成要素でもあります。

小さなモジュール、大きなスタック

Jetson AGX Orin を含む NVIDIA GPU を搭載したサーバーとデバイスは、MLPerf の6種のベンチマークすべてを実行した唯一のエッジ アクセラレータです。

Orin は JetPack SDKを使用して、データ センターとクラウドにおいてすでに実績のあるソフトウェア スタックである NVIDIA AI の全プラットフォームを実行します。また、Orin は NVIDIA Jetson プラットフォームを使用している 100 万人の開発者に支えられています。

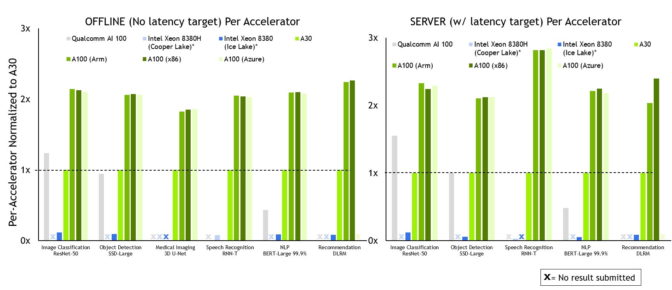

NVIDIA は、アクセラレータあたりの推論パフォーマンスですべてのテスト結果において優れており、すべてのワークロードにおいてテスト結果を提出している唯一の企業です。

NVIDIA は、アクセラレータあたりの推論パフォーマンスですべてのテスト結果において優れており、すべてのワークロードにおいてテスト結果を提出している唯一の企業です。脚注: MLPerf v2.0 Inference Closedの結果。アクセラレータあたりのパフォーマンスは、データセンターのオフラインおよびサーバーで報告済みのアクセラレータ数を使用して、各項目への提出における MLPerf の結果の最高値から取得しています。Qualcomm AI 100: 2.0-130、Intel Xeon 8380 (MLPerf v.1.1 時の提出物より引用): 1.1-023 および 1.1-024、Intel Xeon 8380H: 1.1-026、NVIDIA A30: 2.0-090、NVIDIA A100 (Arm): 2.0-077、 NVIDIA A100 (X86): 2.0-094。

MLPerf の名称およびロゴは商標です。詳細は、www.mlcommons.org をご覧ください。

NVIDIA とそのパートナー企業は、今回行われた MLPerf 推論ラウンドで、前回に続きすべてのテストとシナリオで優れた性能を発揮しています。

MLPerf ベンチマークは、Amazon、Arm、Baidu、Dell Technologies、Facebook、Google、Harvard、Intel、Lenovo、Microsoft、スタンフォード大学、トロント大学などの組織から幅広く支持されています。

より多くのパートナー企業が、より多くのテスト結果を提出

NVIDIA の広範なエコシステムに参加するパートナー企業の大多数が、MLPerf のテストを実行するうえで、今回も NVIDIA AI プラットフォームを選びました。

Azure は、12 月の MLPerf トレーニング テストにおいて着実なパフォーマンスでデビューを果たしましたが、今回のラウンドの AI 推論でも好成績を残しています。前回、今回ともに NVIDIA A100 Tensor コア GPU を使用しています。Azure の ND96amsr_A100_v4 インスタンスは、NVIDIA が提出し、最高のパフォーマンスを発揮した 8 種の GPU のテスト結果に匹敵する成績をほぼすべての推論テストで収めています。パブリック クラウドから簡単に利用可能な性能の高さを示しています。

システム メーカーの ASUS と H3C は、今回のラウンドへの提出結果に NVIDIA AI プラットフォームを使用し、MLPerf デビューを果たしました。これまで、Dell Technologies、富士通、GIGABYTE、Inspur、Lenovo、Nettrix、Supermicro といったシステム メーカーにより 20 を超える NVIDIA-Certified Systemsでの成果が提出されていますが、両社もここに加わることとなりました。

MLPerf が重要な理由

NVIDIA のパートナー企業が MLPerfに参加しているのは、MLPerf がAI プラットフォームやベンダーを評価するお客様にとって有用なツールであることを理解しているからです。

MLPerf では多様なテストが用意されており、現在最も一般的な AI ワークロードおよびシナリオを網羅しています。つまりユーザーは、このベンチマークは対象となるジョブの範囲全体で期待できるパフォーマンスを示すものであるという確信を得ることができます。

パフォーマンスの鍵はソフトウェア

NVIDIA のテストで使用したソフトウェアはすべて、MLPerf リポジトリから入手できます。

推論結果をもたらした 2 つの主要コンポーネント (AI モデルの最適化向けの NVIDIA TensorRTと、効率的な展開を可能にする NVIDIA Triton Inference Server) は、NVIDIA の GPU に最適化されたソフトウェア カタログである NGCから無料で入手できます。

Amazon や Microsoftなどのクラウド サービス プロバイダーをはじめとする、世界中の企業や機関が Triton を採用しています。

NVIDIA はこれからも、すべての最適化をコンテナに詰め込み、NGC で利用可能にしていきます。これによりユーザーのみなさまは、本番環境で AI を利用して優れたパフォーマンスを手にすることができます。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE