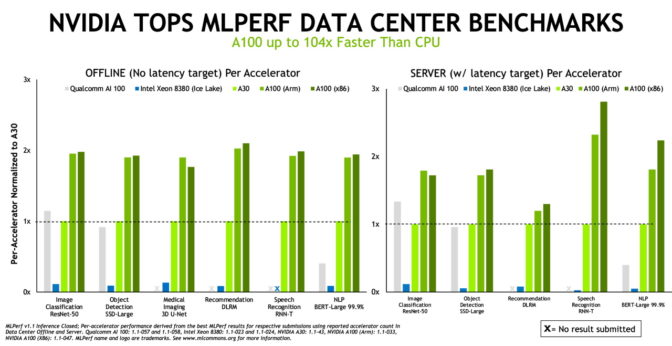

最新の MLPerf ベンチマークでは、NVIDIAがAI推論において、x86 コンピューターだけでなく Arm でも性能とエネルギー効率において高い水準を記録

最新のMLPerfのベンチマークによると、NVIDIAは、x86 と Arm ベースの CPU のどちらを使った場合でも AI 推論で最高の結果を収めています。

2018 年 5 月に設立された、業界のベンチマーク グループである MLCommons での推論テストにおいて、NVIDIA が性能とエネルギー効率で新記録を樹立するのは、これで 3 回連続となります。

また、データセンター カテゴリーでは、初めてArm ベースのシステムを使ってテストを行っており、今日における最も革新的なテクノロジであるAI の導入方法について、ユーザーの選択肢をさらに広げています。

テストの結果

NVIDIA AI プラットフォームを搭載したシステムは、直近の 7 つの推論の性能テストすべてで最高の成績を収めました。NVIDIAからのシステムに加え、Alibaba、Dell Technologies、富士通、GIGABYTE、Hewlett Packard Enterprise、Inspur、Lenovo、Nettrix、Supermicroを含むNVIDIAのエコシステムパートナー9社のシステムによるテスト結果が提出されています。

また、NVIDIA は、今回および過去の回ですべてのテスト結果を提出している、唯一の企業です。

推論は、コンピューターが AI ソフトウェアを実行して、物体の認識や予測をするときに行われます。このプロセスでは、ディープラーニングのモデルを使って、データのフィルタリングが行われ、人間ではなし得ない成果が導き出されます。

MLPerf の推論ベンチマークは、今日最も需要が高いAI のワークロードとシナリオに基づいたもので、コンピューター ビジョン、医用画像、自然言語処理、レコメンダー システム、強化学習などが対象となっています。そのため、どのような AI アプリケーションを導入する場合でも、ユーザーは NVIDIA のテクノロジによって、それぞれの新記録を樹立できるようになります。

パフォーマンスが重要な理由

AI モデルとデータセットは成長を続けており、AI のユースケースがデータセンターからエッジ、およびその先にまで拡大しています。そのため、ユーザーは安心かつ柔軟に導入できる性能を求めています。

MLPerf は、ユーザーが確信を持って購入の判断を下すための情報を提供しています。また、MLPerf は、Alibaba、Arm、Baidu、Google、Intel および NVIDIA をはじめとする、業界の数十のリーダー企業から支持されています。そのため、テストは透明性があり、客観的になっています。

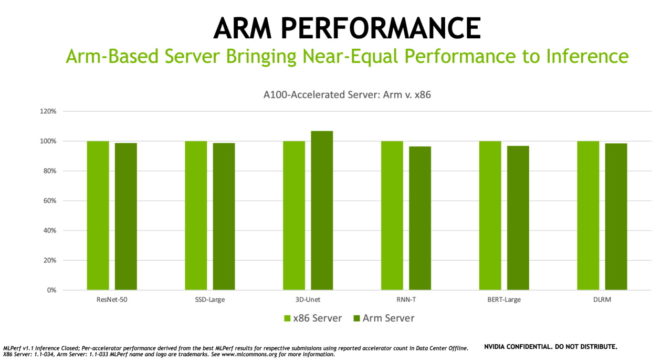

エンタープライズ AI での Arm の活用

Arm アーキテクチャは世界中のデータセンターで導入が進んでいますが、その主な理由としては、エネルギー効率の良さ、性能の向上、ならびにソフトウェア エコシステムの拡大があります。

最新のベンチマークでは、GPU アクセラレーテッド プラットフォームとして、の Ampere Altra CPUを 搭載した Arm ベースのサーバーが、同じような構成の x86 ベースのサーバーにほぼ匹敵する性能を AI 推論の処理で発揮できることが示されています。実際、テストの 1 つで、Arm ベースのサーバーが同様の構成の x86 システムを上回る性能を発揮しました。

NVIDIA は、あらゆる CPU アーキテクチャに対応してきた長い実績があり、同業者が審査を行うベンチマークでArm が AIの優れた能力を示したことは誇らしく思います。

ArmのHPCおよびツール部門のシニア ディレクターであるデイビッド ルコンマー(David Lecomber)氏は、以下のように述べています。「Armは、MLCommonsの創設メンバーとして、アクセラレーテッド コンピューティング業界における課題により良く対処し、イノベーションを鼓舞するための標準やベンチマークを作成するプロセスに取り組んでいます。

最新の推論結果は、ArmベースのCPUとNVIDIA GPUを搭載したArmベースのシステムが、データセンターにおける広範なAIワークロードに対処可能であることを示しています」

パートナーも AI パワーを実証

NVIDIA の AI テクノロジは、拡大を続ける大規模なエコシステムから支持されています。

直近のベンチマークでは、7 つの OEM 企業が、合計 22 の GPU アクセラレーテッド プラットフォームを活用したテスト結果を提出しています。これらのサーバー モデルのほとんどはNVIDIAによって認証されたシステムであり、多様なアクセラレーテッド ワークロードを実行するための検証を受けています。また、それらの多くは、先月公式にリリースされたソフトウェアである、NVIDIA AI Enterprise に対応しています。

今回のベンチマークに参加した、NVIDIA のパートナーには、Dell Technologies、富士通、Hewlett Packard Enterprise、Inspur、Lenovo、Nettrix および Supermicro などのメーカー、ならびにクラウドサービス プロバイダーの Alibaba があります。

ソフトウェアのパワー

あらゆるユースケースで NVIDIA の AI が成功を収めている主な理由の 1 つは、フルスタックのソフトウェアにあります。

たとえば推論では、多様なユースケースを想定した、トレーニング済みの AI モデルを提供しています。NVIDIA TAO Toolkit を使えば、転移学習を使用して、特定のアプリケーションのために、これらのモデルをカスタマイズすることができます。

また、NVIDIA TensorRT ソフトウェアによって、メモリを効率よく活用し、より速く動作するように AI モデルを最適化することができます。NVIDIA は、MLPerf のテストでこのソフトウェアをつねに使用しており、x86 と Arm ベースのシステムのどちらでも、このソフトウェアは利用できます。

また、これらのベンチマークでは、NVIDIA Triton Inference Server ソフトウェアと Multi-Instance GPU (MIG) 機能も採用しました。これらのソフトウェアと機能により、あらゆる開発者が、通常はコードに関するエキスパートを必要とするような性能を得られるようになります。

このソフトウェア スタックの継続的な改善が功を奏し、NVIDIA は、わずか 4 か月前に行われた前回の MLPerf 推論ベンチマークに比べて、性能を 20%、エネルギー効率を 15% 向上させることができました。

直近のテストで使用されたすべてのソフトウェアは MLPerf のリポジトリで入手できるので、誰でもベンチマークでの結果を再現することができます。NVIDIA では、GPU アプリケーションのためのソフトウェア ハブである NGC で利用できる、ディープラーニングのフレームワークとコンテナに、このようなコードを継続的に追加しています。

これらは、フルスタックの AI 機能の一部であり、すべての主要なプロセッサ アーキテクチャに対応しており、最新の業界ベンチマークで実証されています。今すぐ実際の AI の処理に利用することができます。

NVIDIA推論プラットフォームの詳細については、「NVIDIA Inference Technology Overview(NVIDIA推論技術概要)」をご覧ください。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE