新しい業界標準ベンチマークでは、クラウド サービス プロバイダーの CoreWeave の 3,584 基の H100 GPU のクラスタが、GPT-3 ベースの大規模モデルをわずか 11 分でトレーニング

主要なユーザーと業界標準のベンチマークは一致しています:NVIDIA H100 Tensor コアGPU は、特に生成 AI を動かす大規模言語モデル (LLM) において、最高の AI 性能を発揮します。

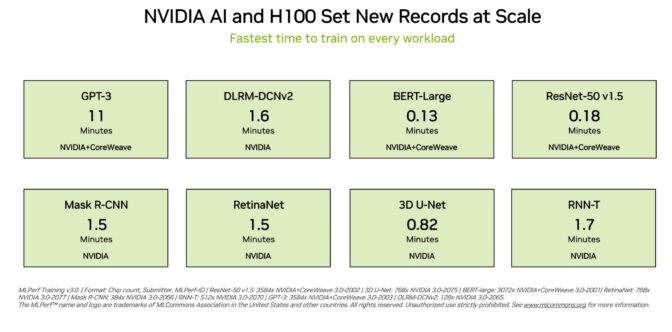

H100 GPU は、本日発表された最新の MLPerf トレーニング ベンチマークの 8 つのテストすべてで新記録を樹立し、生成 AI 向けの新しい MLPerf テストで優れた結果を示しました。その卓越性は、アクセラレータ単位でも、大規模サーバーでも発揮されています。

たとえば、スタートアップの Inflection AI が共同開発し、GPU アクセラレーテッド ワークロードを専門とするクラウド サービス プロバイダーである CoreWeave が運用する 3,584 基の H100 GPU からなる商用クラスタ上では、GPT-3 ベースの大規模なトレーニング ベンチマークを 11 分足らずで完了させました。

CoreWeave の共同創業者兼 CTO である Brian Venturo 氏は次のように述べています。「当社の顧客は、高速で低遅延の InfiniBand ネットワーク上にある数千の H100 GPU のおかげで、最先端の生成 AI と大規模言語モデルを構築しています。NVIDIA と共同で提出した MLPerf は、当社の顧客が享受している素晴らしいパフォーマンスを明確に示しています」

本日発表されたトップ パフォーマンス

Inflection AI は、その性能を利用して、同社初のパーソナル AIである Pi (Personal Intelligence) を支える高度な大規模言語モデルを構築しました。同社は AI スタジオとして、ユーザーがシンプルで自然な方法で対話できるパーソナル AI を作成しています。

Inflection AI の CEO である Mustafa Suleyman 氏は次のように述べています。「CoreWeave の H100 GPU の強力なネットワークでトレーニングされた最先端の大規模言語モデルに基づいて、誰でも今日からパーソナル AI の力を体験することができます」

Inflection AI は、2022 年の初頭に DeepMind の Mustafa 氏と Karén Simonyan 氏、Reid Hoffman 氏によって共同創業されました。CoreWeave と協力して NVIDIA GPU を使用した世界最大級のコンピューティング クラスタの構築を目指しています。

データ比較

これらのユーザー体験は、本日発表された MLPerf ベンチマークで実証された性能を反映しています。

H100 GPU は、大規模言語モデル、レコメンダー、コンピュータ ビジョン、医用画像、音声認識を含むすべてのベンチマークで最高の性能を発揮しました。8 つのテストすべてを実行した唯一のチップであり、NVIDIA AI プラットフォームの汎用性を実証しました。

優れた拡張性

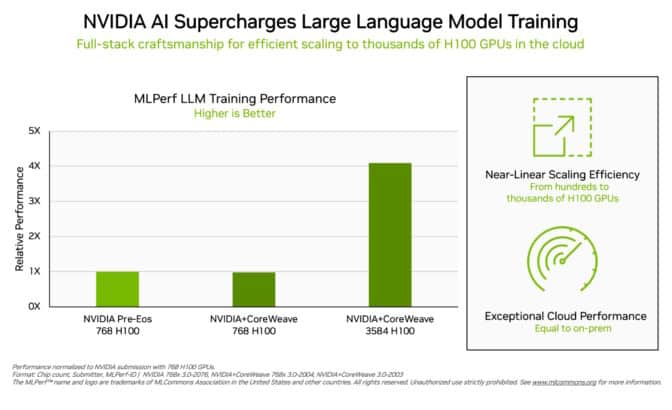

トレーニングは通常、多くの GPU が連携して大規模に実行される作業です。すべての MLPerf テストにおいて、H100 GPU は AI トレーニングの大規模な性能の新記録を樹立しました。

完全なテクノロジ スタック全体にわたる最適化により、要求の厳しい LLM テストにおいて、H100 GPU の数が数百から数千へと増加するにつれて、ほぼ直線的な性能スケーリングが可能になりました。

さらに、CoreWeave は、NVIDIA がローカルのデータセンターで動作する AI スーパーコンピュータから達成したのと同等のパフォーマンスをクラウドから提供しました。これは、CoreWeave が使用する NVIDIA Quantum-2 InfiniBand ネットワーキングが、低遅延ネットワークである証しです。

今回、MLPerf はレコメンダー システムのベンチマークも更新しました。

新しいテストでは、クラウド サービス プロバイダーが直面する課題をよりよく反映するために、より大規模なデータセットとより最新の AI モデルを使用しています。NVIDIA は、強化されたベンチマークの結果を提出した唯一の企業でした。

拡大する NVIDIA AI エコシステム

今回のラウンドでは、12 社が NVIDIA プラットフォームで結果を提出しました。これらの成果は、NVIDIA AI が機械学習における業界で最も広範なエコシステムに支えられていることを示しています。30 件以上の申請が H100 GPU で実行されました。

このレベルの参加により、ユーザーはクラウドと自社のデータセンターで稼働しているサーバーの両方で、NVIDIA AI で優れたパフォーマンスを得られることが分かります。

すべてのワークロードにおけるパフォーマンス

NVIDIA のエコシステム パートナーは、MLPerf が AI プラットフォームやベンダーを評価する顧客にとって貴重なツールであることを知っているため、MLPerf に参加しています。

ベンチマークは、生成 AI やレコメンダー システムに加え、コンピュータ ビジョン、翻訳、強化学習など、ユーザーが関心を寄せるワークロードを網羅しています。

MLPerf のテストは透明性が高く客観的であるため、ユーザーは MLPerf の結果を信頼し、十分な情報に基づいた購買決定を行うことができます。このベンチマークは、Arm、Baidu、Facebook AI、Google、Harvard、Intel、Microsoft、Stanford、University of Toronto を含む幅広いグループから支持を得ています。

MLPerf の結果は、H100、L4、NVIDIA Jetson の各プラットフォームで、AI トレーニング、推論、HPC の各ベンチマークにおいて本日公開されました。今後の MLPerf ラウンドでは、NVIDIA Grace Hopper システムでの提出を予定しています。

エネルギー効率の重要性

AI の性能要件が高まるにつれ、その性能を達成する方法の効率を拡大することが不可欠です。それがアクセラレーテッド コンピューティングです。

NVIDIA GPU で高速化されたデータセンターは、使用するサーバー ノードの数が少ないため、ラック スペースとエネルギーの使用量が少なくて済みます。さらに、高速化されたネットワークは、効率とパフォーマンスを向上させ、継続的なソフトウェアの最適化は、同じハードウェア上で数倍の向上をもたらします。

エネルギー効率に優れたパフォーマンスは、地球にとってもビジネスにとっても有益です。パフォーマンスが向上すれば、市場投入までの時間が短縮され、企業はより高度なアプリケーションを構築できるようになります。

NVIDIA GPU で高速化されたデータセンターは、使用するサーバー ノードの数が少ないため、エネルギー効率はコスト削減にもつながります。実際、最新の Green500 リストに掲載されている上位 30 のスーパーコンピュータのうちの 22 に NVIDIA GPU が搭載されています。

誰でも使えるソフトウェア

NVIDIA AI プラットフォームのソフトウェア レイヤーである NVIDIA AI Enterprise は、主要なアクセラレーテッド コンピューティング インフラストラクチャ上で最適化されたパフォーマンスを可能にします。このソフトウェアには、企業のデータセンターで AI を実行するために必要なエンタープライズ グレードのサポート、セキュリティ、信頼性が備わっています。

これらのテストに使用されたソフトウェアはすべて MLPerf リポジトリから入手できますので、事実上誰でもこれらの世界トップクラスの結果を得ることができます。

最適化は、NVIDIA の GPU アクセラレーテッド ソフトウェアのカタログである NGC で利用可能なコンテナに継続的に組み込まれます。

こちらの技術ブログでは、NVIDIA の MLPerf のパフォーマンスと効率性を高める最適化について詳しく解説しています。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE