「驚異的な」GPU クラスタがAutopilotと完全自動運転向けの AI 開発能力を提供

今日における最大級のコンピューティング課題に取り組むには、強大なコンピューティング能力が必要です。

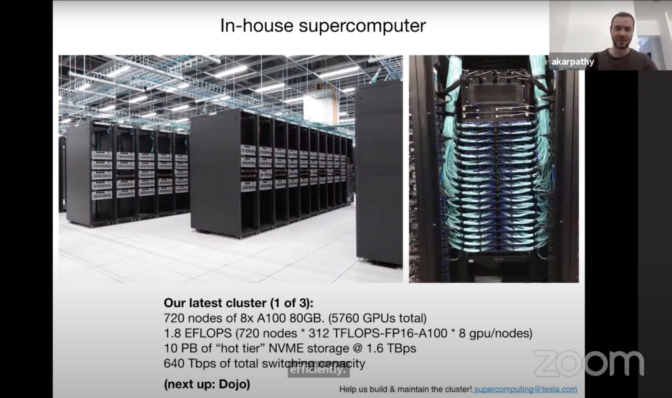

Computer Vision and Pattern Recognition (CVPR) で、Teslaの AI 担当シニア ディレクターであるアンドレイ カルパシー (Andrej Karpathy) 氏は、同社がAutopilotおよび自動運転機能向けのディープ ニューラル ネットワーク (DNN) をトレーニングするために使用している、自社スーパーコンピューターについて明らかにしました。このクラスターは、業界最高水準の 1.8 エクサフロップスの性能を実現するために、8基のNVIDIA A100 Tensor コア GPUを搭載するノードを 720 台 (合計 5,760 基の GPU) 使用しています。

カルパシー氏は、次のように述べています。「これは本当に素晴らしいスーパーコンピューターです。フロップスに関して言えば、世界でおおよそ 5 位のスーパーコンピューターと言えるでしょう。」

自動車業界では前例のないレベルのコンピューティング能力を開発サイクルの中心に据え、Tesla は自動運転車のエンジニアが効率的かつ最先端の技術でライフワークに取り組めるようにしています。

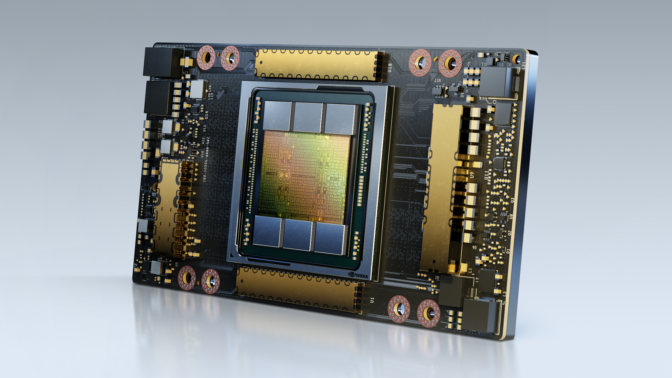

NVIDIA A100 GPU は、世界最高性能のデータセンターを実現するためにあらゆる規模のアクセラレーションを提供します。NVIDIA Ampere アーキテクチャを採用する A100 GPU は、前世代と比較して最大 20 倍の性能を提供し、7 つの GPU インスタンスに分割することで、需要の変化に動的に対応することができます。

この GPU クラスタは、Tesla の自動運転に対する垂直統合型アプローチの一部であり、すでに路上を走行している 100 万台を超える車両を用いて新しい機能を洗練させ、構築し、継続的に改善を行っています。

車両からデータセンターへ

Tesla の循環型開発は、車両から始まります。「シャドウ モード」で動作するディープ ニューラル ネットワークは、車両走行中に静かに認識し、予測を立てますが、実際に車両を制御することはありません。

予測は記憶され、間違いや誤認はすべてログに記録されます。次に、これらのインスタンスを使用して、Tesla のエンジニアが難易度の高い多様なシナリオのトレーニング データセットを作成し、DNN の精度向上を目指します。

その結果、36 フレーム/秒 (fps) で記録された 10 秒間のクリップがおよそ 100 万点、実に 1.5 ペタバイトに上るデータ集ができあがります。これらのシナリオを DNN がデータセンターで実行し、1 つのミスもなく動作するまで何度も繰り返します。最後に DNN を車両に送り返し、一連のプロセスを再び開始します。

カルパシー氏は、このような手法で、これほど大量のデータを基に DNN をトレーニングするには、「膨大なコンピューティング」が必要だと述べており、このため Tesla は、高性能な A100 GPU を搭載する現世代のスーパーコンピューターの構築と活用に踏み切りました。

継続的な反復処理

包括的なトレーニングに加え、Tesla のスーパーコンピューターは、自動運転車のエンジニアが開発プロセスにおいて実験や反復作業を行うために必要な性能を提供します。

カルパシー氏は、同社が展開している現在の DNN の構造では、20 人のエンジニアを有するチームが同時に単一のネットワークを扱い、さまざまな機能を分離して並列に開発できると述べています。

これらの DNN は、これまでよりも高速にトレーニング データセットを実行できるので、迅速な反復作業が可能になります。

カルパシー氏は次のように述べます。「コンピューター ビジョンは、私たちの仕事の根幹であり、Autopilotを可能にします。機能するためには、大規模なニューラル ネットワークをトレーニングし、数多くの実験を重ねる必要があります。だからこそ、私たちはコンピューティングに多額の投資を行ってきたのです。」

CVPR セッションのフルバージョンについては、こちらをご覧ください。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE