GTC の最初に、運輸やヘルスケアから金融、エンターテインメントに至るまで、幅広い業界に影響を与える自然言語理解、メタバース、ゲーミング、および AI テクノロジの進歩についてジェンスン フアンが明らかに

NVIDIA の CEO であるジェンスン フアン (Jensen Huang) は、本日の GTC 基調講演で、新しいシステム、シリコン、ソフトウェアに関する多くの情報を紹介し、とりわけ AI ワークフローをサポートする新しいクラウド サービスと新世代の GeForce RTX GPU について発表しました。

フアンは、NVIDIA GTC の開幕にあたり、バーチャル プレゼンテーションで次のように話しました。「コンピューティングは信じられないほどの速度で進化し続けています。このロケットを推進しているエンジンはアクセラレーテッド コンピューティングであり、その燃料は AI です。」

フアンは何度も、新しいテクノロジと新しい製品、そして新しいチャンスとの関連性を強調しました。AI を活用して今までにないグラフィックスでゲーマーを喜ばせることから、世界の大企業が製品を改良するためのバーチャルの検証場を構築することまで、新しいテクノロジの使い方は多岐にわたります。

アクセラレーテッド コンピューティングという単一のビジョンが、新しいアイデア、新しい製品、新しいアプリケーションを大量に生み出す原動力となっています。これが AI の進歩を解き放ち、ひいては世界中の産業に影響を及ぼすことになるでしょう。

まずはゲーマーやクリエイターが、新しい NVIDIA Ada Lovelace アーキテクチャを採用した最初の GPU を手に入れることができます。

企業は、Grace CPU と Grace Hopper Superchip をベースとするシステムで、ハイパフォーマンス コンピューティング アプリケーション用の強力な新しいツールを手に入れることになります。3D インターネットを構築する人々は、Ada Lovelace L40 データセンター GPU を搭載した新しい OVX サーバーを手に入れるでしょう。研究者やコンピューター科学者は、NVIDIA LLM NeMoサービスによって、新しい大規模言語モデルの機能を手に入れます。そして自動車産業は、2,000 TFLOPS という驚異的な性能を誇る新しい頭脳である Thor を手に入れます。

フアンは、NVIDIA のテクノロジが、さまざまな業界の主要なパートナーや顧客によって幅広く導入されていることを力説しました。

世界最大規模の専門サービス会社である Deloitte が、NVIDIA AI と NVIDIA Omniverse をベースとする新サービスを各国の企業に提供し、採用を加速させていることも発表しました。

また、通信大手の Charter をはじめ、自動車業界の General Motors、運輸業界からはドイツの鉄道会社である Deutsche Bahn、医学研究分野の The Broad Institute、小売業の Lowe’s といったお客様の事例も紹介しました。

先週開催された NVIDIA GTC は、現在では世界で最も重要な AI カンファレンスの 1 つとなっており、Boeing、ドイツ銀行、Lowe’s、Polestar、Johnson & Johnson、Kroger、Mercedes-Benz、Siemens AG、T-Mobile、米国銀行といった企業から 200 人以上が講演を行いました。このカンファレンスには 20 万人以上が申し込み登録を行っています。

「大きな飛躍」: GeForce RTX 40 シリーズ GPU

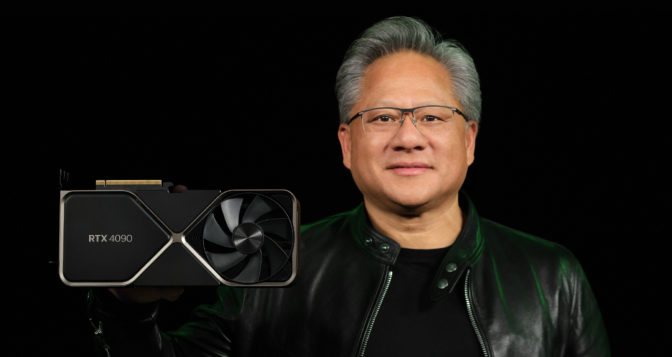

基調講演で最初に発表されたのは、Ada を採用した次世代の GeForce RTX 40 シリーズ GPU です。フアンは、このテクノロジのことを、クリエイターのために完全にシミュレーションされた世界への道を開く「大きな飛躍」であると形容しました。

NVIDIA CEO のジェンスン フアンは、次世代の GeForce RTX 40 シリーズ GPU を発表しました。

NVIDIA CEO のジェンスン フアンは、次世代の GeForce RTX 40 シリーズ GPU を発表しました。 フアンは、すべてのアクションが物理的にモデル化され、完全にレイ トレーシングされたインタラクティブなシミュレーションである『Racer RTX』を披露し、このテクノロジが何を実現できるのかの一端を紹介しました。

Ada の新機能には、新しいストリーミング マルチプロセッサ、2 倍のレイ トライアングル交差スループットを実現する新しい RT コア、そして Hopper FP8 Transformer エンジンと 1.4 PFLOPS の Tensor プロセッサ パワーを備えた新しい Tensor コアが含まれています。

また Ada は、NVIDIA DLSS テクノロジの最新バージョンである DLSS 3 を導入します。このテクノロジは、AI を使って新しいフレームを前のフレームと比較し、シーンがどのように変化しているかを理解することによって新しいフレームを生成します。その結果、力ずくのレンダリングと比べて、ゲームのパフォーマンスを最大 4 倍も高めることができます。

DLSS 3 は、世界の主要なゲーム開発者の多くから支持を得ており、35 を超えるゲームやアプリケーションがサポートすることを表明しています。「DLSS 3 は、私たちが発明したニューラル レンダリング テクノロジの中でも特に優れたものの 1 つです」とフアンは述べました。

これらのイノベーションを組み合わせた新しい GeForce RTX 4090 は、前世代の RTX 3090 Ti と比べて 4 倍の処理スループットを実現できるとフアンは説明しました。この「新しいヘビー級チャンピオン」の価格は 1,599 ドルからで、10 月 12 日に発売される予定です。

さらなる新しい GeForce RTX 4080 は、11 月に 2 つの構成で発売予定です。

価格が 1,199 ドルの GeForce RTX 4080 16GB は、9,728 の CUDA コアと 16GB の高速な Micron GDDR6X メモリを搭載しています。DLSS 3 の採用により、現在のゲームでは GeForce RTX 3080 Ti の 2 倍高速で、GeForce RTX 3090 Ti よりも低消費電力でパワフルな性能を発揮します。

GeForce RTX 4080 12GB は、7,680 の CUDA コアと 12GB の Micron GDDR6X メモリを搭載しており、DLSS 3 の採用により、前世代のフラッグシップ GPU である RTX 3090 Ti よりも高速に動作します。価格は 899 ドルです。

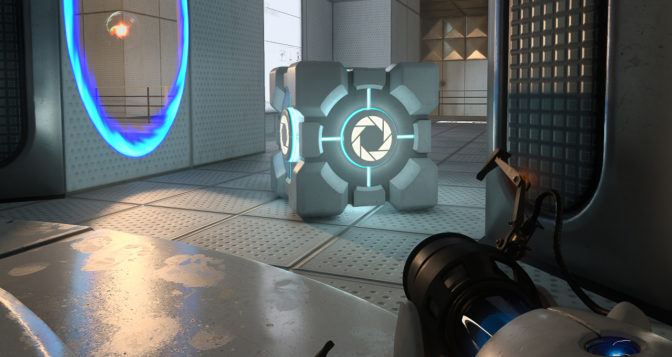

フアンはまた、NVIDIA Lightspeed Studios が Omniverseを使用して、歴史上最も高く評価されているゲームの 1 つである『Portal』をリマスターしたことを発表しました。AI 支援のツールセットである NVIDIA RTX Remix を使えば、ユーザーはお気に入りのゲームの MOD を作成し、テクスチャやアセットを高解像度化したり、マテリアルに物理的に正確なプロパティを付与したりすることが可能になります。

NVIDIA Lightspeed Studios が Omniverse を使用して、歴史上最も高く評価されているゲームの 1 つである『Portal』をリマスターしました。

NVIDIA Lightspeed Studios が Omniverse を使用して、歴史上最も高く評価されているゲームの 1 つである『Portal』をリマスターしました。AI の進化を後押しする H100 GPU が量産開始

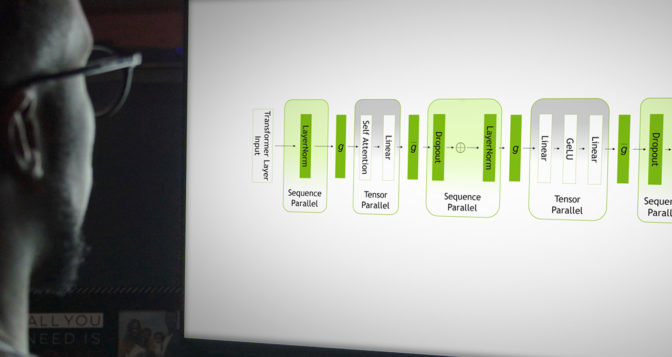

フアンは、システムおよびソフトウェアと広範なテクノロジのトレンドとの関連性を改めて解説しながら、今日特に重要な 2 つの AI モデルとして大規模言語モデル (LLM) とレコメンダー システムを挙げました。

フアンによれば、レコメンダーは、「デジタル経済を動かして」おり、e コマースからエンターテインメント、広告に至るあらゆるものに使われています。「ソーシャル メディア、デジタル広告、e コマース、検索等を支えるエンジンなのです。」

そして、2017 年に初めて発表された Transformer ディープラーニング モデルに基づく大規模言語モデルは、現在、AI 研究において最も活気のある分野の 1 つとなっており、教師やラベル付きデータセットがなくても学習を行い、人間の言語を理解することが可能です。

「単一の事前トレーニング済みモデルにより、質問応答、文書要約、テキスト生成、翻訳、さらにはソフトウェア プログラミングなどの複数のタスクを実行することができます」とフアンは述べています。

フアンによれば、これらの巨大なモデルを動かすために必要な演算能力を提供する、Hopper の次世代 Transformer エンジンを搭載した NVIDIA H100 Tensor コア GPU は、すでに量産が始まっており、今後数週間のうちに搭載されたシステムが出荷開始される予定です。

「Hopper を量産中です。まもなく提供が開始され、世界の AI ファクトリーを動かしていくことになるでしょう」とフアンは語ります。

システムを構築するパートナーは、Atos、Cisco、Dell Technologies、富士通、GIGABYTE、Hewlett Packard Enterprise、Lenovo、Supermicro などです。また、Amazon Web Services、Google Cloud、Microsoft Azure、および Oracle Cloud Infrastructure が、来年から H100 ベースのインスタンスをいち早くクラウドに展開する予定です。

さらに、NVIDIA の Arm ベースの Grace データセンター CPU と Hopper GPU を組み合わせた Grace Hopper は、高速なメモリ容量を 7 倍に拡大し、レコメンダー システムに「大きな飛躍」をもたらすとフアンは述べています。Grace Hopper を組み込んだシステムは、2023 年前半に発売予定です。

メタバースをともに紡ぐ L40 データセンター GPU が本格生産開始

フアンによると、「メタバース」と呼ばれるインターネットの次なる進化は、3D で拡張されます。Omniverse は、メタバースのアプリケーションを構築して実行するための NVIDIA のプラットフォームです。

ここでもフアンは、こうした世界をつなぎ、シミュレーションするためには、強力で柔軟な新しいコンピューターが必要になると強調しました。NVIDIA OVX サーバーは、メタバース アプリケーションを拡張することができるように設計されています。

NVIDIA の第 2 世代 OVX システムには、現在量産されている Ada Lovelace L40 データセンター GPU が搭載されるとフアンは発表しました。

自律走行車、ロボティクス、医療機器などに提供される Thor

今日の自動車では、アクティブ セーフティ、パーキング、ドライバー モニタリング、カメラ ミラー、クラスター、インフォテインメントなどの機能が、それぞれ別のコンピューターで駆動しています。将来的には、これらの機能は、中央のコンピューター上で動作し、長期的にアップデートされるソフトウェアによって提供されるようになるとフアンは述べました。

その基盤としてこのたび発表されたのが、Hopper の Transformer エンジン、Ada の GPU、そして Grace の驚異的な CPU を組み合わせた DRIVE Thor です。

この新しい Thor スーパーチップは、2,000 TFLOPS の性能を実現し、DRIVE ロードマップの Atlan の代わりとなります。現在量産車に搭載されている 254 TOPS の DRIVE Orin からシームレスに移行することが可能です。Thor は、ロボティクス、医療機器、産業オートメーション、およびエッジ AI システム向けに最適なプロセッサになるとフアンは述べました。

350 万人の開発者、3,000 のアクセラレーテッド アプリケーション

フアンによれば、NVIDIA の 550 のソフトウェア開発キット (SDK) および AI モデルを使用して、約 3,000 のアクセラレーテッド アプリケーションを構築する 350 万人以上の開発者によるソフトウェア エコシステムが、NVIDIA のシステムとシリコン、そしてアクセラレーテッド コンピューティングのメリットを世界中の産業に提供しています。

そして、このエコシステムは急速に成長しています。過去 12 カ月の間に、NVIDIA は 100 以上の SDK を更新し、25 の新しい SDK を導入しました。

「新しい SDK は、お客様がすでにお持ちのシステムの機能や性能を向上させるだけでなく、アクセラレーテッド コンピューティングの新市場も開拓します」とフアンは語ります。

AI やバーチャル世界向けの新サービス

大規模言語モデルは「今日、最も重要な AI モデルです」とフアンは言います。Transformer アーキテクチャをベースとするこれらの巨大なモデルは、教師やラベル付きデータセットがなくても意味や言語を理解するように学習し、驚くべき新機能を解き放っています。

研究者がこの「驚異的な」テクノロジを自分の仕事に簡単に応用できるように支援する目的で、フアンは、事前トレーニング済みの LLM を特定タスクの実行に適合させる NVIDIA のマネージド クラウド サービスである Nemo LLM サービス を発表しました。

医薬品やバイオサイエンスの研究者の仕事を加速させるため、フアンは、化学物質、タンパク質、DNA、RNA の配列を理解する LLM を作成できるサービスとして BioNeMo LLM も発表しました。

フアンは、ヒトゲノム情報の世界最大の提供者である The Broad Institute との協力を通じ、NVIDIA Parabricks、Genome Analysis Toolkit (GATK)、BioNeMo などの NVIDIA Clara ライブラリを、Broad の Terra Cloud Platform 上で利用可能にする予定です。

ヒトゲノム情報の世界最大の提供者である The Broad Institute との協力を通じ、NVIDIA は NVIDIA Clara ライブラリを Broad の Terra Cloud Platform 上で提供する予定です。

ヒトゲノム情報の世界最大の提供者である The Broad Institute との協力を通じ、NVIDIA は NVIDIA Clara ライブラリを Broad の Terra Cloud Platform 上で提供する予定です。 フアンはまた、クラウド、オンプレミス、またはデバイス上で動作する Omniverse アプリケーションを接続するサービスとしてのインフラストラクチャ (IaaS) である NVIDIA Omniverse Cloud についても詳しく説明しました。

現在、新しい Omniverse コンテナ (合成データ生成用の Replicator、レンダー ファームのスケーリング用の Farm、そして AI ロボットの構築およびトレーニング用の Isaac Sim) のクラウド展開も可能であるとフアンは発表しました。

Omniverse は広範に採用されており、フアンは以下のようなお客様事例とデモを紹介しました。

- 約 2,000 の小売店を持つ Lowe’s は、店舗のデジタル ツインの設計、構築、運用に Omniverse を利用しています。

- 500 億ドル規模の通信事業者である Charter とインタラクティブ データ分析プロバイダーの HeavyAI は、Omniverse を利用することで、Charter の 4G および 5G ネットワークのデジタル ツインを作成しています。

- GM は、Michigan Design Studio のデジタル ツインを Omniverse で作成することで、デザイナー、エンジニア、マーケティング担当者がコラボレーションできるようにしています。

ホームセンターの Lowe’s は、店舗のデジタル ツインの設計、構築、運用に Omniverse を利用しています。

ホームセンターの Lowe’s は、店舗のデジタル ツインの設計、構築、運用に Omniverse を利用しています。ロボティクス向けの新しい Jetson Orin Nano

フアンは、バーチャル世界からその世界の中で動く機械に移行するロボティクス コンピューターのことを「最も新しいタイプのコンピューター」と述べ、NVIDIA のロボティクス向け第 2 世代プロセッサ Orin のことを「ホームラン」と表現しました。

Orin をより多くの市場に届けるため、人気を博した前世代の Jetson Nano の 80 倍高速な小型ロボティクス コンピューター Jetson Orin Nano が発表されました。

Jetson Orin Nano は、NVIDIA Isaac ロボティクス スタックを実行し、ROS 2 GPU アクセラレーテッド フレームワークを搭載。またロボティクス シミュレーション プラットフォームである NVIDIA Isaac Sim をクラウド上で利用できるようにしました。

また、AWS RoboMaker を利用しているロボティクス開発者向けに、フアンは、ロボティクス開発用の NVIDIA Isaac プラットフォームのコンテナが AWS マーケットプレイスで提供されることを発表しました。

ビデオと画像サービス向けの新ツール

世界のインターネット トラフィックのほとんどはビデオです。ユーザーが生成したビデオ 配信は、AI の特殊効果やコンピューター グラフィックスによって今後ますます増強されていくでしょう。

「アバターは、コンピューター ビジョン、スピーチ AI、言語理解、コンピューター グラフィックスをリアルタイムかつクラウド規模で行うようになります」とフアンは述べました。

リアルタイム グラフィックス、AI、そしてコミュニケーションが交わるところで新たなイノベーションを実現するために、NVIDIA は CV-CUDA などのアクセラレーション ライブラリや、クラウド ランタイム エンジンの UCF (Unified Computing Framework)、Omniverse ACE (Avatar Cloud Engine)、さらに顧客サービス アバター用のサンプル アプリケーションである Tokkio の構築を行ってきたことをフアンは発表しました。

Deloitte が AI や Omniverse サービスを企業に提供

そして、これらすべてのテクノロジの世界中での導入を加速するために、世界最大規模の専門サービス会社である Deloitte が、NVIDIA AI と NVIDIA Omniverse の上に構築された新サービスを世界各国の企業に提供することをフアンは発表しました。

フアンによると、Deloitte の専門家が、NVIDIA のアプリケーション フレームワークを利用して、世界中の企業が顧客サービス、サイバーセキュリティ、産業オートメーション、倉庫および小売のオートメーションなどのための最新のマルチクラウド アプリケーションを構築できるように支援することになります。

まだ始まったばかり

フアンは、基調講演の最後に、新たなテクノロジの概要から製品の発表までを振り返り、さまざまな要素を単一のビジョンとしてまとめました。

「私たちは本日、新しいチップや、プラットフォームの進化、そして初の新しいクラウド サービスについて発表しました。これらのプラットフォームは、AI における新たなブレイクスルー、AI の新たなアプリケーション、そして科学と産業分野における次世代 AI の推進力となっていくことでしょう」とフアンは基調講演を締めくくりました。