NVIDIA は、今年最も重要なコンピュータ グラフィックス カンファレンスである SIGGRAPH にて約 20 の研究論文を発表予定

NVIDIA は、開発者やアーティストが、静止画や動画、2D や 3D、超リアルや幻想的など、自分のアイデアを実現可能にする最先端の AI 研究の波を紹介しました。

米国、欧州、イスラエルの 10 以上の大学との共同研究を含む、ジェネレーティブ AI とニューラル グラフィックスを推進する約 20 の NVIDIA Research の論文が、8 月 6 日から 10 日までロサンゼルスにて開催される最高峰のコンピュータ グラフィックス会議、SIGGRAPH 2023 にて発表される予定です。

論文には、テキストをパーソナライズされた画像に変換するジェネレーティブ AI モデル、静止画像を 3D オブジェクトに変換する逆レンダリング ツール、AI を利用して複雑な 3D 要素を圧倒的なリアルさでシミュレーションするニューラル フィジックス モデル、AI を使ってリアルタイムの視覚的な詳細を生成する新しい機能を解放するニューラル レンダリング モデルなどが含まれています。

NVIDIA の研究者によるイノベーションは、GitHub で定期的に開発者と共有され、メタバース アプリケーションを構築、運用するためのプラットフォーム「NVIDIA Omniverse」や、最近発表されたビジュアル デザイン用のカスタム ジェネレーティブ AI モデルのファウンドリ「NVIDIA Picasso」などの製品に取り入れられています。NVIDIA の長年にわたるグラフィックス研究は、最近リリースされた世界初のパストレース AAA タイトルである『サイバーパンク2077』のレイトレーシング: オーバードライブ モードのように、ゲームに映画スタイルのレンダリングをもたらすのに役立っています。

今年の SIGGRAPH で発表される研究成果は、開発者や企業がロボティクスや自動運転車のトレーニングのための仮想世界を構成する合成データの迅速な生成を支援します。また、アート、建築、グラフィック デザイン、ゲーム開発、映画などのクリエイターが、ストーリーボードやプリビジュアライゼーション、さらにはプロダクションで使用する高品質なビジュアルをより迅速に作成できるようになります。

パーソナルなタッチの AI: カスタマイズされたテキストから画像へのモデル

テキストを画像に変換するジェネレーティブ AI モデルは、映画やビデオ ゲーム、3D 仮想世界のコンセプト アートやストーリーボードを作成するための強力なツールです。テキストから画像に変換する AI ツールは、「子供のおもちゃ」というプロンプトを、ぬいぐるみ、ブロック、パズルなど、クリエイターがインスピレーションを得るために使用できる、ほぼ無限のビジュアルに変換することができます。

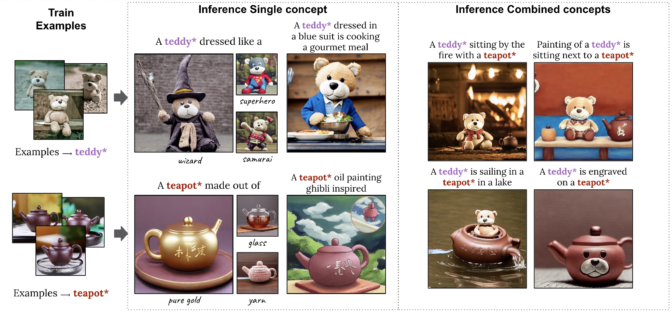

しかし、アーティストは特定のテーマを考えている場合があります。例えば、玩具ブランドのクリエイティブ ディレクターが新しいテディベアを中心とした広告キャンペーンを企画していて、テディベアのティー パーティーなど、さまざまな状況で玩具を可視化したいと思うかもしれません。ジェネレーティブ AI モデルの出力でこのレベルの具体性を持たせるために、テルアビブ大学と NVIDIA の研究者は、ユーザーが画像の例を提供することで、モデルが迅速に学習できるようにする 2 つの SIGGRAPH 論文の発表を準備しています。

1 つ目の論文では、出力をカスタマイズするために 1 枚のサンプル画像を必要とする手法について述べられています。1 基の NVIDIA A100 Tensor コア GPU でパーソナライズ処理を数分から約 11 秒に短縮し、従来のパーソナライズ手法に比べて 60 倍以上の高速化を実現しています。

2 つ目の論文では、Perfusion と呼ばれる非常にコンパクトなモデルが紹介されています。このモデルは、数枚のコンセプト画像を使用して、特定のテディベアやティーポットなど、複数のパーソナライズされた要素を組み合わせて、AI が 1 つのビジュアルを生成します。

3D サービス: 逆レンダリングとキャラクター作成の進歩

クリエイターが仮想世界のコンセプト アートを思いついたら、次は環境をレンダリングし、3D オブジェクトやキャラクターを追加する必要があります。NVIDIA Research は、 2D 画像やビデオを自動的に 3D オブジェクトに変換し、クリエイターがグラフィックス アプリケーションに取り込んで編集できるようにすることで、このような時間がかかるプロセスを加速する AI テクノロジを開発しています。

カリフォルニア大学サンディエゴ校の研究者と共同で作成した 3 つ目の論文は、1 枚の 2D ポートレートからフォトリアリスティックな 3D ヘッド & ショルダー モデルを生成してレンダリングするテクノロジについて述べたものです。これは、AI による 3D アバター作成と 3D ビデオ会議を可能にする大きな進歩です。この方法は、コンシューマー向けデスクトップ上でリアルタイムに動作し、従来のウェブカメラやスマートフォンのカメラだけで、フォトリアリスティックまたはスタイル化された 3D テレプレゼンスを生成することができます。

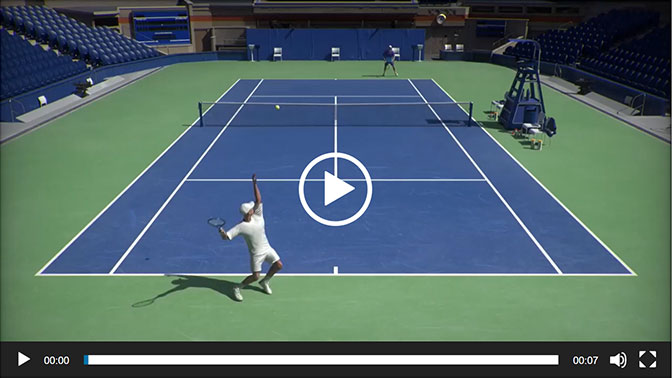

4 つ目の論文は、スタンフォード大学との共同研究で、3D キャラクターに実物そっくりの動きをもたらします。研究者たちは、実際のテニス試合の 2D ビデオ記録から多彩なテニスのスキルを学習し、この動作を 3D キャラクターに適用できる AI システムを作成しました。シミュレーションされたテニスの選手たちは、仮想のコート上で正確にボールを狙い打つことができ、他のキャラクターと長時間のラリーをすることもできます。

この SIGGRAPH の論文は、テニスというテスト ケースにとどまらず、高価なモーションキャプチャ データを使用せずに、リアルな動きで多様なスキルを実現できる 3D キャラクターを作成するという困難な課題に取り組んでいます。

一本の髪の乱れもない: リアルなシミュレーションを可能にするニューラル フィジックス

3D キャラクターが生成されると、アーティストは髪の毛のようなリアルで細部を重ねていくことができますが、これはアニメーターにとって複雑で計算コストのかかる課題です。

人間の髪の毛は平均 10 万本あり、その一本一本が個々の動きや周囲の環境に応じて動的に反応します。従来、髪の毛の動きは物理式を用いて計算され、リソースに応じて簡略化、近似化されてきました。そのため、大作映画に登場する仮想キャラクターは、リアルタイムのビデオゲームのアバターよりもはるかに詳細な毛髪を持っています。

5 つ目の論文では、現実世界で物体がどのように動くかを予測するためにニューラル ネットワークに教える AI テクノロジであるニューラル フィジックスを用いて、数万本の毛髪を高解像度かつリアルタイムでシミュレーションできる方法を紹介しています。

研究チームは、実物大の毛髪を正確にシミュレーションするための新しいアプローチを、最新の GPU 向けに特別に最適化しました。CPU ベースの最新ソルバーと比較して大幅に性能が向上し、シミュレーションにかかる時間が数日から数時間程度に短縮すると同時に、リアルタイムで可能なヘア シミュレーションの品質も向上しています。このテクノロジにより、物理ベースのヘア グルーミングの正確さとインタラクティブ性を両立させることが可能になりました。

リアルタイム グラフィックスに映画並みのディテールをもたらすニューラル レンダリング

環境にアニメーション化された 3D オブジェクトやキャラクターを配置した後、リアルタイム レンダリングが仮想シーンを通して光が反射する物理現象をシミュレーションします。最近の NVIDIA の研究では、テクスチャ、マテリアル、ボリュームに関する AI モデルが、ビデオ ゲームやデジタル ツインにおいて、映画品質のフォトリアリスティックなビジュアルをリアルタイムで実現する方法を示しています。

NVIDIA は 20 年以上前にプログラマブル シェーディングを発明し、開発者がグラフィックス パイプラインをカスタマイズできるようにしました。これらの最新のニューラル レンダリングの発明において、研究者は NVIDIA のリアルタイム グラフィックス パイプラインの奥深くで動作する AI モデルでプログラマブル シェーディング コードを拡張しました。

NVIDIA は、SIGGRAPH での 6 つ目の論文で、GPU メモリを追加することなく最大16倍のテクスチャ ディテールを実現するニューラル テクスチャ圧縮を発表します。ニューラル テクスチャ圧縮は、3D シーンの臨場感を大幅に向上させることができます。下の画像は、ニューラル圧縮されたテクスチャ (右) が、テキストがぼやけたままである従来のフォーマット (中央) よりも鮮明な詳細を捉えていることを示しています。

昨年発表された関連論文は、煙、火、雲、水などのボリューム データを表現するのに必要なメモリを 100 倍削減する AI 対応データ圧縮技術 NeuralVDB として早期アクセスが可能になりました。

NVIDIA はまた、直近の NVIDIA GTC 基調講演で示されたニューラル マテリアル研究の詳細を発表しました。この論文では、フォトリアルな何層ものマテリアルから光がどのように反射するかを学習し、これらのアセットの複雑さをリアルタイムで実行する小さなニューラル ネットワークにまで減らし、最大 10 倍高速なシェーディングを可能にする AI システムについて説明しています。

そのリアルさは、以下のレンダリングされたティーポットにも表れています。陶器、不完全なクリアコートの釉薬 (うわぐすり)、指紋、汚れ、埃までも正確に表現しています。

より多くのジェネレーティブ AI とグラフィックスの研究

これらはハイライトに過ぎません。SIGGRAPH におけるすべての NVIDIA の論文について、詳細をご覧ください。また、NVIDIA は、パストレーシング、テレプレゼンス、ジェネレーティブ AI の拡散モデルなどのテーマで、6 つのコース、4 つの講演、2 つの Emerging Technology デモをカンファレンスで発表する予定です。

NVIDIA Research は、世界中の数百人の科学者とエンジニアからなるチームで、AI 、コンピュータグラフィックス、コンピュータ ビジョン、自動運転車、ロボティクスなどのトピックに注力しています。