国立研究開発法人 産業技術総合研究所が、数千基の NVIDIA H200 GPU と NVIDIA Quantum-2 InfiniBand を活用し、ヒューレット・パッカード エンタープライズ (HPE)が構築する、新しい AI スーパーコンピューターによって能力を大幅に拡大

日本の AI 主権を強化し、研究開発能力を向上させるための戦略的な施策として、国立研究開発法人 産業技術総合研究所 (以下、産総研) が、数千基の NVIDIA H200 Tensor コア GPU と NVIDIA Quantum-2 InfiniBand ネットワークを搭載したHPE Cray XD システムを採用し、AI Bridging Cloud Infrastructure 3.0 (以下、ABCI 3.0 ) スーパーコンピューターの性能と拡張性をさらに高めようとしています。

ABCI 3.0 は、AI の研究開発を進展させるために設計された、日本における最新の大規模オープン AI コンピューティング インフラです。今回のコラボレーションは、AI 能力を高め、自国の技術的独立性をさらに進めようとする、日本の意欲を裏付けるものとなっています。

国立研究開発法人 産業技術総合研究所 執行役員 兼 情報・人間工学領域長 田中 良夫氏は、次のように述べています。「当研究所は、世界初の大規模オープン AI コンピューティング インフラである ABCI を2018 年 8 月に本格運用を開始しました。ABCI を管理してきた過去数年間の経験に基づき、当研究所は ABCI 3.0 へのアップグレードを行います。NVIDIA および HPE とのコラボレーションにより、ABCI 3.0 が日本の生成 AI 研究開発能力をさらに高める、コンピューティング インフラに発展することを目指しています」

株式会社 AIST Solutions 事業プロデューサ 兼 ABCI 運営責任者である小川 宏高氏は、次のように述べています。「生成 AI が地球規模の変革をもたらす『触媒』となる中、日本国内における生成AIの研究開発能力を迅速に育成していくことが極めて重要となっています。NVIDIA および HPE との協業による今回のABCIの大幅アップグレードは、国内産業および学術研究機関を世界的にも競争力のあるAI 開発に導くとともに、将来のイノベーション創出の基盤になるものと確信しています」

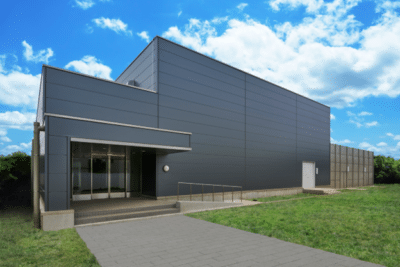

ABCI 3.0 スーパーコンピューターは、産総研が運営している、柏市の施設に設置される予定

ABCI 3.0 スーパーコンピューターは、産総研が運営している、柏市の施設に設置される予定

提供:国立研究開発法人 産業技術総合研究所

ABCI 3.0 : 日本の AI 研究開発の新時代

ABCI 3.0 は、産総研とその成果活用等支援法人である株式会社 AIST Solutions、システムインテグレーターである 日本ヒューレット・パッカード合同会社 (HPE)によって構築と運用されます。

ABCI 3.0 プロジェクトは、日本の経済産業省による経済安全保障基金を活用した、計算整備への補助に続くもので、ABCI への取り組み、ならびにクラウド AI コンピューティングへの補助を含む、経済産業省による大規模な1,566億円(約10 億米ドル)におよぶイニシャチブの一環となっています。

NVIDIA は、創業者/CEO であるジェンスン フアン (Jensen Huang) が昨年、日本を訪れ、岸田文雄内閣総理大臣を含む財政界のリーダーと会談し、AI の未来について協議したことに続き、研究および教育において 経済産業省と緊密に連携しています。

日本の未来に対する NVIDIA の取り組み

フアンは、生成 AI、ロボティクスおよび量子コンピューティングなどの研究協力、AI スタートアップへの投資、AI に関する製品サポート、トレーニングおよび教育の提供を行うことを強調しました。

日本訪問の際にフアンは、膨大な量のデータをインテリジェンスに変換するためには、最も計算集約的なAI タスクを処理するために設計された、次世代データセンターである、「AI ファクトリー」が不可欠であることを強調しました。

「AIファクトリーは、世界中で現代における経済基盤になるでしょう」と、フアンは昨年12月に日本の報道陣との会見の際に述べています。

超高密度のデータセンターとエネルギー効率に優れた設計により、ABCI は、AI とビッグデータのアプリケーション開発のための堅牢なインフラを提供します。

本システムは、東京近郊の柏市に設置され、今年中にも稼働し、最先端の AI 研究開発リソースを提供予定です。

圧倒的なコンピューティング性能と効率性

本施設は以下を提供予定です。

- 6 エクサフロップスの AI 演算性能 (スパース性なし、AIの演算に利用される 16 ビット浮動小数点フォーマット の処理能力)

- 410ペタフロップスの倍精度演算性能 (一般的な演算能力を示す指標)

- 各ノードは、Quantum-2 InfiniBand プラットフォームを通じて、200GB/s のバイセクション帯域幅で接続

NVIDIA のテクノロジが、このイニシャチブのバックボーンとなっており、数百を超えるノードそれぞれに NVLlink で接続された H200 GPU を 8 基搭載し、前例のない演算性能と効率性を実現しています。

H200 GPU は、毎秒 4.8 TB/s の帯域幅を持つ 140 GB を超える HBM3e メモリを搭載した、初の GPU です。H200 GPU のより大きく高速なメモリは生成 AI と LLM を加速し、より優れたエネルギー効率と低い総費用コスト (TCO) で、HPC ワークロード用の科学的コンピューティングを向上させます。

NVIDIA H200 Tensor コア GPUは、LLMトークン生成などのAIワークロードにおいて、ABCI2.0で採用された前世代アーキテクチャよりも15倍エネルギー効率が高くなっています。

先進的な NVIDIA Quantum-2 InfiniBand においては、ネットワーク デバイスがデータを基に演算を行い CPU から作業をオフロードするIn-Network Computing が統合させており、AI 集約的なワークロードや膨大なデータセットを処理するために不可欠な、効率的かつ高速で、低遅延の通信が可能になります。

ABCI は世界クラスの演算性能とデータ処理性能をさらに高めており、産業界、学界および政府と共同で行う AI 研究開発を加速するためのプラットフォームとなります。

経済産業省の大規模な投資は、AI開発力の強化や生成 AI 利活用を促進し、日本の戦略的なビジョンを明確に示すものとなっています。

AI スーパーコンピューターの開発を助成することによって、日本は、次世代 AI テクノロジ開発のための時間と費用を削減しながら、AI の世界的なリーダーとしての地位を確立することを目指しています。