新しいモデルにさらに多くの機能が搭載されるのに伴って、生成 AI への関心は高まり続けています。最新の進歩により、開発者の経歴がない愛好家でも、こういったモデルをすぐに利用できるようになりました。

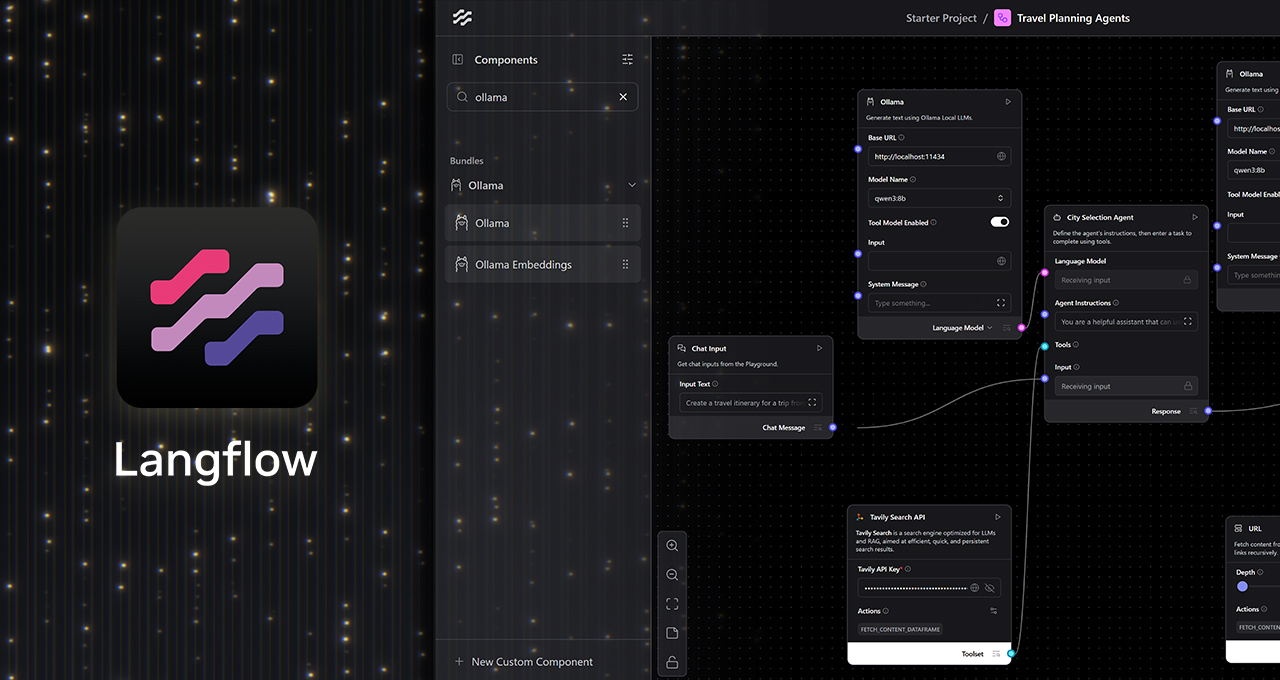

カスタム AI ワークフローを設計するローコードのビジュアル プラットフォームである Langflow などの人気のアプリケーションにより、AI 愛好家はシンプルでコード不要のユーザー インターフェイス (UI) を使用して、生成 AI モデルを連携させることができます。また、Ollama とのネイティブ統合により、ユーザーは NVIDIA GeForce RTX と RTX PRO GPU を基盤にして、ローカル AI ワークフローを無料で作成して実行できるようになりました。しかも、プライバシーは完全に保護されます。

生成 AI 向けのビジュアル ワークフロー

Langflow は、大規模言語モデル (LLM)、ツール、メモリ ストア、制御ロジックなど、生成 AI モデルのコンポーネントを、シンプルなドラッグ アンド ドロップ UI を通じて接続できる、使いやすいキャンバス型のユーザー インターフェイスを提供しています。

これにより、手動でスクリプトを作成しなくとも、複雑な AI ワークフローを構築および変更でき、意思決定や多段階のアクションに対応したエージェントの開発が容易になります。AI 愛好家は、コーディングの専門知識をあらかじめ持っていなくとも、試行錯誤しながら複雑な AI ワークフローを構築できます。

シングルターンの LLM クエリの実行に限定されるアプリとは異なり、Langflow は、賢い協力者のように動作する高度な AI ワークフローを構築できます。このワークフローは、ファイルの分析、知識の取得、機能の実行、動的な入力に対する文脈に応じた回答ができます。

Langflow は、Ollama を通じて RTX GPU のフル アクセラレーションを使用し、クラウドやローカルでモデルを実行できます。ワークフローをローカルで実行するには、さまざまな重要な利点があります。

- データのプライバシー: 入力、ファイル、プロンプトはデバイス内に留まります。

- 低コストで API キーが不要: クラウド アプリケーションのプログラミング インターフェイス アクセスが必要ないため、AI モデルの実行に伴うトークン制限、サービス サブスクリプション、コストはありません。

- パフォーマンス: RTX GPU は、コンテキスト ウィンドウが長い場合でも、低遅延、高スループットの推論を実現します。

- オフライン機能: ローカル AI ワークフローは、インターネットに接続しなくとも利用できます。

Langflow と Ollama でローカル エージェントを作成

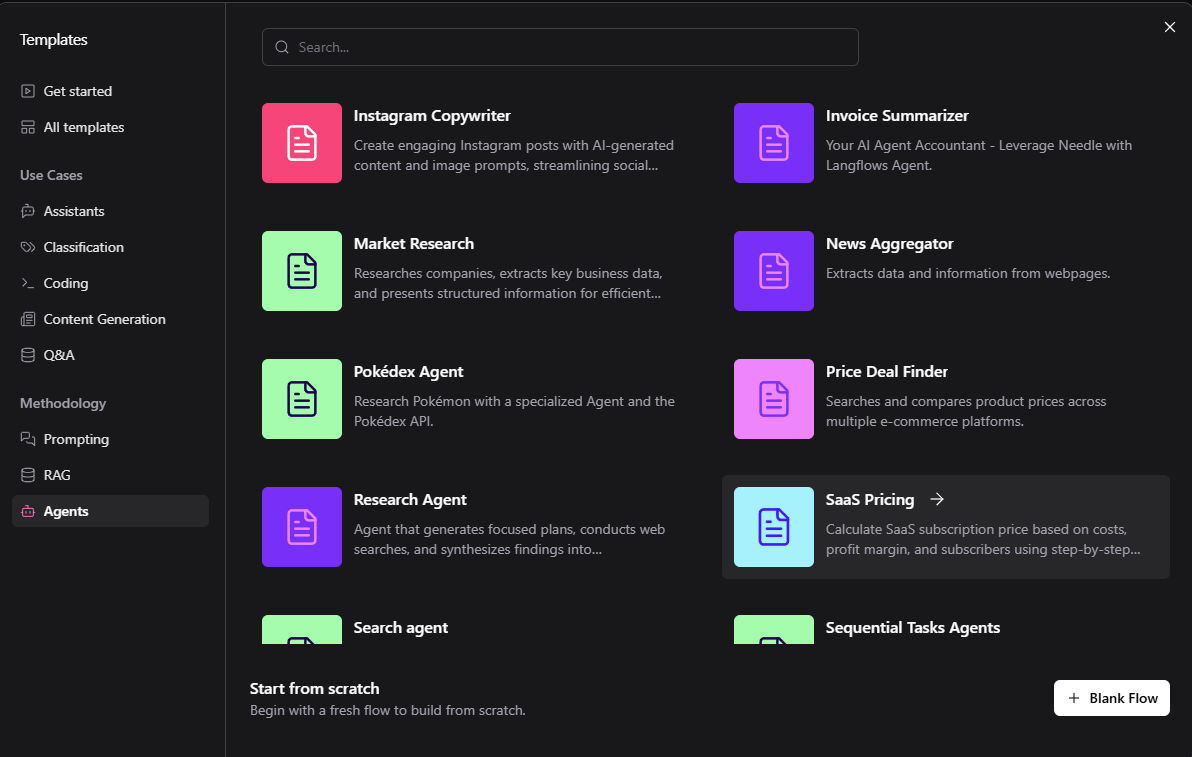

Langflow 内で Ollama を使用し始めるのは簡単です。旅行代理店から購入アシスタントまで、幅広いユースケースで利用できる組み込み済みのスターターが用意されています。デフォルトのテンプレートは、通常、テスト用にクラウドで実行されますが、Langflow を使用して RTX GPU 上でローカルに実行するようカスタマイズできます。

ローカル ワークフローを構築するには:

- Windows 用の Langflow デスクトップ アプリをインストールします。

- Ollama をインストールしてから実行し、好みのモデルを追加します (ユーザーの初めてのワークフローには Llama 3.1 8B または Qwen3 4B を推奨します)。

- Langflow を実行し、スターターを選択します。

- クラウド エンドポイントをローカル Ollama ランタイムに置き換えます。 エージェント ワークフローでは、言語モデルを Custom に設定し、Ollama ノードをキャンバスにドラッグして、エージェント ノードのカスタム モデルを Ollama ノードの言語モデル出力に接続します。

テンプレートは、システム コマンド、ローカル ファイル検索、構造化出力を追加するなどの変更や拡張が可能で、高度な自動化とアシスタントのユース ケースに対応できます。

Langflow チームによるステップバイステップのチュートリアルをご覧ください。

今すぐ始める

以下は、お試し用の 2 つのサンプル プロジェクトです。

個人用旅行計画エージェントを作成する: 希望するレストランの予約、旅行者の食事制限など、すべての旅行の要件を入力すると、宿泊施設、交通手段、食事、エンターテインメントを自動的に検索して手配します。

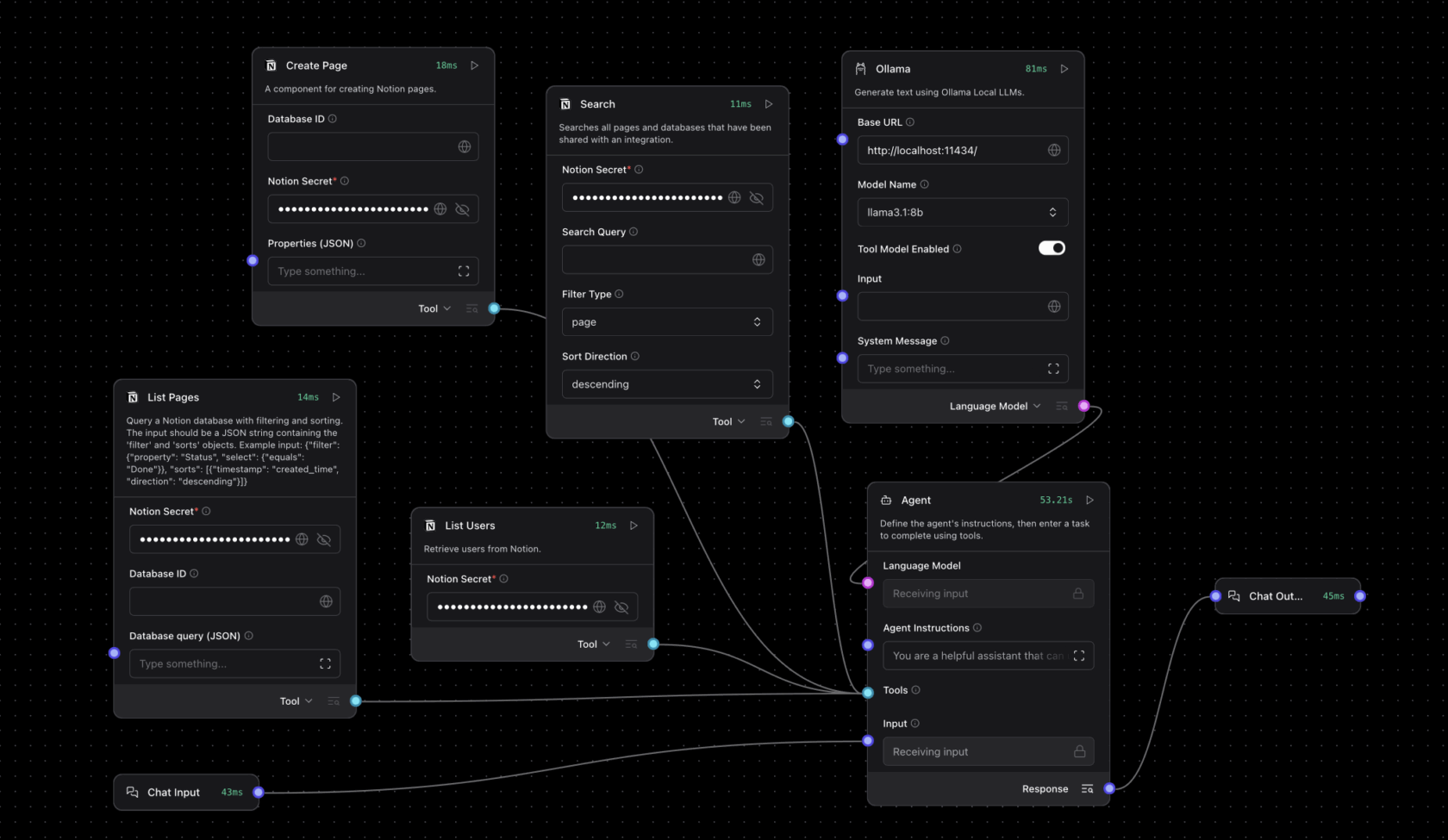

Notion の機能を拡張する: プロジェクトを整理する AI ワークスペース アプリケーションである Notion を AI モデルで拡張し、議事録の自動入力、Slack チャットやメールに基づいたプロジェクトのステータス更新、プロジェクトや会議の要約の送信などを行うことができます。

RTX Remix が Model Context Protocol を追加。エージェント MOD 構築が可能に

RTX Remix は、MOD 制作者が生成 AI ツールでマテリアルを強化し、フル レイ トレーシングとニューラル レンダリング技術を搭載した見事な RTX リマスターを作成できるオープンソース プラットフォームで、Langflow を使用した Model Context Protocol (MCP) のサポートを追加しました。

MCP を備えた Langflow ノードでは、ユーザーに RTX Remix を直接操作するインターフェイスが提供され、MOD 制作者は Remix のドキュメントや MOD 機能とインテリジェントに連携する MOD アシスタントを構築できます。

MOD 制作者の作業開始を支援するため、NVIDIA の Langflow Remix テンプレートには、以下が含まれています。

- RTX Remix ドキュメントを備えた検索拡張生成モジュール。

- Q&A スタイルのサポートを提供する Remix ドキュメントへのリアルタイム アクセス。

- RTX Remix 内でアセットの置換、メタデータの更新、自動化された MOD 操作など、機能の直接的な実行をサポートする MCP 経由のアクション モジュール

このテンプレートで構築された MOD アシスタント エージェントは、クエリが情報型かアクション指向かを決定できます。コンテキストに基づいて、エージェントは動的にガイダンスで応答したり、要求されたアクションを実行したりします。たとえば、ユーザーはエージェントに「この低解像度のテクスチャを高解像度のバージョンに置き換えてください」と指示するかもしれません。これに対して、エージェントはアセットのメタデータを確認し、適切な代替アセットを見つけ、MCP 機能を使用してプロジェクトを更新します。この機能には、手作業での操作が必要ありません。

Remix テンプレートのドキュメントと設定手順は、RTX Remix 開発者ガイドでご覧いただけます。

Langflow で Project G-Assist を使用して RTX AI PC を制御

NVIDIA Project G-Assist は、GeForce RTX PC でローカルに実行する実験的なオンデバイスの AI アシスタントです。システム情報 (PC のスペック、CPU/GPU の温度、使用率など) のクエリやシステム設定の調整など、すべて簡単な自然言語プロンプトを通じて行うことができます。

Langflow の G-Assist コンポーネントにより、これらの機能をカスタム エージェント ワークフローに組み込むことができます。ユーザーは G-Assist に「GPU の温度を取得して」や「ファン速度を調整して」と指示できます。その指示に対する応答とアクションは、コンポーネント チェーン通じて実行されます。

G-Assist は診断とシステム制御のほか、プラグイン アーキテクチャを通じて拡張可能なので、ユーザーはワークフローに合わせて新しいコマンドを追加できます。コミュニティにより構築されたプラグインは、Langflow ワークフローから直接呼び出すこともできます。

Langflow で G-Assist コンポーネントの使用を開始するには、開発者ドキュメントをご覧ください。

Langflow は、オンプレミスまたはクラウドの Kubernetes 環境全体で AI ワークフローを構築および展開するためのモジュラー プラットフォームである NVIDIA NeMo マイクロサービス用の開発ツールでもあります。

Ollama と MCP の統合サポートにより、Langflow は、完全にオフラインおよびデバイス上で実行できるリアルタイムの AI ワークフローとエージェントを構築するための実用的なノーコード プラットフォームを提供します。これらはすべて NVIDIA GeForce RTX と RTX PRO GPU によって高速化されます。

毎週、RTX AI Garage ブログ シリーズでは、NVIDIA NIM マイクロサービスと AI Blueprint について詳しく知りたい方、AI PC とワークステーションで AI エージェント、クリエイティブなワークフロー、生産性アプリなどを構築する方向けに、コミュニティ主導の AI イノベーションとコンテンツを紹介しています。

Facebook、Instagram、TikTok、X で NVIDIA AI PC をフォローし、RTX AI PC ニュースレターを購読して、最新情報を入手しましょう。 NVIDIAのDiscordサーバーに参加し、コミュニティの開発者やAI愛好者とつながり、RTX AIの可能性について話し合ってください。

LinkedIn と X で NVIDIA Workstation をフォローしてください。

ソフトウェア製品情報に関するお知らせをご覧ください。