信頼できる AI とは、AI に接する人々の安全性と透明性を優先する AI 開発のアプローチです

人工知能は、他の変革的なテクノロジと同様、その能力と社会的影響において絶えず成長し続ける、現在進行形のテクノロジです。信頼できる AI への取り組みは、AI が人々や社会に与える現実世界への影響を認識し、その力を前向きな変化のために責任を持って活用することを目指しています。

信頼できる AI とは何か?

信頼できる AI とは、AI に接する人々の安全性と透明性を優先する AI 開発のアプローチです。信頼できる AI の開発者は、完璧なモデルが存在しないことを理解し、技術がどのように構築されたのか、意図された使用例とその限界を顧客と一般市民が理解できるような措置を講じています。

プライバシーや消費者保護に関する法律を遵守することに加え、信頼できる AI モデルは、安全性、セキュリティ、望ましくないバイアスの軽減についてテストされています。また、規制当局、開発者、消費者を含むさまざまなオーディエンスに対して、精度のベンチマークやトレーニングデータセットの説明などの情報を提供し、透明性を確保しています。

信頼できる AI の原則

信頼できる AI の原則は、NVIDIA のエンドツーエンドの AI 開発の基礎となるものです。それは、AI における信頼と透明性を可能にし、パートナー、顧客、開発者の作業をサポートすることです。

プライバシー:規制の遵守、データの保護

AI はデータに飢えているとよく言われます。多くの場合、アルゴリズムがより多くのデータでトレーニングされるほど、その予測はより正確になります。

しかし、データはどこからか得なければなりません。信頼できる AI を開発するためには、どのようなデータを合法的に利用できるかだけでなく、どのようなデータを利用することが社会的に責任あることなのかを考えることが重要です。

個人の画像、音声、芸術作品、健康記録などのデータに依存する AI モデルの開発者は、個人情報がこのように使用されることについて、個人が適切な同意を行っているかどうかを確認すべきです。

病院や銀行のような機関にとって、AI モデルを構築することは、堅牢なアルゴリズムをトレーニングする一方で、患者や顧客のデータを非公開にするという責任のバランスを取ることを意味します。NVIDIA は、研究者が機密情報を企業のプライベート サーバーに残すことなく、複数の機関からのデータで訓練された AI モデルを開発する、連合学習を可能にする技術を開発しました。

NVIDIA DGX システムと NVIDIA FLARE ソフトウェアは、ヘルスケアや金融サービスにおける複数の連合学習プロジェクトを実現し、医用画像解析や詐欺検出のための、より正確で汎用性の高い AI モデルについて、複数のデータ提供者による安全な共同作業を促進しています。

安全とセキュリティ:意図しない危害や悪意ある脅威を避けるために

一度展開された AI システムは実世界に影響を及ぼすため、ユーザーの安全を守るためには意図したとおりに機能することが不可欠です。

一般に公開されている AI アルゴリズムを自由に使えるということは、積極的な応用の可能性を大きく広げますが、同時に、その技術が意図しない目的に使われる可能性もあります。

リスクを軽減するために、NVIDIA NeMo Guardrails は、企業の開発者がアプリケーションの境界を設定できるようにすることで、AI 言語モデルを軌道に乗せることができます。「話題のガードレール」は、チャットボットが特定のテーマに留まることを保証します。「安全性ガードレール」は、アプリケーションが応答で使用する言語とデータソースに制限を設けます。「セキュリティ ガードレール」は、第三者のアプリケーションやアプリケーション プログラミング インターフェースに接続された大規模言語モデルが悪意を持って使用されることを防止します。

NVIDIA Research は、DARPA が運営する SemaFor プログラムと協力し、デジタル フォレンジックの専門家が AI が生成した画像を識別できるよう支援しています。昨年、研究者たちは ChatGPT を使って社会的偏見に対処する新しい方法を発表しました。また、アバター フィンガープリンティング (AI が作成した他人の似顔絵を同意なしに使用していないかを検出する方法) の手法も開発しています。

セキュリティの脅威からデータと AI アプリケーションを保護するために、NVIDIA H100 および H200 Tensor コア GPU は、コンフィデンシャル コンピューティングで構築されています。NVIDIA コンフィデンシャル コンピューティングは、ハードウェアベースのセキュリティ手法を使用して、従来データが脆弱なまま放置されていることの多かった実行中に、権限のない存在がデータやアプリケーションを閲覧または変更できないようにします。

透明性:AI を説明可能にする

信頼できる AI モデルを作るためには、アルゴリズムをブラック ボックスにすることはできません。その結果を信頼するためには、AI の作成者、ユーザー、利害関係者が AI の仕組みを理解できなければなりません。

AI における透明性とは、AI モデルがどのようにトレーニングされ、どのように機能するのかをユーザーやその他の利害関係者が理解するためのベスト プラクティス、ツール、設計原則の集合です。説明可能な AI (XAI) は、AI モデルが特定の予測や決定を行う方法を利害関係者に知らせるツールを網羅する透明性のサブセットです。

透明性と XAI は、AI システムに対する信頼を確立するために極めて重要ではありますが、あらゆる種類の AI モデルと利害関係者に適合する普遍的な解決策はありません。適切な解決策を見つけるには、AI が誰に影響を与えるかを特定し、関連するリスクを分析し、AI システムに関する情報を提供する効果的なメカニズムを実装するための体系的なアプローチが必要です。

RAG (Retrieval-augmented Generation) は、生成 AI サービスを信頼できる外部データベースに接続することで AI の透明性を向上させ、モデルがソースを引用し、より正確な回答を提供できるようにする技術です。NVIDIA は、生成 AI モデルの開発とカスタマイズに NVIDIA NeMo フレームワークを使用する開発者が RAG ワークフローを使い始められるように支援しています。

NVIDIA はまた、米国標準技術研究所の米国人工知能安全研究所コンソーシアム (AISIC) の一員でもあり、責任ある AI の開発と展開のためのツールと基準の作成を支援しています。コンソーシアムのメンバーとして、NVIDIA は AI モデルの透明性を実装するためのベスト プラクティスを活用することで、信頼できる AI を推進していきます。

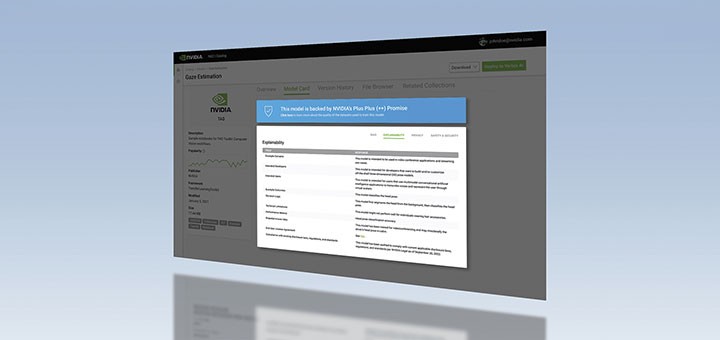

また、NVIDIA のアクセラレーテッド ソフトウェアのハブである NGC では、各 AI モデルがどのように動作し、構築されたかについての詳細な情報をモデル カードで提供しています。NVIDIA の Model Card ++ フォーマットには、データセット、トレーニング方法、使用されたパフォーマンス指標、ライセンス情報、および特定の倫理的な考慮事項が記載されています。

無差別:バイアスの最小化

AI モデルは人間によってトレーニングされ、多くの場合、サイズ、範囲、多様性によって制限されたデータを使用します。すべての人々やコミュニティがこのテクノロジから恩恵を受ける機会を確保するためには、AI システムにおける不要なバイアスを減らすことが重要です。

政府のガイドラインや差別禁止法に従うだけでなく、信頼できる AI 開発者は、アルゴリズムが差別的であることや、特定の特性の不適切な使用を示唆する手がかりやパターンを探すことで、潜在的な望ましくないバイアスを軽減します。データにおける人種や性別のバイアスはよく知られていますが、その他にも文化的バイアスやデータのラベリング時に導入されるバイアスも考慮しなければいけません。望ましくないバイアスを減らすために、開発者はモデルに様々な変数を組み込むかもしれません。

合成データセットは、自律走行車やロボティクスの AI 開発に使用されるトレーニング データにおける望ましくないバイアスを低減するための解決策を提供します。自動運転車のトレーニングに使用されるデータが、極端な気象条件や交通事故などの一般的でないシーンを十分に反映していない場合、合成データはこれらのデータセットの多様性を補強して現実世界をよりよく表現し、AI の正確度を向上させるのに役立ちます。

NVIDIA Omniverse Replicator は、3D パイプラインと仮想世界を作成、操作するためのNVIDIA Omniverse プラットフォーム上に構築されたフレームワークであり、開発者が合成データ生成のためのカスタム パイプラインを設定するのに役立ちます。また、転移学習用の NVIDIA TAO Toolkit を、コンピュータ ビジョン用の偏りのないデータセットをキュレートするためのウェブ プラットフォームである Innotescus と統合することで、開発者はデータセットのパターンとバイアスをよりよく理解し、統計的な不均衡に対処することができます。

信頼できる AI についての詳細は、NVIDIA.com と NVIDIA ブログでご覧ください。AI における不要なバイアスへの取り組みについては、NVIDIA GTC のこちらの講演をご覧ください。また、カリフォルニア州サンノゼで 3 月 18 日から 21 日まで開催されるカンファレンスで、信頼できる AI トラックにご参加ください。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE