チーフ サイエンティストの Bill Dally が、機械学習を次のレベルに引き上げるための研究について説明

NVIDIA のチーフ サイエンティスト兼リサーチ担当シニア バイス プレジデントであるBill Dally (ビル ダリー) は、Hot Chips 2023 の基調講演で、ハードウェア性能の劇的な向上が生成 AI を生み出し、機械学習を新たな高みへと押し上げる将来の高速化に関するアイデアの豊富なパイプラインを生み出したと述べました。

ダリーは、プロセッサとシステム アーキテクトのための年次イベントである Hot Chips での講演で、現在開発中の技術の数々について説明しました。

世界有数のコンピューター科学者で、スタンフォード大学コンピューターサイエンス学部の前学長であるダリーは次のように述べました。「AI の進歩は目覚ましく、それはハードウェアによって実現されたものですが、依然としてディープラーニングのハードウェアによって制限されています」

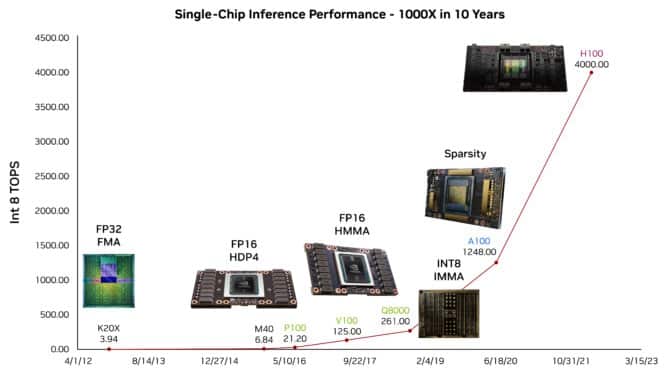

例えば、数百万人が使用している大規模言語モデル (LLM) である ChatGPT が、自分のトークのアウトラインをどのように提案できるかを示しました。このような機能は、過去 10 年間の GPU による AI 推論性能の向上によるところが大きいと述べました。

100 TOPS / ワットを実現する研究

研究者たちは次の進歩の波を準備しています。ダリーは、LLM で 1 ワットあたり 100 TOPS 近くを実証したテスト チップについて説明しました。

この実験では、生成 AI で使われる Transformer モデルをさらに高速化するエネルギー効率の良い方法が示されました。この実験では、将来的な発展が期待されるいくつかの簡略化された数値計算アプローチのひとつである 4 ビット演算が適用されました。

ダリーは、NVIDIA が 2021 年に特許を取得した、対数計算を用いた計算の高速化とエネルギーを節約する方法について議論しました。

AI 用ハードウェアの調整

彼は、新しいデータ型や演算を定義することで、ハードウェアを特定の AI タスクに適合させるための 6 つのテクニックを紹介しました。

ダリーは、NVIDIA A100 Tensor コア GPU で初めて採用された構造的スパース性と呼ばれるアプローチで、シナプスとニューロンを刈り込み、ニューラルネットワークを単純化する方法について次のように説明しました。

「スパース性はまだ終わっていません。アクティベーションをどうにかする必要があり、ウェイトにも大きなスパース性を持たせることができます」

研究者は、ハードウェアとソフトウェアを連動させて設計し、貴重なエネルギーをどこに使うかを慎重に決定する必要がある、とダリーは言いました。例えば、メモリや通信回路は、データの移動を最小限に抑える必要があります。

「コンピューター エンジニアであるのが楽しい時期です。私たちは AI の大革命を可能にしており、それがどれほど大きな革命になるのか、まだ完全に理解さえしていないのです」とダリーは述べました。

より柔軟なネットワーク

別の講演では、NVIDIA のネットワーキング担当バイス プレジデントである Kevin Deierling (ケビン ディアリング) が、変化するネットワーク トラフィックやユーザー ルールに基づいてリソースを割り当てるための NVIDIA BlueField DPU と NVIDIA Spectrum ネットワーキング スイッチのユニークな柔軟性について説明しました。

ハードウェア アクセラレーション パイプラインを数秒で動的にシフトするチップの能力は、最大スループットでの負荷分散を可能にし、コア ネットワークに新たなレベルの適応性を与えます。これは、サイバーセキュリティの脅威から身を守るために特に有効です。

ディアリングは次のように述べています。「今日、生成 AI ワークロードやサイバーセキュリティでは、すべてが動的であり、絶えず変化しています。だから私たちは、ランタイムのプログラマビリティと、その場で変更可能なリソースに移行しているのです」

さらに、NVIDIA とライス大学の研究者は、人気の高い P4 プログラミング言語を使用して、ユーザーがランタイムの柔軟性を活用する方法を開発しています。

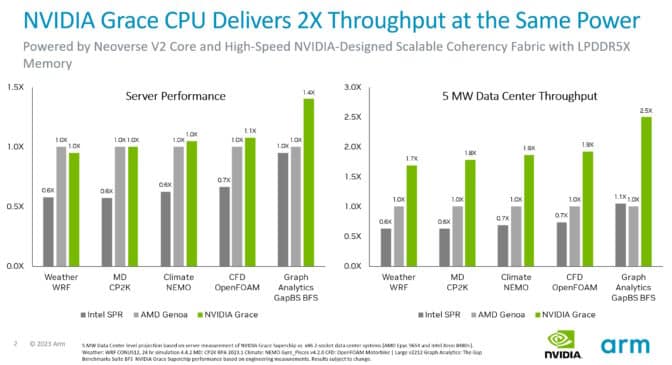

Grace がサーバー CPU をリード

Arm による Neoverse V2 コアに関する講演では、Neoverse V2 コアを実装した最初のプロセッサである NVIDIA Grace CPU Superchip の性能に関する最新情報が紹介されました。

テストによると、同じ消費電力で、Grace システムは、さまざまな CPU ワークロードにわたって、現在の x86 サーバーよりも最大 2 倍のスループットを提供します。さらに、Arm の SystemReady Program は、Grace システムが既存の Arm オペレーティング システム、コンテナ、アプリケーションを変更なしで実行できることを認証しています。

Grace は、超高速のファブリックを使用して、1 つのダイに 72 個の Arm Neoverse V2 コアを接続します。NVLink がこれらのダイを 2 つ接続し、毎秒 900GB の帯域幅を実現します。また、サーバークラスの LPDDR5X メモリを採用する初のデータセンター向け CPUであり、一般的なサーバー用メモリの 8 分の 1 の消費電力で、同程度のコストで 50% 以上多いメモリ帯域幅を提供します。

Hot Chips は、AI の推論やチップ間相互接続のプロトコルに関する NVIDIA の専門家の講演を含む、チュートリアルの全日程で 8 月 27 日に開幕し、8 月 29 日まで開催されました。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE