アジア、欧州、および米国のスーパーコンピューティング センターが、NVIDIA Quantum InfiniBand ネットワーク上の NVIDIA BlueField DPU で、アクセラレーテッド コンピューティングを次のレベルへと押し進める

スティーヴ プール (Steve Poole) 氏は、ネットワークの威力を利用している全世界の数多くの研究者の 1 人です。

ロスアラモス国立研究所 (LANL) に所属するこの著名なシニア サイエンティストは、NVIDIA Quantum InfiniBand のネットワーク上で稼働するデータ プロセッシング ユニット (DPU) を含むアクセラレーテッド コンピューティングを利用することで、パフォーマンスが大幅に向上するであろうと見込んでいます。

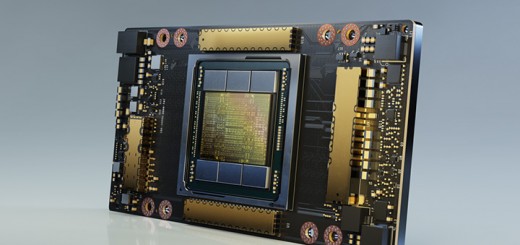

欧州、米国、その他の地域にわたるHPC 開発者たちは、通信およびコンピューティングのジョブを DPU にオフロードする方法の開発を進めています。研究者たちは、NVIDIA BlueField-2 DPU 内部の Arm のコアおよびアクセラレータでスーパーコンピューターをさらに強化しようとしています。

DPU 用のオープン API

プール氏の取り組みは、コンピュテーショナル マルチフィジックス アプリケーションにおける 30 倍の高速化を目指す、NVIDIA との広範な複数年のコラボレーションの一旦を担うものです。これには、BlueField およびその NVIDIA DOCA ソフトウェア フレームワークを利用した、コンピュテーショナル ストレージやパターン マッチングなどにおける手法の開拓が含まれます。

またこうした取り組みは、DPU を利用するために誰もが利用できるアプリケーション インターフェースである、OpenSNAPI のさらなる定義にも役立つことになるでしょう。プール氏は、Arm、IBM、NVIDIA、米国の国立研究所や大学などが参加する、HPC アプリ向けのヘテロジニアス コンピューティングを可能にするコンソーシアムの、Unified Communication Framework における OpenSNAPI プロジェクトの議長を務めています。

「DPU は私たちのソリューション全体に不可欠な要素であり、私は近い将来における DOCA や同様のソフトウェア パッケージの利用に大いなる可能性を見出しています」とプール氏は述べています。

10 から 30 倍高速のフラッシュ ストレージ

LANL は、DPU を搭載したストレージ システムを作成し、すでに In-Network Computing の威力を実感しています。

Accelerated Box of Flash では、SSD と DPU および InfiniBand アクセラレータを組み合わせて、Linux ファイル システムのパフォーマンス上重要な部分を高速化します。これは同様のストレージ システムと比べて最大 30 倍も速く、LANL のインフラストラクチャにおける重要な構成要素になっています。

ABoF により、「より多くの科学的発見が可能になります。コンピュテーションをストレージの近くに配置することにより、データ移動が最小限に抑えられ、シミュレーションとデータ分析のパイプラインの双方の効率が向上します」と、LANL の研究者のドミニク マンノ (Dominic Manno) 氏が最近の LANL ブログの中で述べています。

テキサスがクラウドネイティブ スーパーコンピューティングを採用

直近では、Texas Advanced Computing Center (TACC) が Dell PowerEdge サーバーに BlueField-2 を採用しました。同センターでは、InfiniBand のネットワーク上でそれらの DPU を利用して、自らの Lonestar6 システムをクラウドネイティブ スーパーコンピューティング用の開発プラットフォームとして使用する予定です。

TACC の Lonestar6 は、テキサス A&M 大学、テキサス工科大学、ノース テキサス大学をはじめ、数多くの研究センターや学部の幅広い HPC 開発者に利用されています。

MPI が高速化

北東に1,200 マイル離れたオハイオ州立大学では、研究者たちが、DPU を利用して HPC の最も人気のあるプログラミング モデルの 1 つを最大 21% 高速で動作させることが可能になることを示しました。

研究者は、メッセージ パッシング インターフェース (MPI) の重要な部分をオフロードすることで、多くの大規模 HPC シミュレーションで使われているライブラリである P3DFFT を高速化しました。

「DPU は、忙しい幹部の代わりに業務を処理するアシスタントのようなものです。あらゆるワークロードを高速化できるため、主流になることでしょう」と、自らのチームの MVAPICH オープン ソース ソフトウェアを利用した DPU の取り組みを主導した、オハイオ州立大学のコンピューター サイエンスおよびエンジニアリング教授であるダバルズワー K (DK) パンダ (Dhabaleswar K. (DK) Panda) 氏は述べています。

HPC センター、クラウドにおける DPU

「創薬や航空機設計のような HPC シミュレーションを実行するスーパーコンピューターにとって 2 桁の性能向上は非常に大きな意味を持ちます。またクラウド サービスでは、そうした性能向上を利用して顧客の生産性を向上させることができるのです」と、複数の HPC センターからコードの依頼を受けているパンダ氏は述べています。

NVIDIA SHARP のような機能を備えた Quantum InfiniBand のネットワークは、同氏の取り組みを可能にするのに役立ちます。

「In-Network Computing が話題になっていますが、InfiniBand はすでにサポートしています」と同氏は述べています。

ダラム大学がロード バランシングを実施

欧州の複数の研究チームが、BlueField DPU で MPI やその他の HPC ワークロードを高速化しています。

例えば、イングランド北部のダラム大学では、16 ノードの Dell PowerEdge クラスター上で BlueField DPU を利用して、MPI ジョブのロード バランシング用のソフトウェアの開発を進めています。「その取り組みは、全世界の HPC 施設において、より優れたアルゴリズムのより効率的な処理への道を開くことになるでしょう」と、当該プロジェクトの主任調査員のトビアス ヴァインツィール (Tobias Weinzierl) 氏は述べています。

ケンブリッジ、ミュンヘンにおける DPU

ケンブリッジ、ロンドン、およびミュンヘンの研究者らも DPU を利用しています。

ユニバーシティ カレッジ ロンドンでは、BlueField-2 DPU 上でホスト システムのタスクのスケジューリングを行う方法について研究しています。これは、例えばホスト プロセッサ間でデータを移動させて、必要なときにデータがそこにあるようにするためにする機能です。

Cambridge Service for Data Driven Discovery における Dell PowerEdge サーバー内部の BlueField DPU は、セキュリティ ポリシー、ストレージ フレームワークなどのジョブをホスト CPU からオフロードして、システムのパフォーマンスを最大限に高めています。

一方、ミュンヘン工科大学のコンピューター アーキテクチャおよび並列システム グループの研究者たちは、EuroHPC プロジェクトの一環として、DPU によって MPI とオペレーティング システムの両方のタスクをオフロードする方法を模索しています。

米国に話を戻すと、ジョージア工科大学の研究者たちはサンディア国立研究所と協力して、BlueField-2 DPU を利用した分子動力学における作業の高速化に取り組んでいます。これまでの取り組みについてまとめた論文では、シミュレーションの精度を一切損なうことなく、アルゴリズムを最大 20% 高速化できることが示されています。

拡大するネットワーク

今月初め、日本の研究者は、最新の NVIDIA H100 Tensor コア GPU と、これまでにない高速でスマートなネットワークである、NVIDIA Quantum-2 InfiniBand プラットフォームを搭載したシステムを発表しました。

NEC は、筑波大学計算科学研究センターのために、約 6 PFLOPS の H100 を搭載したスーパーコンピューターを構築します。研究者は、気候学、天体物理学、ビッグデータや、AI での利用を予定しています。

一方、パンダ氏のような研究者たちは、すでに BlueField-3 DPU のコアをどのように利用するかについて考えています。

「これは高卒者の代わりに大卒の幹部補佐を雇用するようなものになり、私はますます多くのオフロードが実現していくことを期待しています」と同氏は冗談めかして述べています。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE