NVIDIA、最新の GPU アーキテクチャに基づく、重要な最新ソフトウェア アプリケーション、最新ハードウェア システム、BMW とのパートナーシップを発表

NVIDIA はこのたび、グローバル情報経済の焦点をサーバーから強力かつ柔軟な新たなクラスのデータセンターへと転換する、次世代コンピューティングのビジョンを打ち出しました。

NVIDIA の創業者/CEO であるジェンスン フアン (Jensen Huang) は、カリフォルニアの自宅のキッチンで録画した 9 部構成のエピソードを、基調講演として同時に公開しました。その中でフアンは、NVIDIA が最近行った Mellanox の買収のほか、待望の NVIDIA Ampere GPU アーキテクチャに基づく新製品や、重要な最新ソフトウェア技術について説明しました。

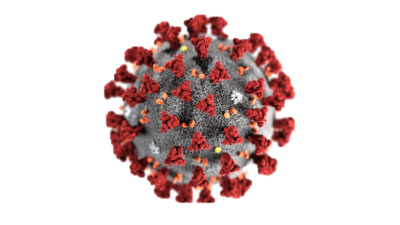

もともとは 3 月下旬にカリフォルニア州サンノゼで開かれる NVIDIA の GPU Technology Conference (GTC) で基調講演をライブで実施する予定でしたが、新型コロナウイルスの大流行によってやむを得ず中止になっていました。

フアンはまず、基調講演の冒頭で次のような謝辞を述べました。

「COVID-19 との戦いで最前線に立っておられる勇敢な皆さまに感謝を申し上げたいと思います。」

フアンは、NVIDIA が研究者や科学者と連携して、GPU や AI コンピューティングを利用したパンデミックの治療、軽減、抑制、追跡に取り組んでいると説明しました。その主な取り組みは以下のとおりです。

- Oxford Nanopore Technologies が、わずか 7 時間で新型コロナウイルスのゲノム配列を解析

- Plotly がリアルタイムで感染率を追跡

- オークリッジ国立研究所とスクリプス研究所が、1 日で 10 億組の治療薬候補となる化合物のスクリーニングを実施

- Structura Biotechnology、テキサス大学オースティン校、および米国国立衛生研究所が、COVID-19 のスパイク タンパク質の 3 次元構造を再現

また、NVIDIA は、COVID-19 の研究に向けた NVIDIA Clara ヘルスケア プラットフォームのアップデートについても発表しています。

「人命を救うために NVIDIA のアクセラレーテッド コンピューティングを利用している研究者や科学者の皆さまは、まさに当社が目指す理想の姿といえます。NVIDIA の目標は、普通のコンピューターでは太刀打ちできない問題を解決するためのコンピューターを実現することです」と、フアンは述べています。

フアンの講演の根幹にあるのは、現代のグローバル情報経済のエンジン ルームともいえるデータセンターがいかに変化を遂げているか、NVIDIA と Mellonox (先月に買収手続きが完了) がいかに一丸となってそれらの変化を推進していくかに向けたビジョンです。

「データセンターは、新たなコンピューティング ユニットです。NVIDIA がシリコンをはじめ、CPU や GPU を接続する方法、フル スタックのソフトウェア、ひいてはデータセンター全体に至るまで、パフォーマンスの向上を加速させている」とフアンは続けます。

データセンタースケール コンピューティングに最適化されたシステム

すべては、この新たな種類のデータセンタースケール コンピューティングに最適化され、AI の学習と推論を統合し、柔軟で弾力性のあるアクセラレーションを実現する、最先端の GPU アーキテクチャから始まります。

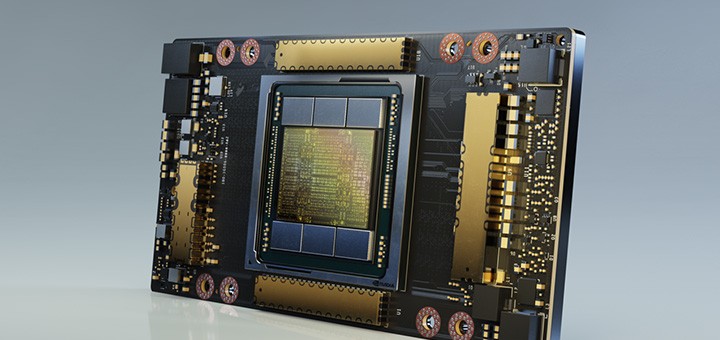

NVIDIA Ampere アーキテクチャ ベース初の GPU であるNVIDIA A100 は、NVIDIA の 8 世代の GPU の中で最大の世代間の向上をもたらすパフォーマンスを提供し、データ分析や科学技術計算、クラウド グラフィックスでの利用も想定した作りになっています。現在は、本格的な量産体制に入っており、世界中のお客様への出荷が進められていると、フアンは伝えています。

世界をリードするサービス プロバイダーやシステム ビルダーの 18 社が、この GPU の採用に乗り出しており、その中には、Alibaba Cloud、Amazon Web Services、Baidu Cloud、Cisco、Dell Technologies、Google Cloud、Hewlett Packard Enterprise、Microsoft Azure、Oracle なども含まれます。

「A100 と、その基盤である NVIDIA Ampere アーキテクチャが、前世代比で最大 20 倍となるパフォーマンスの向上を達成します」とフアンは述べ、A100 の 5 つの主な機能について詳しく解説しています。以下はその抜粋です。

- 540 億を超えるトランジスタを搭載した、世界最大の 7 nm プロセッサ。

- 単精度の AI 学習をそのまま高速化する新しい演算フォーマットである TF 32 に対応した第 3 世代の Tensor コア。広く利用されている NVIDIA の Tensor コアが、さらに柔軟に、高速に、使いやすくなったとフアンは説明しています。

- 構造性疎性のアクセラレーション。この新しい効率化手法では、AI 演算の本質的なスパース性を利用して、パフォーマンスの向上を実現します。

- マルチインスタンス GPU (MIG)。1 台の A100 をそれぞれ独自のリソースを持つ最大 7 つの独立した GPU に分割します。

- 第 3 世代 NVLink テクノロジ。GPU 間の高速接続が 2 倍になり、A100 搭載サーバーを 1 つの巨大な GPU として機能させることが可能です。

これらすべての結果として、NVIDIA の前世代の Volta アーキテクチャと比べ、トレーニング時で 6 倍、推論時で 7 倍となるパフォーマンスの向上を達成します。

NVIDIA DGX A100 で 5 ペタフロップスのパフォーマンスを提供

NVIDIA は、NVIDIA A100 をベースとする 第 3 世代の NVIDIA DGX AI システム (NVIDIA DGX A100) の出荷も進めています。これは、世界初の 5 ペタフロップス サーバーです。また、各 DGX A100 は、それぞれ独立して動作する最大 56 のアプリケーションに分割することが可能です。

これにより、1 台のサーバーを、AI 学習などの演算負荷の高いタスクを素早く終わらせるために「スケールアップ」することも、AI の展開 (推論) のために「スケールアウト」することも可能になると、フアンは言います。

このシステムをいち早く導入するのは米国エネルギー省のアルゴンヌ国立研究所で、COVID-19 の理解を深め戦うために、クラスターの AI と演算能力を利用する予定です。また、フロリダ大学や、ドイツの人工知能研究所にも導入されます。

さらに A100 は、クラウド サーバーやパートナー サーバーのメーカーにも HGX A100 として提供される予定です。

従来のデータセンターは、AI の学習に 50 台の DGX-1 システムと 600 台の CPU システムを搭載し、630 kW の消費電力で 1100 万ドルのコストがかかりました。これに対して、学習と推論用に 5 台の DGX A100 システムを搭載した新しいデータセンターでは、わずか 28 kW の消費電力と 100 万ドルのコストで同じ処理を実行できると、フアンは説明します。

「買えば買うほど節約になる (The more you buy, the more you save)」と、フアンは言います。これは、彼が基調講演で繰り返すおなじみのフレーズです。

さらに、フアンは次世代の DGX SuperPOD も発表しています。140 台の DGX A100 システムと Mellanox のネットワーキング テクノロジを搭載し、700 ペタフロップスの AI パフォーマンスを提供する DGX SuperPOD は、「上位 20 の世界最速コンピューターのうちの 1 つと同等」だと、フアンは指摘します。

NVIDIA は、自社のデータセンターに 4 つの DGX SuperPOD を加えて拡張することで、2.8 エクサフロップスの AI 演算能力をこの SATURNV 内部スーパーコンピューターに追加しようとしています。これで、合計 4.6 エクサフロップスの処理能力を持つことになり、世界最速の AI スーパーコンピューターとなります。

またフアンは、強力なリアルタイムのクラウドコンピューティング機能をエッジにもたらす、NVIDIA EGX A100 も発表しました。この NVIDIA Ampere アーキテクチャ搭載 GPU は、第 3 世代の Tensor コアと、新しいセキュリティ機能を提供します。NVIDIA Mellanox ConnectX-6 SmartNIC によって、セキュアな超高速ネットワーキング機能も搭載されています。

現在世界でもっとも重要なアプリケーションに最適化されたソフトウェア

フアンはほかにも、NVIDIA GPU が「ビッグ データの管理」、「レコメンダー システムの開発」、「リアルタイムの対話型 AI の構築」という 3 つの非常に重要なユースケースを加速させるために、主要なソフトウェア アプリケーションに原動力を提供することを発表しました。

それらの新しいツールの登場は、機械学習の効果によって企業がますます多くのデータが収集するようになったためです。「そのポジティブな反応が、収集されるデータ量の飛躍的増加のもととなっている」とフアンは言います。

あらゆる種類の組織を支援するために、フアンは Spark 3.0 での NVIDIA GPU アクセラレーションのサポートを発表し、そのビッグ データ分析エンジンを「現在、世界でもっとも重要なアプリケーションの 1 つ」と評しています。

RAPIDS で構築された Spark 3.0 は、データの抽出、変換、読み込みのパフォーマンス ベンチマークを塗り替える、とフアンは言います。たとえば Spark 3.0 によって、すでに Adobe Intelligent Services がコンピューティング コストの 90% 削減を達成しています。

主要なクラウド分析プラットフォーム (Amazon SageMaker、Azure Machine Learning、Databricks、Google Cloud AI、Google Cloud Dataproc など) はすべて NVIDIA によって加速されるようになると、フアンは発表しました。

「これで、数十ペタバイト、数百ペタバイトから、エクサスケール規模、さらにはそれ以上へと、データ量が飛躍的に増え続ける未来への準備が整った」と述べています。

また、次世代のレコメンダー システムの構築をサポートするエンドツーエンドのフレームワークである NVIDIA Merlin も披露しました。このフレームワークは、よりパーソナライズされたインターネットのエンジンとしての地位を急速に確立しつつあります。Merlin によって、100 テラバイトのデータセットからレコメンダー システムを作成するのに必要な時間が、4 日間から 20 分にまで短縮されると、フアンは説明します。

そして、NVIDIA の AI プラットフォームによって引き出された機能を利用できる、リアルタイムのマルチモーダル対話型 AI の開発をサポートする新しいエンドツーエンドのプラットフォームとして、NVIDIA Jarvis についても詳細に解説しました。

フアンはその機能について取り上げたデモの中で、フレンドリーな AI である「Misty」とのやりとりを見せ、Misty が天気に関する一連の高度な質問をリアルタイムで理解し、答える様子を紹介しています。

さらに、2018 年の SIGGRAPH で NVIDIA RTX が発表されてからの、リアルタイム レイ トレーシングにおける NVIDIA の急速な進歩について掘り下げるとともに、NVIDIA Omniverse の提供が早期アクセスのお客様向けに開始されたことも発表しました。NVIDIA Omniverse を利用すると、「同じデザイン上の異なる部分を受け持ち、異なる場所から、異なるツールを使って作業する、それぞれのデザイナー」が、同時に共同作業を行えるようになります。

自律走行車

「現代のコンピューティングにおけるもっとも素晴らしいチャレンジ」とフアンが言う自律走行車は、NVIDIA が NVIDIA DRIVE によって継続的に推し進めている分野です。

NVIDIA DRIVE では、NVIDIA Ampere GPU を内蔵する新しい Orin SoC を採用することで、必要なエネルギー効率とパフォーマンスを達成し、フロントガラス用の 5 W の ADAS システムを提供するだけでなく、2,000 TOPS のレベル 5 ロボタクシー用システムへとスケールアップします。

これにより、自動車メーカーは、共通のコンピューティング アーキテクチャと、共通のソフトウェア スタックですべての車両に AI を組み込むことができます。

「自動車メーカーでは、共通のアーキテクチャに基づく車両開発が可能になり、全車両でソフトウェア開発を活用できるようになります」と、フアンは述べています。

現在、NVIDIA DRIVE エコシステムには、自動車、トラック、ティア 1 自動車サプライヤー、次世代モビリティ サービス、スタートアップ、地図作成サービス、シミュレーションを網羅しています。

また、NVIDIA が自動運転車の全車両を管理するための NVIDIA DRIVE RC を、一連の NVIDIA DRIVE テクノロジに加えることも発表しました。

ロボティクス

NVIDIA はまた、NVIDIA Isaac ソフトウェアデファインド ロボティクス プラットフォームも引き続き推進しています。その一環として、BMW が自社工場で利用するために NVIDIA Isaac のロボティクスを採用したことを発表しました。

世界各国に 30 拠点ある BMW の工場では、56 秒ごとに 1 台の車両が製造されています。これは、世界中の約 2,000 社のサプライヤーから届く、 3,000 万種類もの部品で作られた、それぞれ数百通りのオプションをもつ 40 種類のモデルであると、フアンは説明します。

BMW は、配送、小売、自律移動ロボット、農業、サービス、物流、製造、ヘルスケアにまで広がる、NVIDIA ロボティクスの大規模なグローバル エコシステムに参加しています。

将来、工場は事実上の巨大ロボットになります。「内部で稼働するすべての構成部品が人工知能によって操作されるようになり、将来的には、大量生産される製品はすべてカスタマイズされるようになるでしょう」とフアンは述べています。

※NVIDIA Jarvis の名称は 2021 年 7 月に NVIDIA Riva に変更されました。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE