自動運転技術が「自動化された運転支援システム」というレベルを越えて発展していくために欠かせないのが、360 度全方位に対応する、信頼性の高い障害物認識機能です。

車両の周りに存在する障害物を検出してそれに対応することができなければ、快適かつ安全な運転体験を実現するのは不可能です。通常、自動運転車は多種多様なセンサーをさまざまに組み合わせて搭載することで、信頼性の高い周辺認識機能を実現しています。自動車業界ではサラウンド カメラ センサーとサラウンド レーダー センサーのセットは大量調達が可能であるため、周辺認識システムに向けた主な選択肢の 1 つとなっています。

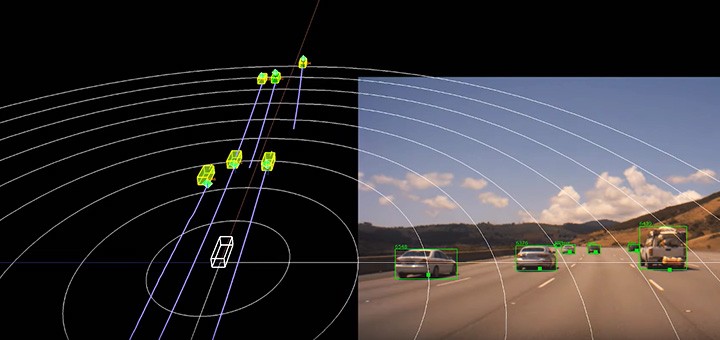

カメラもレーダーも各々長所を持っていますが、それと同時にそれぞれの制約も抱えています。カメラのデータは、そのシーンの意味表示を提供できる一方で、どうしても 3 次元情報には乏しいという性質を持っています。反対に、レーダーのデータは、障害物の距離や速度を推定するのには向いていますが、それを何かと解釈するという面では不十分です。上に掲載した DRIVE ラボのビデオでもその理由を説明しているように、信頼のおける周辺認識機能を実現するには、センサー フュージョン パイプラインを用意して、カメラとレーダーからの 2 種類の認識信号を 1 つにまとめる必要があるのです。

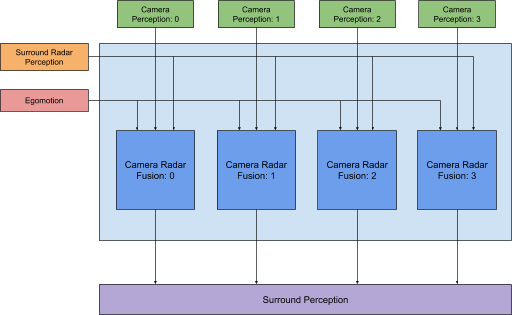

カメラとレーダーのフュージョンは、サラウンド カメラとサラウンド レーダーによる認識パイプラインに基づいて構築されたセンサー フュージョン レイヤーにおいて行います。このレイヤーは、カメラとレーダーそれぞれの相補的な強みを活かし、質の高いセマンティック情報と、正確な位置、速度、加速度情報を合わせて提供できる設計となっています。カメラとレーダーをフュージョンするための中核的な機能は各カメラに対して再利用できるため、パイプライン全体を容易に拡張することが可能となっています。

図 1:サラウンド カメラとサラウンド レーダーのフュージョン処理パイプライン、カメラ 4基 + レーダー 8 基による構成の場合

図 1:サラウンド カメラとサラウンド レーダーのフュージョン処理パイプライン、カメラ 4基 + レーダー 8 基による構成の場合

カメラとレーダーのフュージョン

カメラとレーダーのフュージョン モジュールは、サラウンド カメラとサラウンド レーダーのフュージョン パイプライン (図 1) において主役となる構成要素です。このモジュールでは、単一のカメラから生成されたオブジェクトを、サラウンド レーダーの認識からのオブジェクトとフュージョンします。ここで基本となっているのは、効果的な手法を利用して、あらゆるセンサーのオブジェクトに対してマッチングを行い、それらの認識信号をまとめ上げることで、オブジェクトに関して生成される 3 次元情報の質を高めようという発想です。

前処理

マッチング (つまり、フュージョン) プロセスに用いるカメラ オブジェクトとレーダー オブジェクトの適切な組み合わせを特定するには、前処理が必要となります。この処理はシンプルな手法を使って達成できます。例えばカメラ画像とレーダーの認識との間の共通する物体を調べることにより実現できます。一般的な状況下で遭遇する物体のうち、注目する必要がないものを除外するには、この手法が非常に有効です。

この工程では、フュージョン プロセスを支援するため、物体のデータの更新も行います。ここで特に注意しなければならないのは、カメラとレーダーの認識パイプラインは、それぞれ別個のスレッドで動作しているという点です。また、カメラによる認識機能は通常、レーダーによる認識と異なる更新周期で物体の測定データを生成します。通常、カメラ認識機能の更新周期は、レーダーの更新周期よりも短いことが一般的です。測定データを問題なくフュージョンするには、両種のセンサーからの物体情報の所得をを共通の更新周期でおこなううことが欠かせません。

物体のフュージョン

フュージョン プロセスではまず、両種のセンサー全体にわたる物体のマッチング、すなわち関連付けを行います。これは要するに、2 部マッチング問題であるといえます。カメラ認識機能によって生成された物体のそれぞれについて、どのレーダー認識からの物体が一致するのかを探したり、その逆を考えたりすればよいのです。

フュージョン パイプライン内のこの工程で最も重要なのは、しかるべきマッチングを決定するために、ヒューリスティックな解決策としてコスト メトリックを導き出すことです。コスト メトリックは両種のセンサーからの個々の認識信号の動きを分析することで、データ駆動的に決定されます。このメトリックによって、各種のセンサーからの物体の位置、速度、衝突猶予時間、方位といった信号の相互的な対応関係が表現されます。またこのメトリックでは、物体のマッチング度合いが過去の検知履歴の中でどのように推移しているかも考慮されます。

このコスト メトリックは、両種のセンサーからの物体のペアすべてに対して適用されます。少なくとも 1 つの物体が共通するすべてのペアの中で、最小のコストを持つペアに対応する物体が、マッチングしているものと見なされます。物体同士のマッチングが終わったら、不確実性評価手法を使って認識信号をフユージョンし、信頼性の高い 3 次元信号を生成し、システムの下流にある計画・制御モジュールに送ります。

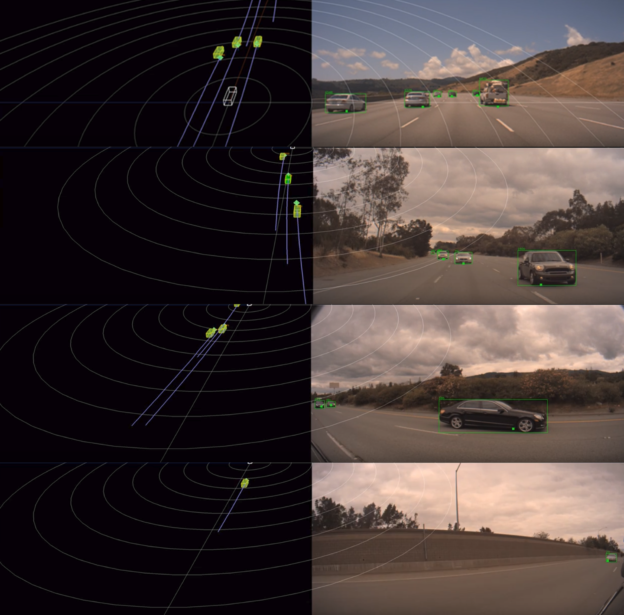

図 2:カメラとレーダーのフュージョンの様子 (カメラ 4 基、レーダー 8基のセンサー構成)。カメラの映像では、カメラ オブジェクトが緑の外枠で、それに対応するレーダー オブジェクトが四角い緑のドットで示されている。3 次元ビューでは、カメラ オブジェクトが黄色の直方体、それに対応するレーダー オブジェクトが緑色の八面体で示されている。紫色の軌跡は、フュージョンされた物体の動作履歴にモーション補正を施して表示したもの。

図 2:カメラとレーダーのフュージョンの様子 (カメラ 4 基、レーダー 8基のセンサー構成)。カメラの映像では、カメラ オブジェクトが緑の外枠で、それに対応するレーダー オブジェクトが四角い緑のドットで示されている。3 次元ビューでは、カメラ オブジェクトが黄色の直方体、それに対応するレーダー オブジェクトが緑色の八面体で示されている。紫色の軌跡は、フュージョンされた物体の動作履歴にモーション補正を施して表示したもの。サラウンド カメラ – レーダ のフュージョン機能は柔軟に設計されており、カメラ 6基 + レーダー 8 基、カメラ 4基 + レーダー 8 基、カメラ 2基 + レーダー 4 基、カメラ 1基 + レーダー 1 基といった多様なセンサー構成をサポートしています。この機能は NVIDIA DRIVE ソフトウェア 10.0 のリリースとともに、開発者に向けて提供されます。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE