編集部注:本稿は、2016年のNVIDIAグローバル・インパクト・アワードの最終候補5組のプロフィールを紹介する記事の1つです。このアワードでは、社会的な問題、人道的な問題、環境問題に対処するための革新的な研究をNVIDIAの技術を利用して行った研究者に、賞金$150,000を授与します。

2030年までに世界から貧困を根絶すること――これは、国連が昨年後半に発表した「持続可能な開発のためのアジェンダ」の第一目標の1つです。しかし、データ不足が、この目標に向けた進捗状況の測定を妨げています。

極度の貧困のなかで暮らす人々の大半をかかえるサハラ以南アフリカや南アジアの地域では、正確な貧困データが十分に取れていません。そこで、スタンフォード大学の小人数のチームが、衛星画像で少しずつこの状況を変えようと取り組んでいます。

機械学習の専門家であるステファノ・エルモン(Stefano Ermon)氏は、Google Earthの画像を貧困の統計モデルへと変換するため、食料安全保障の専門家であるデイビッド・ローベル(David Lobell)氏やマーシャル・バーク(Marshall Burke)氏、そしてスタンフォード大学工学部の学生2名とチームを結成しました。

スタンフォード大学コンピュータ・サイエンスの助教授であるエルモン氏は、次のように述べています。「極度の貧困をなくすことが私たちの目標ですが、それには、活動が進展しているかどうかを測定できる手段が必要です」

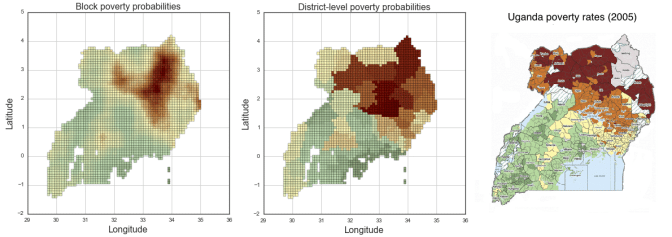

左:10km x 10kmのブロック・レベルで細分化された貧困確率の予測、中央:地域レベルで集約された貧困確率の予測、右:比較用の2005年の調査結果(出典:World Resources Institute、2009年)

同チームは、NVIDIA GPUを利用して、道路、農地、住宅などの画像特徴から、サハラ以南アフリカの貧困レベルを正確に予測するため、ニューラル・ネットワークのトレーニングを行いました。

この取り組みにより、スタンフォード大学のチームは、2016年のNVIDIAグローバル・インパクト・アワードの最終候補5組の1つに選ばれました。NVIDIAは、社会的な問題、人道的な問題、環境問題に対処するための革新的な研究をNVIDIAの技術を利用して行った研究者に、賞金$150,000を授与しています。

エルモン氏は次のように説明します。「サハラ以南アフリカ諸国のなかには、私たちの手元にある最新データが20年前のものという国もあります。つまり、私たちは、いまだに90年代前半の予測から推定を行っているわけです。そのため、より正確なデータが早急に必要なのです」

従来のディープラーニング・ソリューションには、ニューラル・ネットワークを構築するためのトレーニング用データセットが必要です。トレーニング用の衛星画像データがほとんどないことから、同チームでは転移学習を利用しています。転移学習では、1つのタスクに関するスキルをマシンに学習させることで得られた知識を、別の用途に利用できます。

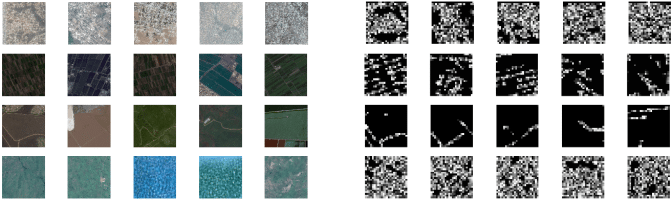

まず、Google EarthとGoogle画像検索から、同じ地域の日中と夜間の状況を撮影した衛星画像をペアで取り込みます。従来の貧困画像モデルでは、写真に写る夜間の光の明るさを、経済発展の指標として利用します。一方、新しいモデルでは、日中と夜間の両方の画像を使うことで、ラベルなしデータセット(道路、農地、水域など)から、貧困と相関性のある有用な日中の特徴を識別できるようになりました。

「私たちは、これまでより少ないパラメータでより大きな画像を処理できる、完全な畳み込みアーキテクチャにたどり着きました。そして、NVIDIA GPUによって、そのトレーニングをより高速に実行できます」と、エルモン氏。

左:各行は、ニューラル・ネットワークの各フィルタ(市街地、農地・格子状のパターン、道路、水域・平原・森林)で最大限活性化する画像を5枚ずつ示しています。右:左側の対応画像に対するフィルタの活性化。(画像出典:Google Static Maps)

チームは、NVIDIAのGeForce GTX TITAN XとTesla K40 GPUを使用して、画像分析を加速させました。GPUで加速化したライブラリでは、最終モデルのトレーニングがわずか3日で完了しました。

「本当に助かりました。GPUがなければ、実現しなかったでしょう」とエルモン氏は振り返ります。

最近、エルモン氏とチームは、ウガンダの貧困マップを作成した際の研究方法に関する論文を発表しました。画像のダウンロードから、ネットワークのトレーニング、そのデータに基づく予測の作成まで、チームの全工程がGitHubで近日中に公開される予定です。

同チームは現在、その活動をナイジェリア、マラウィ、ルワンダの衛星画像に広げています。トレーニングはウガンダのデータに対して行われたものですが、同チームのシステムは、他の国の貧困レベルも正確に予測できます。エルモン氏の目標は、このモデルをアジアや南米の貧困マップの作成に拡大するとともに、貧困の経時的な変化を分析することです。

「私たちは、非常に低コストのデータに基づき、とても高い解像度でこれらの貧困マップを自動生成できるプラットフォームを手に入れました。必要なのは、画像だけです」と、エルモン氏は言います。このスケーラブルなモデルは、より大きな時間スケールで貧困マップを作成できる新たな可能性をもたらします。「私たちは、場所や時間とともに状況が変化する過程について、これまでは不可能だったような理解を得られるようになってきています」

2016年のグローバル・インパクト・アワードの受賞者は、4月4~7日にシリコンバレーで開催されるGPUテクノロジ・カンファレンスで発表されます。

2016年のグローバル・インパクト・アワードでのその他の候補者

ハイチの地震を機に生まれた、GPUによる構造安全性の新たなマッピング方法

インペリアル・カレッジ、GPUによって脳損傷領域の特定方法を開発

昨年のNVIDIAグローバル・インパクト・アワード受賞者の研究についてもご覧ください。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE