Black Forest Labs の FLUX.1 Kontext [dev] 画像編集モデルが、NVIDIA NIM マイクロサービスとして利用可能になりました。

FLUX.1 モデルでは、ユーザーは単純な言語で既存の画像を編集できます。ファインチューニングや複雑なワークフローを必要としません。

強力な AI を展開するには、モデルの種類のキュレーション、すべての入力および出力データを管理するための調整、VRAM 要件を低減するための量子化などが必要とされます。モデルは、最適化された推論バックエンド ソフトウェアと連携するように変換され、新しい AI アプリケーション プログラミング インターフェイスに接続される必要があります。

FLUX.1 Kontext [dev] NIM マイクロサービスはこのプロセスを簡素化し、より高速な生成 AI ワークフローを可能にしており、そして RTX AI PC 向けに最適化されています。

Kontext の生成 AI

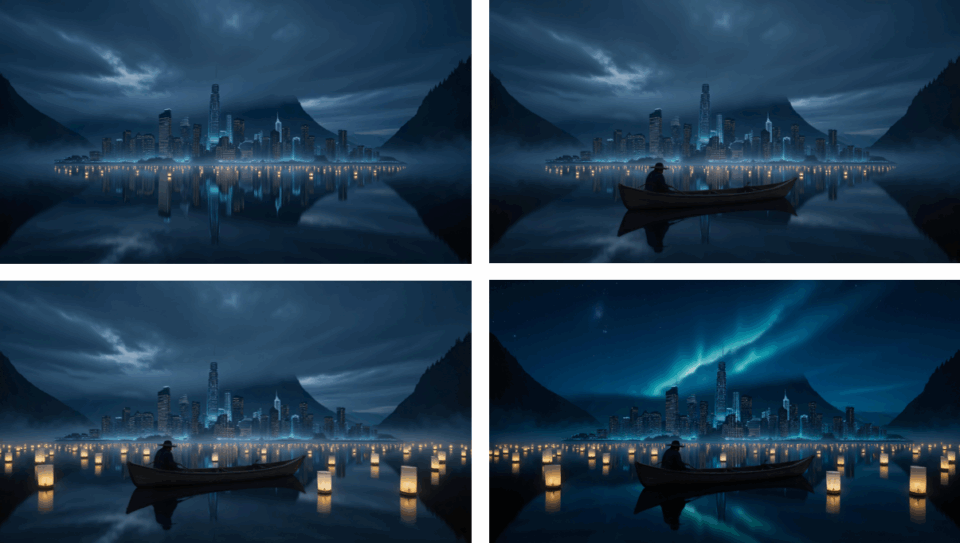

FLUX.1 Kontext [dev] は、画像編集用に構築されたオープンウェイト生成モデルです。 ガイド付きのステップバイステップの生成プロセスを特徴とし、細かなディテールの調整やシーン全体を変化させることまで、画像の変化をより簡単に制御できます。

FLUX.1 Kontext [dev] NIM マイクロサービスは ComfyUI NIM ノードを通じて、ワンクリックでダウンロード可能なパッケージ化済みの最適化されたファイルを提供するため、ユーザーは簡単にアクセスできます。

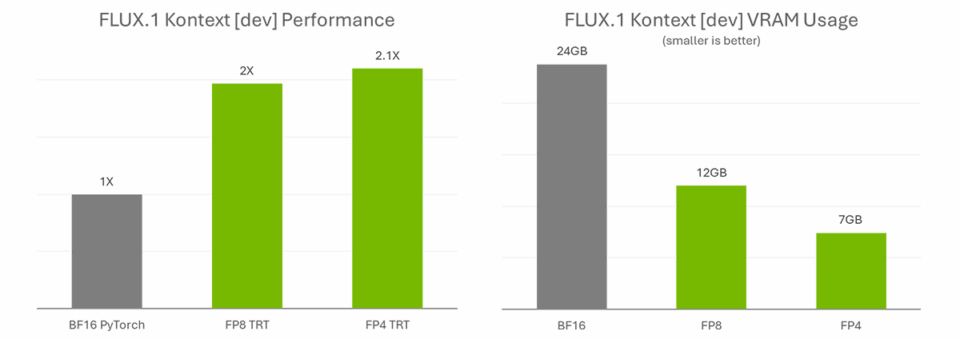

NVIDIA と Black Forest Labs は協力して FLUX.1 Kontext [dev] を量子化し、FP8 (NVIDIA Ada Generation GPU) 向けには 24 GB から 12 GB に、FP4 (NVIDIA Blackwell アーキテクチャ) 向けには 7 GB にモデル サイズを削減しました。FP8 チェックポイントは、Tensor コア に FP8 アクセラレータを搭載した GeForce RTX 40 シリーズ GPU 向けに最適化されています。FP4 チェックポイントは、GeForce RTX 50 シリーズ GPU 向けに最適化されており、モデル サイズを縮小しつつ高画質を維持する SVDQuant と呼ばれる新しい方法を使用します。

これらの劇的なパフォーマンス向上の恩恵を受けられるのは、これまでならば AI の専門家や開発者といった高度な AI インフラの知識を持つ方に限られていました。FLUX.1 Kontext [dev] NIM マイクロサービスにより、愛好家であってもより高いパフォーマンスで生成にかかる時間を節約できます。

NIMble を手に入れる

FLUX.1 Kontext [dev] は、TensorRT 最適化と ComfyUI を備えた Hugging Face で利用できます。

利用を開始するには、ComfyUI の NIM ノード GitHub の指示に従ってください。

- NVIDIA AI Workbench をインストールします。

- ComfyUI を入手します。

- アプリ内の ComfyUI Manager を通じて NIM ノードをインストールします。

- Black Forest Labs の FLUX.1 Kontext にある [dev] Hugging Face でモデル使用許諾契約に同意します。

- ノードは、「Run」をクリックすると目的のワークフローを準備し、必要なすべてのモデルのダウンロードを支援します。

NIM マイクロサービスは、NVIDIA GeForce RTX および RTX PRO GPU でパフォーマンスが最適化されているほか、AI コミュニティで人気のモデルが含まれています。GitHub および build.nvidia.com では 多様な NIM マイクロサービスをご覧いただけます。

RTX AI Garage ブログ シリーズでは、NVIDIA NIM マイクロサービスと AI Blueprint について詳しく知りたい方や、AI PC とワークステーションで AI エージェント、クリエイティブなワークフロー、生産性アプリなどを構築する方向けに、コミュニティ主導の AI イノベーションとコンテンツを紹介しています。

Facebook、Instagram、TikTok、X で NVIDIA AI PC をフォローし、RTX AI PC ニュースレターを購読して、最新情報を入手しましょう。 NVIDIA の Discord サーバーに参加してコミュニティの開発者や AI 愛好者とつながり、RTX AI の可能性について話し合いましょう。

LinkedIn と X で NVIDIA Workstation をフォローしてください。

ソフトウェア製品情報に関するお知らせをご覧ください。