数十億のトークンを含むデータセットでトレーニングされた大規模言語モデル (LLM) は、高品質のコンテンツを生成できます。 チャットボット、アシスタント、コード ジェネレーターなど、最大級の人気を持つ AI アプリの多くにとって、要となる構成要素です。

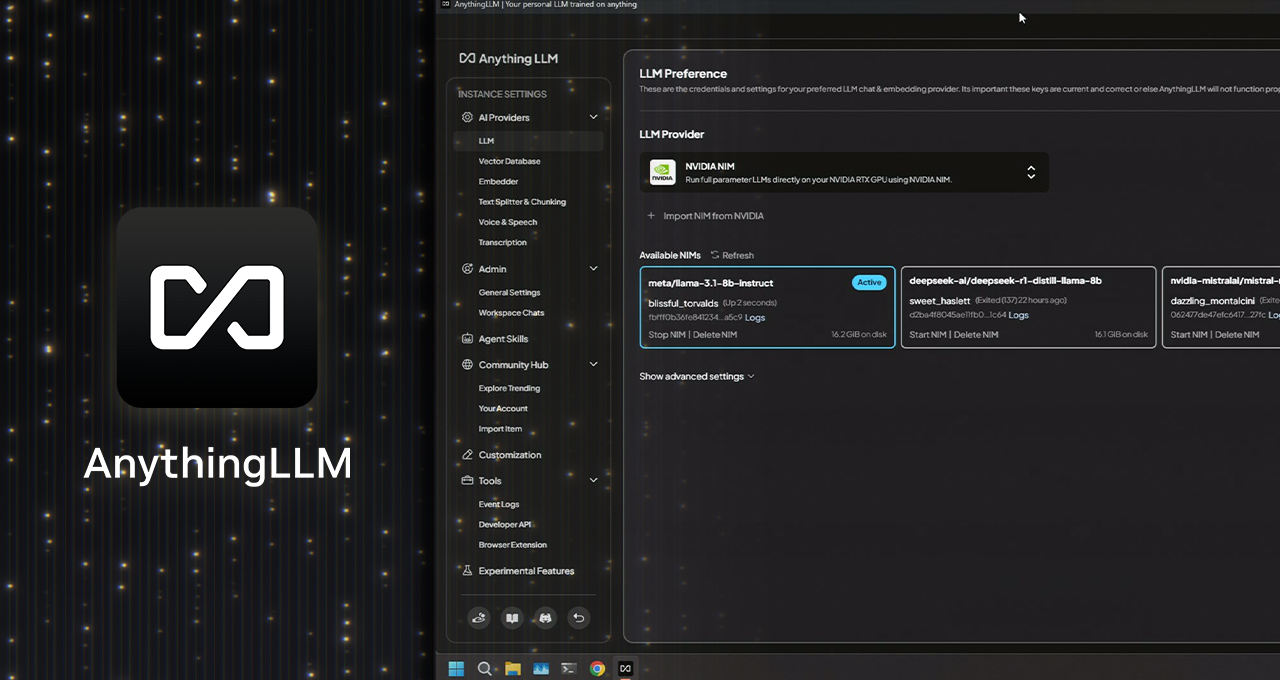

現在 LLM と作業する最もアクセスしやすい方法の 1 つが、AnythingLLM です。このデスクトップ アプリは、プライバシーを重視したオールインワンの AI アシスタントを PC で直接利用したいユーザー向けに構築されました。

NVIDIA GeForce RTX と NVIDIA RTX PRO GPU での NVIDIA NIM マイクロサービスの新しいサポートにより、AnythingLLM ユーザーはさらに高速なパフォーマンスを実現し、応答性の高いローカル AI ワークフローを実現できるようになりました。

AnythingLLM とは何か?

AnythingLLM は、ローカルの LLM、Retrieval-Augmented Generation (RAG) システム、エージェント ツールを実行できるオールインワン AI アプリケーションです。

ユーザーの好みの LLM とデータ間の橋渡し役として機能し、ツール (スキル) へのアクセスを可能にし、以下のような特定のタスクで LLM をより簡単かつ効率的に使用できるようにします。

- 質問に答える: Llama や DeepSeek R1 などのトップ LLM から、費用をかけることなく質問に対する答えを得ることができます。

- 個人データ クエリ: RAG を使用して、PDF、Word ファイル、コードベースなど、コンテンツをプライベートにクエリできます。

- ドキュメントの要約: 研究論文など、長い文書の要約を生成します。

- データ分析: ファイルを読み込み、LLM を使用してクエリを行うことで、データからインサイトを抽出します。

- エージェンティックアクション: ローカルまたはリモートのリソースを使用してコンテンツを動的に調査し、ユーザーのプロンプトに基づいて生成ツールとアクションを実行します。

AnythingLLM は、OpenAI、Microsoft、Anthropic などが提供するさまざまなオープンソースのローカル LLM や、クラウド内のより大規模な LLM に接続できます。 さらに、このアプリケーションでは、コミュニティハブを通じてエージェント型 AI 機能を拡張するためのスキルにアクセスできます。

AnythingLLM は、ワンクリックでインストールでき、スタンドアロンアプリまたはブラウザ拡張機能として起動でき、複雑な設定を必要とせずに直感的に操作できるため、特に GeForce RTX と NVIDIA RTX PRO GPU を搭載したシステムをお持ちのユーザーに最適な選択肢です。

RTX が AnythingLLM 高速化を強化

GeForce RTX と NVIDIA RTX PRO GPU は、AnythingLLM で LLM とエージェントを実行するときに大幅なパフォーマンスの向上を実現し、AI を高速化するように設計された Tensor コアにより推論速度が向上します。

AnythingLLM は Ollama で LLM を実行し、機械学習のための Llama.cpp と ggml tensor ライブラリを通じてデバイスでの実行を高速化します。

Ollama、Llama.cpp、GGML は、NVIDIA RTX GPU と 第 5 世代 Tensor コア向けに最適化されています。 GeForce RTX 5090 のパフォーマンスは Apple M3 Ultra の 2.4 倍です。

GeForce RTX 5090 は Llama 3.1 8B と DeepSeek R1 8B の両方で Apple M3 Ultra より LLM 推論が 2.4 倍高速です。

NVIDIA は、AI プループリントのライブラリの増加など、新しい NIM マイクロサービスとリファレンス ワークフローを追加するにつれて、AnythingLLM などのツールによって、さらに多くのマルチモーダル AI ユース ケースが可能になります。

AnythingLLM — NVIDIA NIM を搭載

AnythingLLM は最近、NVIDIA NIM マイクロサービスのサポートを追加しました。このマイクロサービスは、効率化された API を使用して RTX AI PC で AI ワークフローを簡単に開始できる、パフォーマンスが最適化されたパッケージ済み 生成AI モデルです。

NVIDIA NIM は、ワークフローで生成 AI モデルを迅速にテストしたい開発者にとって最適です。 適切なモデルを見つけ、すべてのファイルをダウンロードし、すべてを接続する方法を理解する代わりに、必要なものがすべて揃った単一のコンテナが提供されます。 また、クラウドと PC の両方で実行可能で、ローカルでプロトタイプを構築し、その後クラウドに展開することが容易です。

AnythingLLM のユーザーフレンドリーな UI を通じてこれらを提供することで、ユーザーは迅速にテストや実験を行うことができます。 その後、AnythingLLM でワークフローに接続するか、NVIDIA AI ブループリントと NIM ドキュメントおよびサンプルコードを活用して、アプリやプロジェクトに直接接続できます。

言語と画像の生成、コンピュータービジョン、音声処理など、AI を活用したワークフローを強化するさまざまな NIM マイクロサービスをご覧ください。

毎週、RTX AI Garage ブログ シリーズでは、NIM マイクロサービスと AI Blueprint の詳細を知りたい方や、AI PC とワークステーションにおける AI エージェント、クリエイティブなワークフロー、デジタル ヒューマン、生産性アプリなどを構築する方向けにコミュニティ主導の AI イノベーションとコンテンツを紹介しています。

Facebook、Instagram、TikTok、X で、NVIDIA AI PC に接続し、RTX AI PC ニュースレターを購読すると最新情報を確認できます。

LinkedIn と X で NVIDIA Workstation をフォローしてください。

ソフトウェア製品情報に関するお知らせをご覧ください。