GPU のための NVIDIA AI プラットフォーム上で実行することでインターネットはよりパーソナライズされたものになり、Snap、Postmates、Tencent を後押し

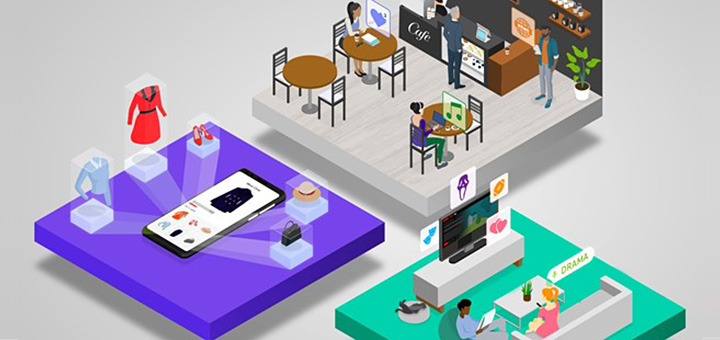

レコメンダーは、インターネットをパーソナライズします。ビデオ、食品、スニーカー、広告を提案し、まるで魔法のようにあなたの好みや興味を知ることができます。

それは、オンライン体験をより楽しく、効率的なものにするための AI であり、あなたが見たいものに素早く導きます。あなたが好きなコンテンツを提供する一方で、ジーンズの魅力的な広告をターゲットにしたり、深夜に食べたくなるような料理を勧めたりします。

しかし、すべてのレコメンダー システムが、よりスマートな提案を行うために必要なデータを処理できるわけではありません。そのため、トレーニングが遅くなり、インターネットでのユーザー体験が直感的ではなくなります。

NVIDIA Merlin は、レコメンダーを加速し、トレーニングや推論を強化しています。メディア、エンターテインメント、およびオンデマンド デリバリーのリーダーは、このオープンソースのレコメンダー フレームワークを使って、GPU 上でアクセラレーションされたディープラーニングを実行しています。レコメンデーションの改善は、クリック数、購入数、ひいては満足度の向上につながります。

Merlin が高速化するレコメンダー

NVIDIA Merlin によって、あらゆるタイプの企業が NVIDIA GPU によって高速化されるレコメンダーを構築することができます。

そのライブラリーのコレクションには、従来の方法よりも優れた予測を提供し、クリック数を増やすディープラーニング ベースのシステムを構築するためのツールが含まれています。パイプラインの各ステージは、数百テラバイトのデータをサポートできるように最適化されており、使いやすい API によってすべてアクセスできます。

現在、世界中の数百社の企業が Merlin のテストを行っています。ソーシャル メディアおよびビデオ サービス企業は、次の表示や広告に関する提案について評価しています。また、大手オンデマンド アプリおよび小売企業は、合わせて購入する商品に関する提案について検討しています。

Snap:ビデオ

Snap は、Merlin によってコンテンツや広告のランク付けを 60% 高速化し、ロード時間を短縮することで顧客体験を改善させるとともに、インフラストラクチャ コストを削減しています。GPU と Merlin を使用することにより、同社はより複雑で正確なランキング モデルを探索するためのさらなるコンピューティング能力を得ています。これらの改善により、より魅力のある体験をより低いコストで提供できるようになっています。

Tencent:クリックされる広告

中国の大手オンライン ビデオ メディア プラットフォームは、Merlin HugeCTR を使用して、毎月 5 億人を超えるアクティブ ユーザーと適切かつ魅力的な広告を結び付けています。そのような巨大なデータセットの場合、トレーニングのスピードが重要であり、レコメンダー モデルのパフォーマンスを左右します。Tencent は、Merlin によるリアルタイム トレーニングを展開し、同じ GPU プラットフォーム上で元の TensorFlow ソリューションと比べて 7倍以上の高速化を達成しました。Tencent はこれについて、GTC でのプレゼンテーションでさらに詳しく取り上げます。

Postmates:食事内容を提案

Merlin は、レコメンダー ワークフローを合理化するために開発されています。Postmates はレコメンダーを使用して、人々が夕食に何を食べるかを決める手助けをしています。同社はMerlin NVTabular を使用して、CPU 上で 1 時間を要していたトレーニング時間を最適化し、GPU 上でわずか 5 分に短縮しました。

また、特徴量エンジニアリングに NVTabular を使用することで、トレーニング コストを 95% 削減したほか、さらに高度なディープラーニング モデルの可能性を探っています。Postmates はこれについて、GTC でのプレゼンテーションでさらに詳しく取り上げます。

Merlin は大規模なレコメンダー ワークフローを合理化

Merlin は相互運用可能なため、レコメンダーのワークフロー パイプラインを高速化する柔軟性を備えています。

Merlin レコメンデーション エンジンのオープン ベータ リリースは、データ ローディングおよびディープラーニング システムのトレーニングを飛躍的に改善します。

NVTabular は、特徴量の変換や前処理を GPU で高速化することで、データの準備時間を短縮します。膨大なデータ レイクをトレーニング パイプラインにロードすることを容易にする NVTabular は、マルチ GPU をサポートしたほか、TensorFlow および PyTorch との相互運用性も向上しています。

トレーニングにおける Merlin の魔法

Merlin HugeCTR はメインのトレーニング コンポーネントです。ディープラーニング レコメンダー システムのトレーニング用に設計されていることに加え、独自の最適化されたデータ ローダーを備えているため、汎用のディープラーニング フレームワークのパフォーマンスを大幅に上回ります。また、HugeCTR は NVTabular で前処理されたデータを理解する Parquet データ リーダーも備えています。HugeCTR は、レコメンダー ワークフロー向けに特別に設計されたディープ ニューラルネットワーク トレーニング フレームワークであり、複数の GPU やノードにわたる分散トレーニングによって最大限のパフォーマンスを発揮します。

NVIDIA Triton Inference Server は、特徴量変換やニューラルネットワーク実行のためにGPU上での本番環境の推論を高速化します。

NVTabular、HugeCTR、NVIDIA Triton Inference Server のサポートなど、Merlin を登場以来支えてきたテクノロジの進歩についてご覧ください。