コンフィデンシャル コンピューティングと 2 つの新しい NVIDIA 搭載インスタンスは、Azure の顧客のための生成 AI の可能性を広げます。

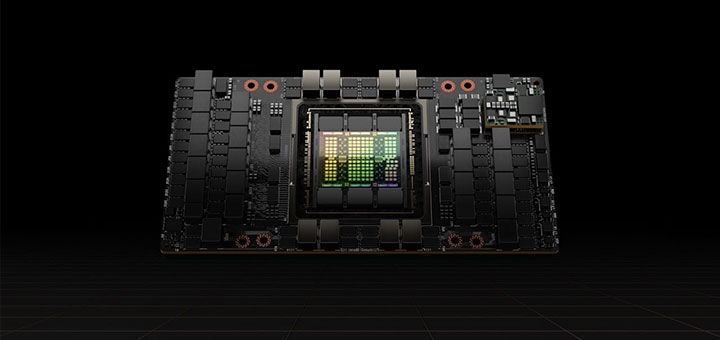

NVIDIA は、最先端の AI インフラストラクチャを構築するために Microsoft との協業を続けています。この度、Microsoft は、要求の厳しい AI ワークロードを加速するために、Microsoft Azure に H100 ベースの仮想マシンを追加導入します。

先日シアトルで開催された Ignite カンファレンスにて、Microsoft は Azure 向けの新しい NC H100 v5 VM シリーズを発表しました。これは、NVIDIA H100 NVL GPU を搭載する業界初のクラウド インスタンスです。

これは、NVIDIA NVLink を介して接続された PCIe ベースの H100 GPU のペアをまとめたもので、約 4 ペタフロップスの AI 演算と 188GB の高速な HBM3 メモリを搭載しています。NVIDIA H100 NVL GPU は、GPT-3 175B にて前世代よりも最大 12 倍高い性能を発揮し、推論やメインストリームのトレーニング ワークロードに最適です。

さらに Microsoft は、レイテンシを増加させることなく、より大規模なモデルの推論をサポートするために、NVIDIA H200 Tensor コア GPU を来年 Azure フリートへ追加する計画を発表しました。これは、LLM や生成 AI モデルなど、最大規模の AI ワークロードを高速化することを目的として構築されています。

H200 GPU は、最新世代の HBM3e メモリを使用し、メモリ容量と帯域幅の両方で劇的な向上をもたらします。H100 と比較して、この新しい GPU は 141GB の HBM3e メモリ (1.8 倍増) と毎秒 4.8TB のピークメモリ帯域幅 (1.4 倍増) を提供します。

クラウド コンピューティングがコンフィデンシャルに

NVIDIA が加速する生成 AI コンピューティングの可用性をさらに拡大するため、Microsoft は Azure の顧客向けに、NVIDIA を搭載したもう 1 つのインスタンス、NCC H100 v5 を発表しました。

NVIDIA H100 Tensor コア GPU を搭載したこれらの Azure コンフィデンシャル VM により、顧客は H100 GPU の卓越したアクセラレーションにアクセスしながら、使用中のデータやアプリケーションの機密性と完全性をメモリ上で保護できます。これらの GPU で強化されたコンフィデンシャル VM は、近日中にプライベート プレビューが開始される予定です。

NVIDIA H100 Tensor コア GPU を搭載した新しいコンフィデンシャル VM の詳細とプレビューへのサインアップについては、ブログをご覧ください。

GPU VM の情報ページで、NVIDIA を搭載した Azure インスタンスの詳細をご覧ください。