カンファレンスで 4 つの講演を通じて、NVIDIA のエンジニアが NVIDIA Blackwell プラットフォーム、液体冷却に関する新しい研究、チップ設計をサポートする AI エージェントについて詳しく解説

産業界と学界に身を置くプロセッサ アーキテクトおよびシステム アーキテクトのための高度なテクノロジ カンファレンスが、1 兆ドル規模のデータセンター コンピューティング市場にとって重要なフォーラムとなっています。

Hot Chips 2024 では、NVIDIA のシニア エンジニアが、NVIDIA Blackwell プラットフォームを支える最新の進歩、データセンター向けの液体冷却、チップ設計用の AI エージェントに関する研究について発表しました。

発表内容は以下のとおりです。

- NVIDIA Blackwell は、複数のチップ、システム、NVIDIA CUDA ソフトウェアを統合し、ユース ケース、業界、国を超えて次世代の AI を実現します。

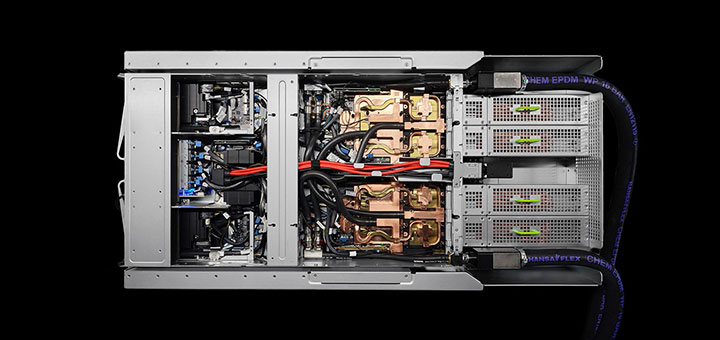

- NVIDIA GB200 NVL72 – 72 基の Blackwell GPU と 36 基の Grace CPU を接続した、マルチノード、液冷式、ラックスケール ソリューションが、AI システム設計の基準を高めます。

- NVLink インターコネクト テクノロジは、全 GPU 間の通信を提供し、生成 AI の記録的な高スループットと低レイテンシの推論を可能にします。

- NVIDIA Quasar Quantization System は、物理学の限界を押し広げ AI コンピューティングを加速します。

- NVIDIA の研究者は、AI 用プロセッサの開発に役立つ AI モデルを構築中です。

NVIDIA Blackwell を紹介する講演は 8 月 26 日 (月) に開催され、新しいアーキテクチャの詳細と Blackwell シリコン上で実行される生成 AI モデルの例にも焦点を当てて説明されました。

8 月 25 日 (日) には 3 つのチュートリアルが開催され、ハイブリッド液冷ソリューションがデータセンターをよりエネルギー効率の高いインフラに移行するのにどのように役立つか、また、大規模言語モデル (LLM) 搭載エージェントなどの AI モデルがエンジニアの次世代プロセッサ設計にどう貢献するのかについて説明しました。

同時に、プレゼンテーションでは NVIDIA のエンジニアがデータセンター コンピューティングと設計のあらゆる分野で革新的な取り組みを行い、これまでにないパフォーマンス、効率性、最適化を実現している方法を紹介しました。

Blackwell に備える

NVIDIA Blackwell は究極のフルスタック コンピューティングの挑戦です。Blackwell GPU、Grace CPU、BlueField データ プロセッシング ユニット、ConnectX ネットワーク インターフェイス カード、NVLink Switch、Spectrum Ethernet スイッチ、Quantum InfiniBand スイッチなど、複数の NVIDIA チップで構成されています。

NVIDIA のアーキテクチャ ディレクターである Ajay Tirumala (アジェイ ティルマラ) と Raymond Wong (レイモンド ウォン) がこのプラットフォームを初めて公開し、これらのテクノロジがどのように連携することで AI とアクセラレーテッド コンピューティングのパフォーマンスの新しい標準を提供し、同時にエネルギー効率を向上させるのか説明しました。

マルチノード NVIDIA GB200 NVL72 ソリューションは絶好の例です。LLM 推論には低レイテンシで高スループットのトークン生成が必要です。GB200 NVL72 は統合システムとして機能し、LLM ワークロードの推論を最大 30 倍高速化し、兆単位のパラメータ モデルをリアルタイムで実行できるようにします。

Tirumala と Wong はまた、アルゴリズムのイノベーション、NVIDIA ソフトウェア ライブラリとツール、Blackwell の第 2 世代 Transformer Engine を統合した NVIDIA Quasar Quantization System が低精度のモデルで高精度を発揮する方法についても説明し、LLM とビジュアル生成 AI を使用した例を取り上げました。

データセンターの冷却

研究者がハイブリッド冷却 (つまり空冷と液冷を組み合わせて効率性と持続可能性を向上させたソリューション) の開発を進めるにつれ、空冷式データセンターで従来聞かれた騒音は過去のものになるかもしれません。

液冷テクノロジは、空冷よりも効率的にシステムから熱を逃がすため、大量のワークロードを処理しているときでもコンピューティング システムを冷却状態に保つことが容易になります。液冷用の機器は空冷システムよりも場所を取らず消費電力も少ないため、データセンターではその分施設内にサーバー ラックを追加でき、結果的にコンピューティング性能も向上します。

NVIDIA のデータセンター冷却およびインフラ担当ディレクターのAli Heydari (アリ ヘイダリ) が、ハイブリッド冷却式データセンターの設計をいくつか紹介しました。

既存の空冷式データ センターに液冷ユニットを後付けし、既存のラックに液冷機能を追加する迅速かつ簡単なソリューションを実現する設計もあります。その他の設計では、冷却分配ユニットを使用してダイレクト チップ液冷のための配管を設置したり、サーバー全体を液浸冷却タンクに沈めたりする必要があります。これらのオプションは大きな初期投資を必要としますが、エネルギー消費と運用コストの両方を大幅に節約できます。

Heydari は、高度なデータセンター冷却技術を開発する米国エネルギー省のプログラム COOLERCHIPS の一環として Heydari のチームが行っている研究についても紹介しました。このプロジェクトの一部として、チームは NVIDIA Omniverse プラットフォームを使用して物理学に基づいたデジタル ツインを作成し、エネルギー消費と冷却効率をモデル化してデータセンター設計を最適化しています。

AI エージェントがプロセッサ設計に貢献

半導体設計は、ミクロのテクノロジでの巨大な挑戦です。最先端のプロセッサを開発するエンジニアは、数インチ幅のシリコン片に可能な限り多くのコンピューティング性能を収めようと努力し、物理的に可能な限界に挑戦しています。

AI モデルは、設計品質と生産性の向上、手動プロセスの効率化、時間のかかるタスクの自動化により、エンジニアの作業をサポートしています。AI モデルには、エンジニアが設計を迅速に分析して改善することが可能になる予測および最適化ツール、エンジニアの質問への回答やコード生成、設計上の問題のデバッグに役立つ LLM が含まれています。

NVIDIA のデザイン オートメーション リサーチ ディレクターディレクターの Mark Ren (マーク レン) が、これらのモデルとその用途の概要をチュートリアルで説明しました。2 つ目のセッションでは、チップ設計用のエージェントベースの AI システムを中心に説明しました。

LLM を搭載した AI エージェントは、タスクを自律的に完了するように指示できるため、さまざまな業界で幅広いアプリケーションが実現します。マイクロプロセッサ設計では、NVIDIA の研究者は、カスタマイズされた回路設計ツールを用いて推論やアクションを実行できるほか、経験豊富な設計者との対話や、人間やエージェントの経験から取得したデータベースからの学習が可能なエージェントベースのシステムを開発しています。

NVIDIA のエキスパートはこのテクノロジをただ構築しているだけでなく、実際に使用しています。エンジニアが AI エージェントを使用してタイミング レポート分析、セル クラスターの最適化 プロセス、コード生成を行っており、Ren がその様子を紹介しました。セル クラスターの最適化は最近、第 1 回 IEEE International Workshop on LLM-Aided Design (IEEE 主催 LLM 支援設計国際ワークショップ) で最優秀論文賞を受賞しました。