NVIDIA CEO のジェンスン フアンがより強力なサーバー システムの開発を可能にする HGX-2 を発表

NVIDIA CEO のジェンスン フアン (Jensen Huang) は、GTC Taiwan にて、クラウド サーバーを構成するプラットフォーム、「HGX-2」を発表しました。これによって、サーバー メーカーは NVIDIA GPU を活用し、ハイ パフォーマンス コンピューティングや AI 向けにより強力なシステムを開発することが可能になります。

これは、この 5 年間で 500 倍に成長し、すべてのコンピューター メーカーや ISV を含むエコシステムによってサポートされているコンピューティング プラットフォームの最新製品です。フアンは、水曜日の GTC (GPU テクノロジ カンファレンス) Taiwan において、そう語りました。

フアンは、GPU は世界中で数兆ドル規模の産業を変革する勢いであるコンピューティング エコシステムの中心に位置すると指摘した上で、処理能力のさらなる向上により実現寸前である材料科学、エネルギー、医薬品における一連のブレークスルーについて説明しました。

「コンピューティング需要は、これまでにも増して、かつてないほど増加しています。このコンピューティング パフォーマンスは、今後も、ムーアの法則を延命する必要があります。」台北の会場を埋め尽くした 2,000 人以上の技術者、開発者、研究者、政府関係者、メディアを前に、フアンはそう語りました。GTC Taiwan は、NVIDIA が今年、世界の主要ハイテク都市で開催を予定している 7 回の AI カンファレンスの 2 回目です。

処理能力の大幅な向上

地域および多国籍企業からの専門家による AI のトピックに関するブレイクアウト セッションの初日は、2 時間に及ぶフアンの基調講演で始まりました。

フアンは、GPU によるディープラーニングがもたらすテクノロジの「カンブリア爆発」について詳しく説明しました。GPU の処理能力は、10 年足らずで 20 倍に成長しました。これは年 1.7 倍の成長率に相当し、ムーアの法則をはるかに超えています。

フアンは、そうした処理能力の需要は AI のおかげで「高まる一方で、鈍化の兆しは見えない」と述べ、「これ以前には人間がソフトウェアを作成していました。ソフトウェア エンジニアが書けるコードの量には限度がありますが、マシンは疲れ知らずですからね」と語りました。

「データがある限り、アーキテクチャの開発方法に関する知識がある限り、絶対的に大規模なソフトウェアを開発できます。いずれ、ソフトウェアを開発する世界中のあらゆる企業が AI スーパーコンピューターを必要とするようになるでしょう。」

サーバー プラットフォームの利用拡大

そうした方向への新たな一歩がシングル クラウドサーバー プラットフォーム「NVIDIA HGX」の第 2 世代です。

HGX-2 は、16 基の NVIDIA Tensor コア GPU をリンクして 1 基の巨大な GPU として動作させる NVSwitch インターコネクト ファブリックなどの画期的な機能を搭載しています。パートナーは、HGX-2 ベースのシステムを今年後半に初めて投入する予定です。

フアンは、コンピューター業界全体に広がる NVIDIA のパートナーのサポートに感謝しながら、次のように述べました。「皆さんのパートナーシップにより、誰でも望めば HPC (ハイ パフォーマンス コンピューティング) や AI と融合したこの未来のコンピューティングを利用できる状況にあります。我々にはありとあらゆる種類のサーバーがあります。」

単なる大型からさらなる大型へ

HGX-2 の中核をなすのは、32GB の高帯域幅メモリを搭載し、125 TeraFLOPS のディープラーニング パフォーマンスを実現する NVIDIA Tesla V100 GPU です。

NVSwitch によって 16 基もの Tesla V100 GPU を組み合わせることにより、フアンが「世界最大の GPU」と呼ぶものが得られます。

フアンは、次のように説明しました。「GPU の 1 基 1 基が、PCI Express の 10 倍に相当する 300 GB/s の帯域幅で、他のすべての GPU と同時に通信することができます。つまり、全 GPU 間の同時相互通信が可能ということです。」

また、HGX-2 サーバー プラットフォームを使用して構築された最初のシステムである最新の NVIDIA DGX-2 についても詳しく説明しました。この 350 ポンド (約 160 kg) のマシンは、2 PetaFLOPS の処理能力と 512GB の HBM2 メモリを備えています。

「これは、1 台のコンピューターとしては史上最速のコンピューターです。1 つのオペレーティング システム、1 つのプログラミング モデルを採用し、1 台のコンピューターとしてプログラムできます。圧倒的に高速であることを除けば、PC のようなものです。」

コンピューティングにおける新しい「法則」

フアンによれば、DGX-2 は前世代からわずか 6 か月で 10 倍の処理能力向上を達成しています。さらに、AlexNet 画像認識ベンチマークでは、5 年前に 1 対の NVIDIA GPU で得られた性能の 500 倍のパフォーマンスをたたき出します。

「スタック全体を最適化できる場合、また、スタック全体を最適化する意思がある場合、信じられないほどのパフォーマンス向上が可能になるのです。これはコンピューティングにおける新しい法則と言えるでしょう。」

その結果、シングル チップ パフォーマンスからデータ センター システムまでのさまざまな技術スタックで、ディープラーニングの学習速度の記録を次々と塗り替えています。

NVIDIA GPU Cloud は、この能力の利用範囲をさらに広げ、デスクトップやサーバー システムから、Amazon、Google、Alibaba、Oracle などのプロバイダーが提供するクラウドシステムへの移行を研究者に促しています。

フアンは、「このソフトウェアのレイヤーはすべてチューニングされ、テストされています」とした上で、「すでに 2 万社の企業が NGC Cloud をダウンロードしています」と付け加えました。

実際の結果は驚くべきものです。聴衆が見つめる中、ステージ上のフアンは NVIDIA の AI 研究者と連携して、写真から木や街路灯などをリアルタイムで削除しました。

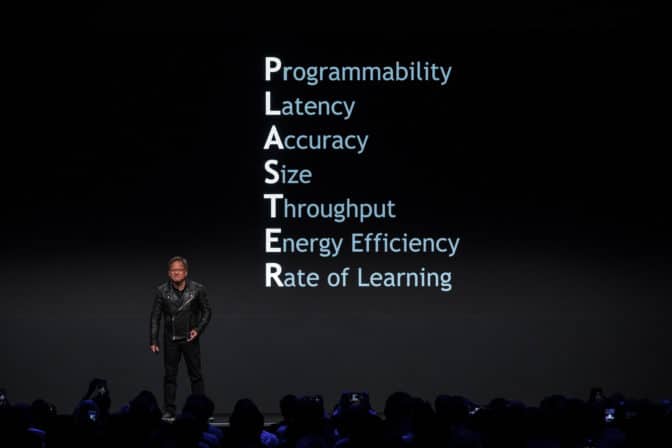

「PLASTER」を克服

デモを超えてこうしたディープラーニング アプリケーションを大規模展開するに当たっては、プログラマビリティ (Programmability)、レイテンシ (Latency)、精度 (Accuracy)、規模 (Size)、スループット (Throughput)、エネルギー効率 (Energy Efficiency)、 学習速度 (Rate of Learning) という 7 つの課題、略して PLASTER を克服する必要があるとフアンは語りました。

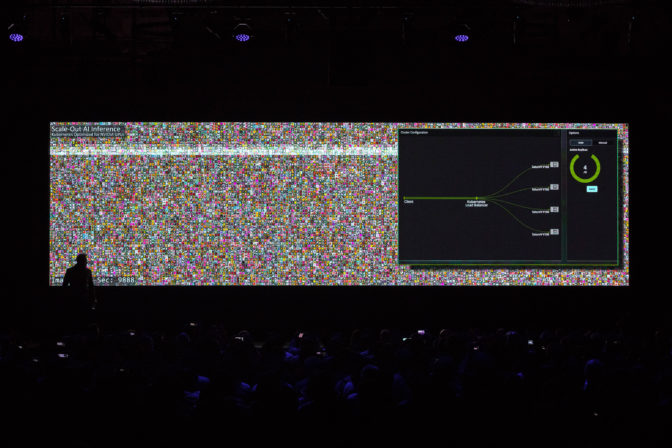

スケールアップ能力は、新世代の AI サービス、つまり推論と呼ばれる処理を音声合成から音声認識、画像処理、ビデオ処理、レコメンド サービスまでのあらゆるものに活用するカギとなります。

キング KONG

これが実際にどういうものなのかを示すために、フアンは花認識システムのデモを行いました。そのデモは、1 基の CPU で毎秒 4 枚の画像から、1 基の GPU で毎秒 2,500 枚の画像、さらにはその 4 倍の速度までスケールアップするという驚くべきものでした。これは、Kubernetes により、デスクトップ、データ センター、クラウド サービス プロバイダーにある GPU のサポートを素早く追加できるおかげです。

「これを Kubernetes on NVIDIA GPU、略して KONG と呼んでいます」とフアンは語りました。

フアンは次のように説明しました。「Kubernetes はハイパースケールで、言うなればオペレーティング システムです。GPU からこれらすべての API およびライブラリまで、Docker、コンテナーに格納し、Kubernetes 上で実行可能なこのスタック全体を見た場合、そのソフトウェア スタックは非常に複雑であるため、当社のエンジニア数百人が数年をかけて開発しました。」

大きな新 GPU、大きな新市場

こうしたサーバーが、他では得られない処理能力を数兆ドル規模の産業に提供します。

- 2 兆ドル規模の娯楽産業では、映画品質の標準であるレイ トレーシングを高速化する NVIDIA の新しい RTX テクノロジと、リアルタイム グラフィックス テクノロジや人工知能を組み合わせることにより、従来の CPU によるレンダー ファームの高速化が期待されます。

- 7 兆ドル規模の医療産業では、NVIDIA の Project Clara などの取り組みにより、現在の医療機器の忠実度をさらに高めたり、より少ない消費電力で同等品質の画像を生成できるようにしたりするなど、GPU コンピューティングを活用して画像診断を再定義することが期待されます。さらに、スキャナーからの被曝量を 1/6 程度に抑えることで、子供にも安全に使用できるようにすることが可能です。

- セーフ シティには 2 兆ドルの機会を新たにもたらします。

- NVIDIA がエンドツーエンドの DRIVE プラットフォームで取り組んでいる輸送産業は、10 兆ドルの機会を新たにもたらします。フアンは、「将来、動く物はすべて自動運転になるでしょう」とした上で、データ収集/処理、モデルのトレーニング、数十億マイル分の走行のシミュレーション、および運転を支援する NVIDIA の能力について詳しく説明しました。

縮めてフィット: 狭いスペースへのテレポート

基調講演の終わりで、フアンは VR を使って NVIDIA 従業員の 1 人を「縮小」し、ミニチュア自動車の車内にテレポートしました。そして、テレポートされた従業員はミニチュアの街を運転して回りました。

つまり、人間は VR を使って AI マシンを支援できるようになるとフアンは説明しました。マシンがどこにあろうと、どんなサイズであろうとです。

「将来、ロボットとの一体化が可能になるでしょう。人間のテレプレゼンスが実現し、どこでも好きなところに行けるようになります。」