NVIDIA GH200、H100、L4 GPU と Jetson Orin モジュールが、クラウドからネットワークのエッジまで、本稼働向けの AI で卓越したパフォーマンスを示す

MLPerf の業界ベンチマークでデビューを果たした NVIDIA GH200 Grace Hopper Superchip が、すべてのデータセンターの推論テストを実行し、NVIDIA H100 Tensor コア GPU のトップクラスの性能を証明しました。

すべての結果において、クラウドからネットワークのエッジに至るまで、NVIDIA の AI プラットフォームの卓越した性能と汎用性が示されています。

また、別の発表として、NVIDIA は、性能、エネルギー効率、総所有コストを飛躍的に向上させる推論ソフトウェアを公開しました。

MLPerf で GH200 Superchip が輝く

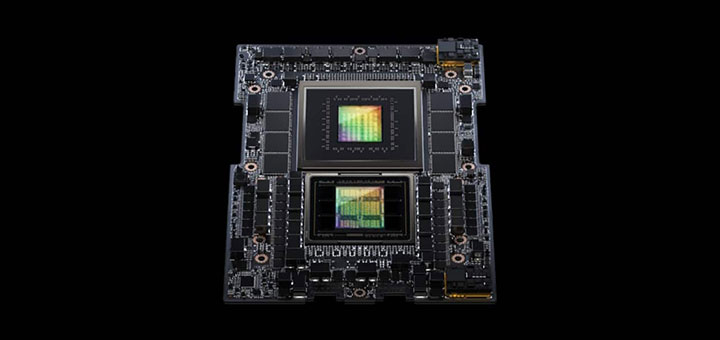

GH200 は、Hopper GPU とGrace CPU を 1 つのスーパーチップで接続しています。この組み合わせは、より多くのメモリと帯域幅を提供し、パフォーマンスを最適化するために CPU と GPU 間の電力を自動的にシフトする機能を備えています。

これとは別に、H100 GPU を 8 基搭載する NVIDIA HGX H100 システムは、今回の MLPerf 推論テストのすべてで最高のスループットを達成しました。

Grace Hopper Superchip と H100 GPU は、レコメンダー システムや生成 AI で使用される大規模言語モデル (LLM) など、より要求の厳しいユースケースに加え、コンピューター ビジョン、音声認識、医用画像における推論など、MLPerf のすべてのデータセンター テストでリードしています。

この結果は、2018 年の MLPerf ベンチマークの開始以来、すべてのラウンドで AI のトレーニングと推論の性能において、リーダーシップを実証してきた NVIDIA の記録を継続するものです。

最新の MLPerf のラウンドでは、レコメンダー システムのテストが更新されたほか、AI モデルの大まかな大きさの指標である 60 億個のパラメータを持つ LLM である GPT-J に関する初の推論ベンチマークが追加されています。

TensorRT-LLM が H100 GPU を強化

あらゆる規模の複雑なワークロードを処理するために、NVIDIA は推論を最適化する生成 AI ソフトウェアである TensorRT-LLM を開発しました。このオープンソース ライブラリは、8 月の MLPerf の提出には間に合いませんでしたが、顧客は追加コストなしで H100 GPU の推論性能を 2 倍以上に向上できるようになります。

NVIDIA の内部テストによると、H100 GPU で TensorRT-LLM を使用した場合、このソフトウェアなしで GPT-J 6B を前世代の GPU で実行した場合と比較すると、最大 8 倍の性能の高速化を実現しています。

このソフトウェアは、NVIDIA が Meta、AnyScale、Cohere、Deci、Grammarly、Mistral AI、MosaicML (現在は Databricks の一部)、OctoML、Tabnine、Together AI などの主要な企業とともに LLM の推論の高速化と最適化に取り組んだことから始まりました。

MosaicML は TensorRT-LLM に必要な機能を追加し、既存のサービング スタックに統合しました。Databricks のエンジニアリング担当バイス プレジデント、Naveen Rao 氏は次のように述べています。「TensorRT-LLM は機能満載であり、効率的で使いやすいです。また、NVIDIA GPU を使用した LLM サービングに最先端の性能を提供し、これにより削減されたコストを顧客に還元することができます」

TensorRT-LLM は、NVIDIA のフルスタック AI プラットフォームにおける継続的なイノベーションの最新の例です。このような継続的なソフトウェアの進歩により、ユーザーは、今日の多様な AI ワークロードにわたって汎用性があり、追加コストなしで時間とともに向上するパフォーマンスを得ることができます。

L4 がメインストリーム サーバーでの推論を強化

最新の MLPerf ベンチマークで、NVIDIA L4 GPU はあらゆるワークロードを実行し、全体的に素晴らしいパフォーマンスを発揮しました。

例えば、コンパクトな 72W の PCIe アクセラレータである L4 GPU は、5 倍近く定格消費電力の高い CPU と比べて最大 6 倍の性能を発揮しました。

さらに、L4 GPU には専用のメディア エンジンが搭載されており、CUDA ソフトウェアと組み合わせることで、NVIDIA のテストではコンピューター ビジョンが最大 120 倍高速化されました。

L4 GPU は Google Cloud や、多くのシステム ビルダーから入手可能です。消費者向けインターネット サービスから創薬まで、さまざまな業界の顧客に活用されています。

エッジでのパフォーマンス向上

これとは別に、NVIDIA は新しいモデル圧縮技術を適用することで、L4 GPU 上の BERT LLM の実行において最大 4.7 倍の性能向上を実証しました。この結果は、MLPerf のいわゆるオープン部門 (新機能を紹介するための部門) で発表されました。

この技術は、あらゆる AI ワークロードで利用されることが期待されます。特に、サイズや消費電力に制約のあるエッジ デバイス上でモデルを実行する場合に、その価値が発揮されることが期待されます。

エッジ コンピューティングにおけるリーダーシップのもう一つの例として、NVIDIA Jetson Orin システム オン モジュールは、エッジ AI やロボティクスのシナリオにおける一般的なコンピューター ビジョンのユースケースである物体検出において、前ラウンドと比較して最大 84% の性能向上を示しました。

Jetson Orin の進化は、プログラマブル ビジョン アクセラレータ、NVIDIA Ampere アーキテクチャ GPU、専用のディープラーニング アクセラレータなどの最新バージョンのチップのコアを活用したソフトウェアによるものです。

多彩なパフォーマンス、幅広いエコシステム

MLPerf ベンチマークは透明性が高く客観的であるため、ユーザーはその結果を信頼し、十分な情報に基づいた購入決定を行うことができます。また、幅広い使用ケースやシナリオを網羅しているため、ユーザーは信頼性と柔軟性を兼ね備えたパフォーマンスを得ることができます。

今回のラウンドに参加したパートナーには、クラウド サービス プロバイダーとしては Microsoft Azure とOracle Cloud Infrastructure、システム メーカーとしては ASUS、Connect Tech、Dell Technologies、富士通、GIGABYTE、Hewlett Packard Enterprise、Lenovo、QCT、Supermicro が含まれています。

MLPerf は全体として、Alibaba、Arm、Cisco、Google、ハーバード大学、Intel、Meta、Microsoft、トロント大学など 70 以上の組織から支援を受けています。

どのようにして NVIDIA が最新の結果を達成したのか、詳しくは技術ブログをご覧ください。

NVIDIA のベンチマークで使用されているソフトウェアはすべて MLPerf のリポジトリから入手できるため、誰もが同様の世界レベルの結果を得ることができます。NVIDIA はこれらの最適化を、GPU アプリケーション用の NVIDIA NGC ソフトウェア ハブで利用可能なコンテナに継続的に組み込んでいます。