事前トレーニング済みのモデルや NVIDIA TAO や Fleet Command のようなツールの使い方を知ることで、企業のAI活用に向けた道のりがスムーズに

AI は現代における最強の新技術ですが、多くの企業にとっては、活用するのが難しいテクノロジでした。今までは。

ほとんどの企業は、ディープラーニングを扱う際に求められる必要な専門的スキルを持っておらず、大規模なデータセットやアクセラレーテッド コンピューティングにもアクセスできません。その一方で、AI のメリットに気づき、より多くの製品やサービスに迅速に展開していきたいと考えている企業もあります。

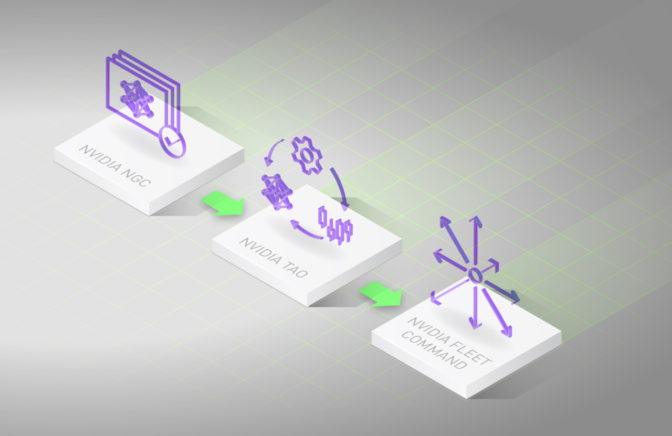

上記のような企業のために、エンタープライズ AI の導入に向けた新たなロードマップを用意しました。現在入手可能なテクノロジを活用し、NVIDIA TAO と NVIDIA Fleet Command で AI のワークフローを簡素化することで、AIの導入のプロセスを短縮してコストを抑制することができます。

そのまま使える AI モデル

このプロセスは、事前トレーニング済みのモデルから始まります。現在では、ニューラルネットワークをゼロから設計してトレーニングする必要はありません。NVIDIA の NGC カタログで現在提供されている数多くのモデルの中から選ぶことができます。

ビジネスを前進させるためのスキルを提供するモデルを厳選してご用意しています。これらは、コンピューター ビジョンや対話型 AI から自然言語理解などに至るまで、AI を使う幅広いジョブに対応しています。

AI に関する「履歴書」付きのモデル

カタログでは、それぞれのモデルが何をできるかを説明されているため、ユーザーはその詳細をあらかじめ知ることができます。これは求人応募者の「履歴書」のようなものです。

各モデルの詳細情報には、そのモデルがどの領域のためにトレーニングされたか、トレーニングにどのデータセットが使われたか、どれほどの頻度でモデルが導入されたか、どのようなパフォーマンスが期待されるか等が含まれます。これにより透明性が増し、ユーザーが想定している利用状況に合ったモデルを確実に選ぶことができます。

膨大な投資の活用

NVIDIA は、5 年以上にわたって数億時間もの GPU 演算時間を費やすことで、これらのモデルの改良を重ねてきました。そのため、お客様の方で同じ作業を行う必要はありません。

例えば、お客様は NVIDIA による以下のような 3 つの研究開発の成果を活用できます。

コンピューター ビジョンに関しては、4,500 万枚のフレームから得られた 5 億個のオブジェクトにラベリングするために 3,700 人年もの時間を費やしました。GPU 上での音声モデルのトレーニングには、100 万時間以上もの音声録音を利用しました。さらに自然言語処理のモデルのトレーニングには、61 億ワード(単語)分もの生物医学論文のデータベースを活用しました。

転移学習で AI をカスタマイズ

モデルを選択した後は、エンタープライズ AI に向けのワークフローを加速させる新たなツールである NVIDIA TAO を使って、お客様固有のニーズに合わせてファインチューニングを行うことができます。

TAO に統合されている NVIDIA の Transfer Learning Toolkit を使用することで、既存のニューラルネットワークから特徴を抽出し、新しいニューラルネットワークに移植するという工程である転移学習を行うことができます。ユーザーが現在持っている小さなデータセットを活用して、モデルをカスタマイズします。ニューラルネットワークをゼロから構築してトレーニングするためのコストや時間、そして膨大なデータセットは必要ありません。

場合によっては、自社データセンターの外でパートナーが維持管理している、さらに大規模で多様なデータセットを使ってトレーニングをすることで、モデルをさらに強化することもできます。

TAO はプライバシーを保護しながらパートナー間のコラボレーションを支援

TAO のもう 1 つの機能であるフェデレーテッド ラーニングでは、異なるサイトが安全に協力して、モデルの精度を最大限に高めることができます。ユーザーはこの技術を使って、部分的な重みなどのモデルの構成要素を共有します。データセットは各社のデータセンター内に残るため、データのプライバシーは守られます。

フェデレーテッド ラーニングの最近の例では、患者が新型コロナウイルス感染症に感染しているかどうかを予測するいわゆる EXAM モデルの精度を上げるために、20 の研究施設が協力しました。フェデレーテッド ラーニングを適用した結果、このモデルでは、感染症の重症度や、患者への酸素供給が必要かどうかも予測できるようになりました。患者のデータは、引き続きパートナー各社の安全な管理下にあります。

エンタープライズ AI の本番導入に向けて

ファインチューニング後のモデルは、いよいよ展開に向けて最適化する必要があります。

この「プルーニング (枝刈り)」のプロセスでは、モデルをスリムかつ堅牢にすることで、サーバー内の複数のGPU や工場現場の Jetson 搭載ロボットなどのターゲットとなるプラットフォーム上で効率的に機能するようにします。

TAO のもう 1 つの機能である NVIDIA TensorRT は、モデルの数学的座標を、実行されるシステム上で最小のサイズと最高の精度を備えた最適なバランスとなるように調整します。これは、特にシステムの遅延が認められない音声認識や不正行為の検出などのリアルタイムのサービスにおいては、非常に重要な手順です。

次に、Triton Inference Server は、モデルのアーキテクチャ、使用するフレームワーク、また実行ターゲットとなる CPU や GPU などに応じて、ユーザーは最適な構成を選択して展開することができます。

モデルの最適化と展開の準備が済んだら、ユーザーはモデルを想定用途や業界に適したアプリケーション フレームワークに簡単に統合できます。例えば、NVIDIA が提供している対話型 AI 向けの Jarvis、ヘルスケア向けの Clara、インテリジェント ビデオ解析向けの Metropolis、ロボティクス向けの Isaac などを利用することができます。

ユーザーが選択したアプリケーション フレームワークで NVIDIA Fleet Command を使えば、GPU が搭載されたさまざまなデバイスに AI アプリケーションを展開し、管理することができます。これがAI導入におけるプロセスで最後の重要なステップとなります。

わずか数分で AI に対応

Fleet Command は、ネットワークのエッジに展開されている NVIDIA-Certified サーバー(NVIDIA認証サーバー)をクラウドに接続します。これにより、ユーザーはブラウザから多数のサーバーを安全にペアリング、編成、および管理を行い、あらゆるリモート拠点に AI を展開し、必要に応じてソフトウェアをアップデートすることができます。

管理者は、健全性の監視やシステムのアップデートをワンクリックで行えるようになるため、大規模な AI 運用も簡素化できます。

Fleet Command は、アプリケーション データや知的財産の継続的な安全性を確保するために、エンドツーエンドのセキュリティ プロトコルを使用しています。

データは、エッジとクラウドの間で完全に暗号化された状態でやり取りされるため、確実に保護されます。またアプリケーションは展開前に、マルウェアや脆弱性がないかスキャンされます。

すでに現場に導入されている AI ワークフロー

Fleet Command と TAO の諸機能は、すでにさまざまな倉庫、小売店、病院、工場現場などで使用されています。ユーザーには、Accenture、BMW、Siemens Digital Industries などの企業が名を連ねています。

GTC の基調講演のデモ (下記) では、NGC モデル、TAO、および Fleet Command の 3 要素の組み合わせにより、複数のAIモデルを使いながらアプリケーションを迅速にカスタマイズし、導入する方法が解説されています。

Fleet Command は今すぐお申し込みいただけます。

Transfer Learning Toolkit やフェデレーテッド ラーニングなどのTAOの主な機能は現在ご利用いただけます。TAOに完全に統合されるすべての機能へのアーリー アクセスへは、こちらからお申込み下さい。

※NVIDIA Jarvis の名称は 2021 年 7 月に NVIDIA Riva に変更されました。

※Transfer Learning Toolkit の名称は 2021 年 8 月に TAO Toolkit に変更されました。