世界をリードする AI 研究ラボの 1 つである Black Forest Labs が、画像生成の分野に革新をもたらしました。

ラボの FLUX.1 画像モデルは、卓越した速さで高品質なビジュアルを提供することで、世界的な注目を集めています。 現在、ラボは新しい FLUX.1 Kontext モデルにより、画像生成プロセスをユーザーがガイドし、改善する方法を根本的に変更しています。

AI アーティストは、望ましい結果を得るために、モデルと画像生成モデルの出力をガイドするAIモデルである ControlNet を組み合わせて使用することがよくあります。これには通常、複数の ControlNet を組み合わせたり、3D シーンのドラフトを使用して画像の構成を決定する 3D ガイド生成 AI 用の NVIDIA AI Blueprint などの高度な技術を使用したりする必要があります。

新しい FLUX.1 Kontext モデルは、自然言語を用いて画像生成と編集の両方を実行できる単一のモデルを提供することで、これを簡素化しています。

NVIDIA は Black Forest Labs と協力し、NVIDIA TensorRT ソフトウェア開発キットと量子化を用いて NVIDIA RTX GPU 向けに FLUX.1 Kontext [dev] を最適化し、VRAM 要件を低減しながら高速な推論を実現しました。

クリエイターと開発者にとって、TensorRT の最適化は、RTX 搭載マシンからの編集の高速化、よりスムーズな反復処理、より優れた制御を意味します。

FLUX.1 Kontext [dev] Flex: コンテキスト内画像生成

5 月に Black Forest Labs は、テキストと画像の両方のプロンプトを受け入れる画像モデルである FLUX.1 Kontext ファミリーを発表しました。

これらのモデルでは、ユーザーは参照画像を基に開始し、簡単な言語で編集をガイドできます。微調整や複数の ControlNet を使用した複雑なワークフローは必要ありません。

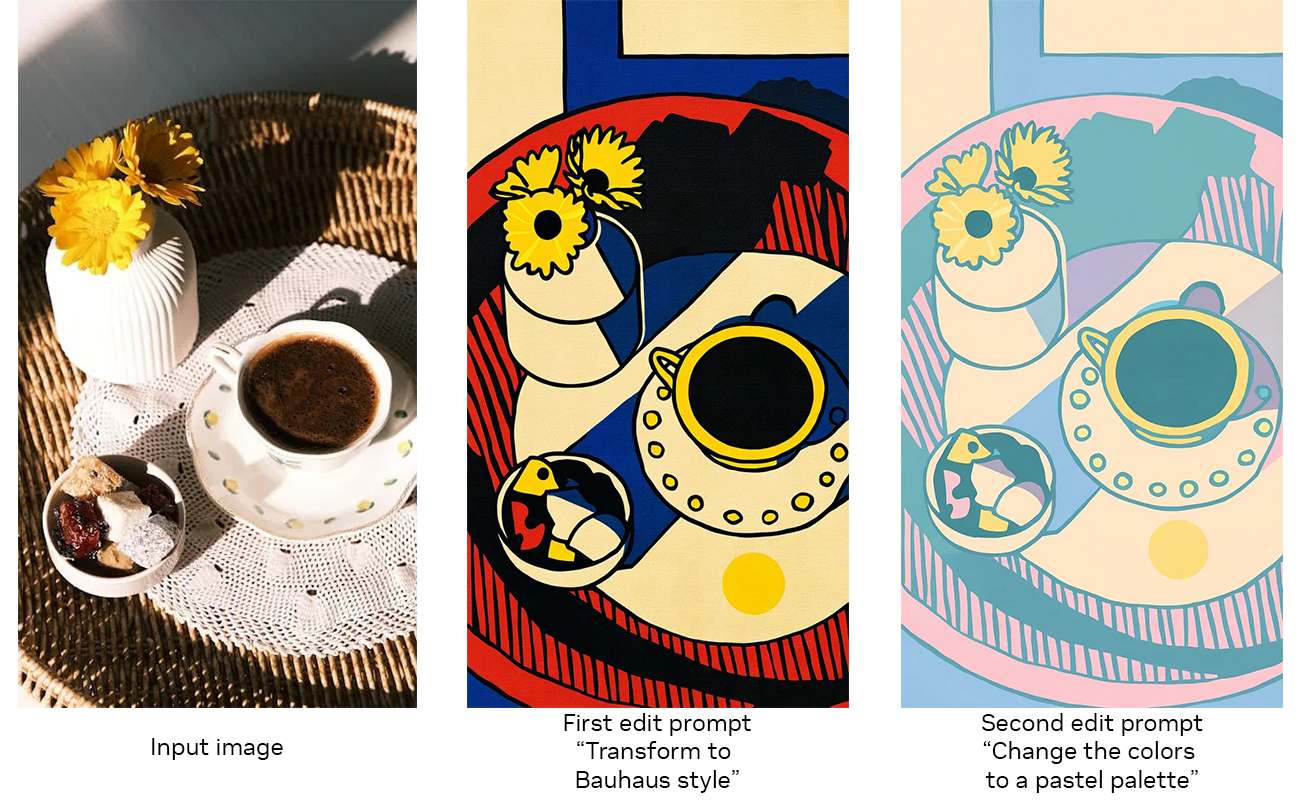

FLUX.1 Kontext は、ガイド付きのステップバイステップの生成プロセスを使用して画像編集のために構築されたオープンウェイト生成モデルであり、小さなディテールの微調整やシーン全体の変換など、画像の進化をより簡単に制御できます。モデルはテキストと画像の両方の入力を受け入れるため、ユーザーは視覚的な概念を簡単に参照し、自然で直感的な方法で進化させる方法を導くことができます。これにより、元のコンセプトに忠実な一貫性のある高品質の画像編集が可能になります。

FLUX.1 Kontext の主な機能には、以下のようなものがあります。

- キャラクターの一貫性: 複数のシーンやアングルで、固有の特性を保持します。

- ローカライズ編集: 画像の他の部分を変更せずに特定の要素を変更できます。

- スタイル転送: 参照画像のルック&フィールを新しいシーンに適用します。

- リアルタイム パフォーマンス: 低遅延の生成により、高速な反復処理とフィードバックが可能になります。

Black Forest Labs は、『Hugging Face』でFLUX.1 Kontext ウェイトをダウンロードできるようにリリースしました。また、対応する TensorRT 高速化版もリリースしました。

[dev] モデルは、柔軟性と制御性を重視しています。構造化された視覚的なプロンプトを提供する統合された ControlNet 機能により、キャラクターの一貫性、スタイルの保持、局所的な画像調整などの機能に対応しています。

FLUX.1 Kontext [dev] はすでに『ComfyUI』と『Black Forest Labs Playground』で利用可能で、NVIDIA NIM マイクロサービス バージョンは 8 月にリリースされています。

TensorRT アクセラレーションによる RTX 向けの最適化

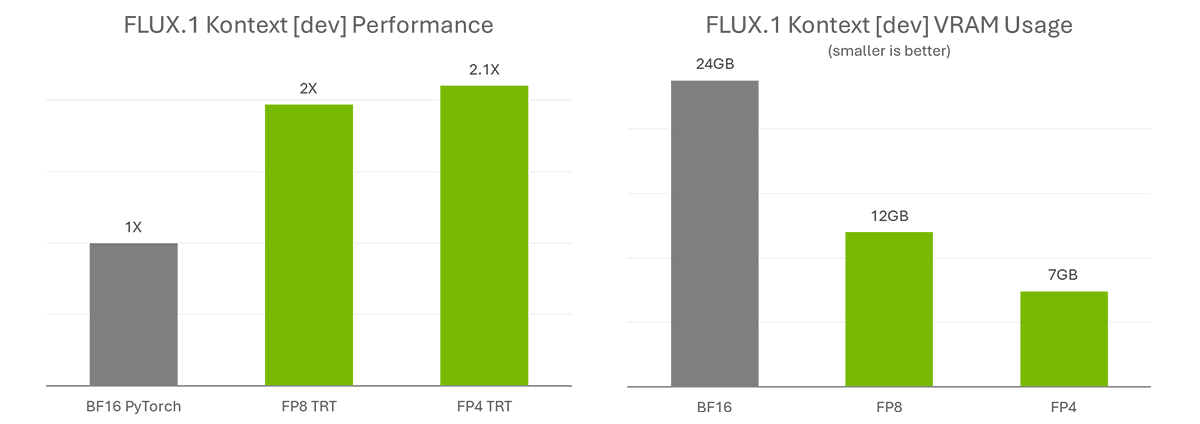

FLUX.1 Kontext [dev] は、複雑なワークフローを簡素化することで創造性を高速化します。作業をさらに効率化し、アクセシビリティを拡大するために、NVIDIA と Black Forest Labs は協力してモデルの量子化を行いました。VRAM 要件を低減することで、より多くのユーザーがローカルで実行できます。また、TensorRT で最適化することで、パフォーマンスが 2 倍になりました。

量子化ステップにより、モデルサイズを FP8 (Ada) では 24 GB から 12 GB に、FP4 (Blackwell) では 7 GB に削減できます。FP8 チェックポイントは、Tensor コアに FP8 アクセラレーターを搭載した GeForce RTX 40 シリーズ GPU 向けに最適化されています。FP4 チェックポイントは、同じ理由で GeForce RTX 50 シリーズ GPU 向けに最適化されており、モデル サイズを縮小しながら、高画質を維持する SVDQuant と呼ばれる新しい手法を使用しています。

TensorRT は NVIDIA RTX GPU の Tensor コア にアクセスして最大限のパフォーマンスを実現するフレームワークで、元の BF16 モデルを PyTorch で実行した場合と比較して 2 倍以上の高速化を実現します。

FLUX.1 Kontext を使い始める

FLUX.1 Kontext [dev] は、Hugging Face (Torch と TensorRT) で利用可能です。

これらのモデルのテストに興味のある AI 愛好家の方は、Torch のバリエーションをダウンロードして、ComfyUI で利用できます。Black Forest Labs は、モデルをテストするためのオンライン プレイグランドも提供しています。

上級ユーザーや開発者向けに、NVIDIA は TensorRT パイプラインをワークフローに簡単に統合できるサンプル コードを作成しています。 今月後半に公開予定の DemoDiffusion リポジトリをご確認ください。

さらなる情報

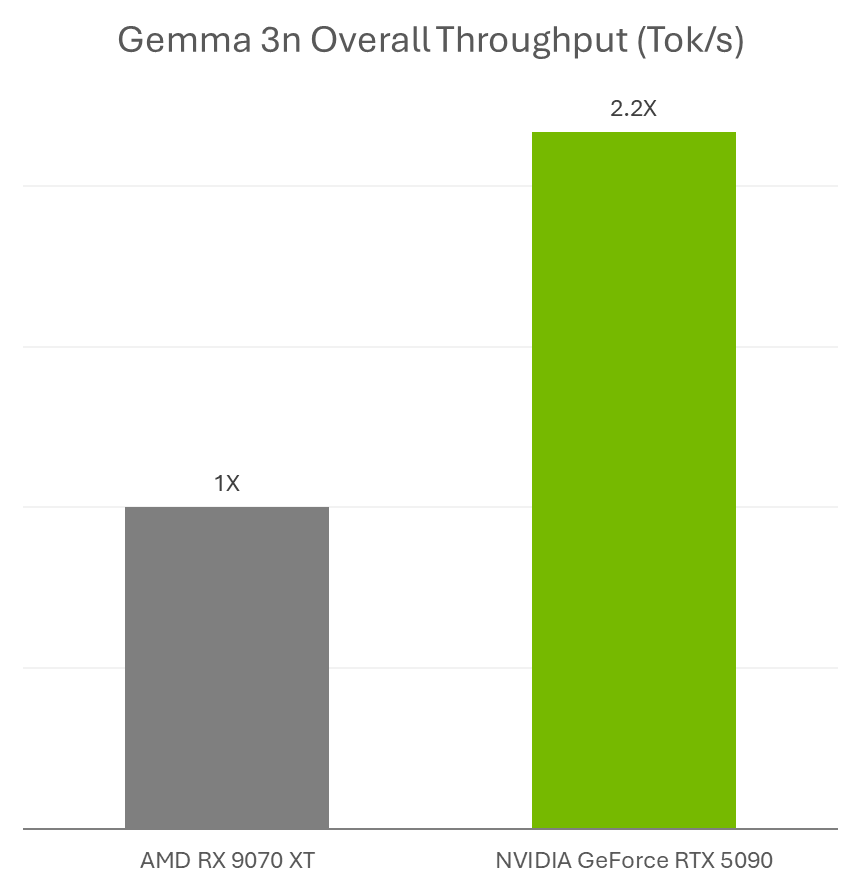

Google は、NVIDIA GeForce RTX GPU と エッジ AI およびロボティクス向けの NVIDIA Jetson プラットフォームでの実行に最適な新しいマルチモーダル小規模言語モデル Gemma 3n のリリースを発表しました。

AI 愛好家は、AnythingLLM や LM Studio などのお気に入りのアプリで、Ollama や Llama.cpp で RTX アクセラレーションを活用した Gemma 3n モデルを使用できます。

さらに、開発者は、Ollama を使用して Gemma 3n モデルを簡単に展開でき、RTX 高速化の利点も得られます。Jetson と RTX で Gemma 3n を実行する方法の詳細については、こちらをご覧ください。

NVIDIA の Discord サーバーに参加し、コミュニティの開発者や AI 愛好者とつながり、RTX AI の可能性について話し合いましょう。

毎週、RTX AI Garage ブログ シリーズでは、NVIDIA NIM マイクロサービスと AI ブループリントについて詳しく知りたい方や、AI PC やワークステーションにおける AI エージェント、クリエイティブなワークフロー、デジタル ヒューマン、生産性アプリなどを構築したい方向けに、コミュニティ主導の AI イノベーションとコンテンツを特集しています。

Facebook、Instagram、TikTok、X で NVIDIA AI PC に接続し、RTX AI PC ニュースレターを購読することで最新情報を入手できます。

LinkedIn と X で NVIDIA Workstation をフォローしてください。

ソフトウェア製品情報に関するお知らせをご覧ください。