NVIDIA Blackwell GPU を使用した最初の提出で、Llama 2 70B において最大 4 倍のパフォーマンスを達成、NVIDIA Hopper アーキテクチャにより業界の AI ベンチマーク全体の大幅な向上を実現

企業が生成 AI を採用し、新しいサービスの市場投入を急ぐ中、データセンター インフラへの需要はかつてないほど高まっています。大規模言語モデル (LLM) のトレーニングは課題の 1 つですが、LLM を活用したリアルタイム サービスの提供もまた別の課題です。

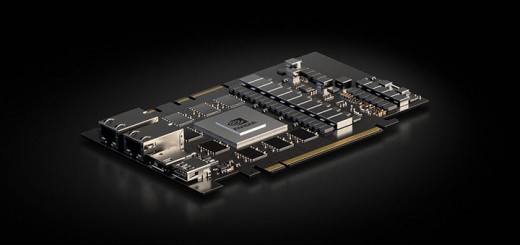

MLPerf 業界ベンチマークの最新ラウンド「Inference v4.1」では、NVIDIA プラットフォームがすべてのデータセンター テストで最高のパフォーマンスを達成しました。近く発売予定の NVIDIA Blackwell プラットフォームの初めての提出では、第 2 世代の Transformer Engine と FP4 Tensor コアの使用により、MLPerf の最大の LLM ワークロードである Llama 2 70B において、NVIDIA H100 Tensor コア GPU の最大 4 倍のパフォーマンスを示しました。

NVIDIA H200 Tensor コア GPU は、データセンター カテゴリーのすべてのベンチマークにおいて優れた結果を達成しました。このカテゴリーには、最新ベンチマークに追加された、合計 467 億パラメータを持ち、トークン当たり 129 億パラメータがアクティブになる Mixtral 8x7B Mixture of Experts (MoE) LLM も含まれます。

MoE モデルは、単一の展開で幅広い質問に答え、多様なタスクを実行できるため、LLM の展開にさらなる汎用性をもたらす方法として注目を集めています。また、推論ごとにいくつかのエキスパートのみをアクティブにするため、効率でも優れています。つまり、同規模の密なモデルよりもはるかに高速に結果を出力します。

LLM の持続的な成長に伴い、推論リクエストを処理するためのコンピューティング能力を強化する必要性が高まっています。今日の LLM のリアルタイムのレイテンシ要件を満たし、できる限り多くのユーザーにサービスを提供するためは、マルチ GPU コンピューティングが不可欠です。NVIDIA NVLink と NVSwitch は、NVIDIA Hopper アーキテクチャに基づく GPU 間の高帯域幅通信を実現し、コスト効率に優れたリアルタイムの大規模モデル推論に大きなメリットをもたらします。Blackwell プラットフォームは、72 基の GPU を備えたより大規模な NVLink ドメインにより、NVLink Switch の機能をさらに拡張します。

NVIDIA の提出に加えて、ASUSTek、Cisco、Dell Technologies、富士通、Giga Computing、Hewlett Packard Enterprise (HPE)、Juniper Networks、Lenovo、Quanta Cloud Technology、Supermicro の NVIDIA パートナー 10 社のいずれも手堅い MLPerf Inference の結果を提出し、NVIDIA プラットフォームの幅広い利用可能性を裏付けました。

ソフトウェアの絶え間ない革新

NVIDIA プラットフォームは継続的なソフトウェア開発が行われており、月を追うごとにパフォーマンスと機能が向上しています。

最新の推論ラウンドでは、NVIDIA Hopper アーキテクチャ、NVIDIA Jetson プラットフォーム、NVIDIA Triton Inference Server などの NVIDIA 製品が、パフォーマンスの飛躍的な向上を示しました。

NVIDIA H200 GPU は、前回のラウンドから最大 27% 向上した AI 推論パフォーマンスを示し、顧客が NVIDIA プラットフォームへの投資から長期的に得られる付加価値を強調しています。

NVIDIA AI プラットフォームの一部であり、NVIDIA AI Enterprise ソフトウェアで利用できる Triton Inference Server は、完全な機能を備えたオープンソース推論サーバーで、フレームワーク固有の推論サーバーを単一の統合プラットフォームに集約するのに役立ちます。これは、本番環境で AI モデルを提供するのに必要な TCO (総所有コスト) の削減に貢献するほか、モデルの展開にかかる時間を数か月から数分に短縮します。

今回の MLPerf ラウンドでは、Triton Inference Server は NVIDIA のベアメタルの提出とほぼ同等のパフォーマンスを達成しました。これは、もはや豊富な機能を備えた本番グレードの AI 推論サーバーを使用するか、ピーク スループット パフォーマンスを達成するかの選択が不要になったことを示しています。

エッジへの展開

生成 AI モデルをエッジに展開すると、強力なコンテキスト認識によって画像や動画などのセンサー データを実用的なリアルタイムの洞察に変換できます。エッジ AI およびロボティクス向けの NVIDIA Jetson プラットフォームは、LLM、Vision Transformer (ViT)、Stable Diffusion を含む、あらゆる種類のモデルをローカルで実行できる独自の能力を備えています。

今回の MLPerf ベンチマークのラウンドでは、NVIDIA Jetson AGX Orin システムオンモジュールは、GPT-J LLM ワークロードにおいて、前回のラウンドに対して 6.2 倍以上のスループット向上と 2.4 倍以上のレイテンシ改善を達成しました。開発者は、特定のユース ケース向けに開発するのではなく、この汎用的な 60 億パラメータ モデルを使用して人間の言語とシームレスに対話できるようになり、エッジでの生成 AI に変革をもたらすことが可能になります。

あらゆる面でパフォーマンスをリード

今回の MLPerf Inference ラウンドでは、あらゆるベンチマーク ワークロードにおいて、NVIDIA プラットフォームがデータセンターからエッジに至るまで優れた汎用性とパフォーマンスを発揮し、AI を利用した最も革新的なアプリケーションやサービスを強化することが証明されました。これらの結果の詳細については、NVIDIA の技術ブログをご覧ください。

H200 GPU 搭載システムは、一般提供開始を発表した最初のクラウド サービス プロバイダーである CoreWeave と、サーバー メーカーの ASUS、Dell Technologies、HPE、QCT、Supermicro から入手可能です。

ソフトウェア製品に関する免責条項をご覧ください。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE