イスラエルのスタートアップ企業が、アクセラレーテッド コンピューティングの共有インフラ全体で AI ワークロード向けのクラスター リソースの効率的な活用を促進

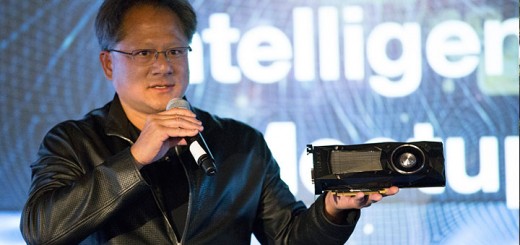

AI コンピューティング リソースをさらに顧客が効率的に利用できるよう、NVIDIA は、Kubernetes ベースのワークロード管理およびオーケストレーション ソフトウェア プロバイダーである Run:ai の買収に関する最終合意に達したと発表しました。

顧客の AI 導入はますます複雑になり、ワークロードはクラウドやエッジ、オンプレミスのデータセンター インフラに分散されています。

生成 AI、レコメンダー システム、検索エンジンなどのワークロードの管理とオーケストレーションには、システム レベルのパフォーマンスや基盤となるインフラのパフォーマンスを最適化する高度なスケジューリングが必要です。

Run:ai により、エンタープライズの顧客はオンプレミス、クラウド、ハイブリッド環境を問わず、コンピューティング インフラの管理、最適化が可能となります。

Run:ai は 最新のAIとクラウド インフラのオーケストレーション レイヤーである Kubernetes 上にオープン プラットフォームを構築しています。一般的な Kubernetes バリアントすべてに対応し、サードパーティの AI ツールおよびフレームワークと統合しています。

Run:ai の顧客には、複数の業界にわたる世界最大手の企業も含まれており、Run:ai プラットフォームを使用してデータセンター規模の GPU クラスターを管理しています。

Run:ai 共同創業者兼 CEO の Omri Geller (オムリ ゲラー) 氏は、次のように述べています。「Run:ai は 2020 年から NVIDIA と緊密に協力しており、顧客がインフラを最大限に活用できるように支援するという情熱を共有しています。私たちは NVIDIA の一員になることを非常に喜んでおり、今後共に歩み続けることを楽しみにしています」

Run:ai プラットフォームは、AI 開発者とそのチームに以下のサービスを提供します。

- 複雑な AI ワークロードへのアクセスがさらに容易で迅速になる、共有コンピューティング インフラ管理用の一元化されたインターフェイス。

- ユーザーの追加、チーム単位でのキュレーション、クラスター リソースへのアクセス提供、クォータ、優先順位、プールの制御、リソースの使用を監視して報告をする機能。

- GPU をプールし、一部の GPU から、複数の GPU または異なるクラスター上で実行される複数のノードにある GPU に至るまで、個別のタスク向けにコンピューティング性能を共有する機能。

- お客様がコンピューティングへの投資からより多くの利益を得ることができる、効率的な GPU クラスター リソースの使用率。

NVIDIA は当面、同じビジネス モデルで Run:ai の製品提供を続ける予定です。また、NVIDIA は、エンタープライズ開発者向けに主要クラウドと共同で設計された AI プラットフォームである NVIDIA DGX Cloud 上での有効化を含め、Run:ai 製品ロードマップへの投資を継続し、生成 AI に最適化された統合フルスタック サービスを提供していきます。

NVIDIA HGX、DGX、および DGX Cloud のお客様は、AI ワークロードを利用する際、特に大規模言語モデルを展開する際に、Run:ai の機能を利用できるようになります。Run:ai のソリューションは、NVIDIA DGX、NVIDIA DGX SuperPOD、NVIDIA Base Command、NGC コンテナ、NVIDIA AI Enterprise ソフトウェアなどの製品とすでに統合されています。

NVIDIA のアクセラレーテッド コンピューティング プラットフォームと Run:ai のプラットフォームは、サードパーティ ソリューションの広範なエコシステムをサポートし続け、顧客に選択肢と柔軟性を提供します。

NVIDIA が Run:ai と一丸となることで、お客様はどこからでも GPU ソリューションにアクセスできる単一のファブリックを利用できるようになり、GPU 利用率の向上、GPU インフラの管理の改善、オープン アーキテクチャによる柔軟性の向上といった恩恵を受けることが期待されます。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE