NVIDIA は、NVIDIA TensorRT-LLM によって Microsoft の新しい Phi-3 Mini オープン言語モデルが高速化されることを発表しました。TensorRT-LLM は、PC からクラウドまで、NVIDIA GPU で実行される大規模言語モデルの推論を最適化するオープンソース ライブラリです。

Phi-3 Mini は、規模が 10 倍大きいモデルの機能をコンパクト化し、研究専用であった Phi-2 を進化させて、研究と広範な商用利用の両方のためにライセンスされます。NVIDIA RTX GPU を搭載したワークステーションや GeForce RTX GPU を搭載した PC は、Windows DirectML または TensorRT-LLM を使用してこのモデルをローカルで実行する性能を備えています。

パラメーター数が 38 億のこのモデルは、512 基の NVIDIA H100 Tensor コア GPU を使用して 3 兆 3,000 億トークンをわずか 7 日間でトレーニングされました。

Phi-3 Mini には、それぞれ 4k トークンと 128k トークンをサポートしている 2 つのタイプがあります。後者は、非常に長いコンテキストに対応したこのクラスで最初のモデルです。このため、開発者はモデルに質問するときに、12 万 8,000 トークン (モデルが処理する言語の最小単位) を使用できます。この結果、モデルからより適切な回答が得られます。

開発者は、ai.nvidia.com で 128K のコンテキスト長に対応している Phi-3 Mini を試用することができます。ここでは、Phi-3 Mini は、どこでも展開可能な標準アプリケーション プログラミング インターフェイス (API) を備えたマイクロサービスである NVIDIA NIMとしてパッケージ化されています。

エッジでの効率的な実行

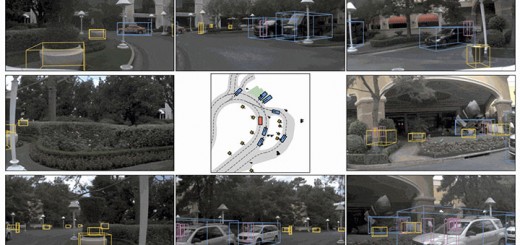

自律型ロボティクスや組み込みデバイスの開発者は、Jetson AI Lab などのコミュニティ主導のチュートリアルを通じて生成 AI の作成と展開を学び、NVIDIA Jetson で Phi-3 を展開することができます。

パラメーター数がわずか 38 億の Phi-3 Mini モデルは、非常にコンパクトであるためエッジ デバイスで効率的に実行できます。パラメーターはメモリ内にある調整可能なノブのようなものであり、モデルが入力プロンプトに高い精度で応答できるように、モデルのトレーニング プロセス中に正確にチューニングされています。

Phi-3 は、特に比較的シンプルなタスクで、コストとリソースが限られているユースケースを支援できます。このモデルは、レイテンシ要件内で応答し、もっと大規模なモデルの性能を主要な言語ベンチマークで上回ることがあります。

TensorRT-LLM は、Phi-3 Mini の長いコンテキスト長をサポートし、LongRoPE、FP8、インフライト バッチングなどの多くの最適化とカーネルを利用します。これにより、推論のスループットとレイテンシが改善します。TensorRT-LLM の実装は、GitHub の examples フォルダーでまもなく提供されます。開発者は、推論に最適化された TensorRT-LLM チェックポイント形式に変換し、NVIDIA Triton Inference Server で簡単に展開できます。

オープン システムの開発

NVIDIA はオープンソース エコシステムに積極的に貢献しており、オープンソース ライセンスの下で 500 を超えるプロジェクトをリリースしました。

また、JAX、Kubernetes、OpenUSD、PyTorch、Linux カーネルなどの多くの外部プロジェクトに貢献することで、NVIDIA はさまざまなオープンソース財団や標準機関をサポートしています。

今回のニュースは、DirectML の高速化、Azure クラウド、生成 AI の研究、ヘルスケア、ライフサイエンスなどのイノベーションに向けて道を拓いてきた NVIDIA と Microsoft 間の長期にわたる協業関係をさらに発展させるものです。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE