GAN 研究をもとに開発された NVIDIA Maxine クラウド AI ビデオ ストリーミング SDK が、CVPR 2021 で公開中

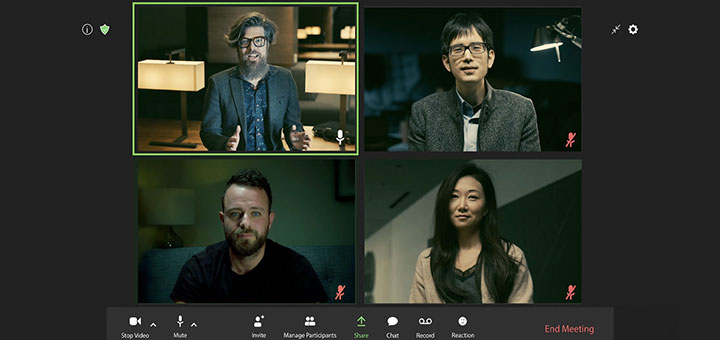

ベッドから起きて、ノートPCを起動し、ウェブカメラをオンに — すると、ビデオカメラに写っているのは、身支度の整った姿。そんなことを可能にするのが、NVIDIA の研究者が開発した AI です。

ビデオ会議用の NVIDIA Maxine SDK を支えるディープラーニング モデルの 1 つである Vid2Vid Cameo は、敵対的生成ネットワーク (GAN) を使用して、人の 2D 画像 1 枚から、人が話している顔のリアルな会話ビデオを合成します。

これを使用するために、参加者はビデオ通話に参加する前に、自分の実際の顔写真または漫画のアバターのいずれかを参照画像として送信します。ミーティング中、AI モデルが各参加者のリアルタイムの動きをキャプチャーし、あらかじめアップロードされた参照画像に適用します。

つまり、あらかじめ正装姿の自分の写真をアップロードしておけば、ミーティングの参加者は髪の毛がぼさぼさであったりパジャマ姿であっても、ユーザーの顔の動きが参照写真にマッピングされるので、オフィス スタイルで会話画面に映ることができます。もし被写体が左に向いたとしても、テクノロジによって視線が補正され、参加者がウェブ カメラに直接向いているように見せることができます。

この AI 技術は、ミーティング参加者をベストな状態で映すだけでなく、ビデオ会議に必要な帯域幅を最大 10 分の 1 に縮小し、画面の揺らぎ (ジッター) やラグの発生を防ぎます。NVIDIA Video Codec SDK の AI Face Codec という機能としてまもなく利用できるようになります。

NVIDIA の研究者であり、同プロジェクトに関する論文の共同執筆者でもあるミンユウ リュウ (Ming-Yu Liu) は次のように述べています。「インターネット帯域幅に制限があっても、友人や家族とスムーズなビデオ通話をしたいと思っている人は多いはずです。このプロジェクトの基盤となるテクノロジはこうした人々に役立つだけでなく、アニメーター、写真編集者、ゲーム開発者の仕事を支援するためにも使用できます。」

Vid2Vid Cameo は今週、世界的な学会である CVPR (Conference on Computer Vision and Pattern Recognition) で発表されました。この論文をはじめ、CVPR では 28 の NVIDIA の論文が採択されています。AI Playground で利用することもでき、誰でもNVIDIAの研究デモを直接体験できます。

NVIDIA Maxine SDKにVid2Vid Cameoの機能がまもなく登場

強盗映画の傑作 (および Netflix でヒットした映画) を参考に、NVIDIA の研究者はビデオ会議のための会話画面 GAN モデルを試してみました。デモでは、顔の向きの修正、アバターのアニメーション、データ圧縮など、Vid2Vid Cameo の主要な機能に焦点を当てています。

これらの機能は NVIDIA Maxine SDK でまもなく提供され、開発者はビデオ会議やライブ ストリーミングにおけるビデオ、音声、および拡張現実エフェクト向けに最適化された事前トレーニング済みモデルを利用できるようになります。

開発者はすでに、インテリジェントなノイズ除去、ビデオのアップスケーリング、姿勢推定など、 Maxine AI のエフェクト機能を利用できます。この SDK は無料でダウンロードでき、文字起こしや翻訳などの対話型 AI アプリケーション向けプラットフォーム、NVIDIA Jarvis と組み合わせて利用することもできます。

Vid2Vid Cameoを実現するテクノロジ

Vid2Vid Cameo がビデオ会議用のリアルな AI 会話画面を構築するために必要とするのは、人物の容姿がわかるように一人で映った画像 1 枚と、その画像をアニメーション化する方法を指示するビデオ ストリームという 2 つの要素だけです。

NVIDIA DGX システムで開発されたこのモデルは、180,000 の高品質な会話画面ビデオのデータセットを使用してトレーニングされました。ネットワークは、人間の注釈なしで顔の動きをモデル化するために、主要ポイント 20 カ所を特定すればよいことを学びました。そのキー ポイントは、目、口、鼻など、顔を特徴づける位置をエンコードします。

次に、画面に映る人の参照画像からキー ポイントを抽出します。抽出されたポイントは、他のビデオ会議参加者にあらかじめ送信でき、以前に開催したミーティングから再利用することもできます。こうすることで、ビデオ会議プラットフォームは大量のライブ ビデオ ストリームを他の参加者に送信するのではなく、話す人の顔のキー ポイントがどのように動いているかに関するデータの送信だけで済みます。

受信者側では、GAN モデルがこの情報を使用して、参照画像の外観を模倣したビデオを合成します。

この手法では、完全なビデオ ストリームではなく、頭の位置とキー ポイントだけを圧縮して相互に送信するため、ビデオ会議に必要な帯域幅を 10 分の 1 に減らし、よりスムーズなユーザー エクスペリエンスをもたらします。モデルを調整して、さまざまなキー ポイントを送信することで、視覚的な品質を損なうことなく、さまざまな帯域幅環境に適応させることができます。

その結果、会話画面に映る顔の視点を横向きや真っ直ぐに調整でき、カメラ アングルの高低を自由に調整してユーザーを表示することもできます。また、静止画像を操作する写真編集者がこの機能を応用することもできます。

NVIDIA の研究者は、参照画像と同一人物がビデオに映る場合にも、または AI がある人物の動きを別の人物の参照画像に転送するタスクを行う場合にも、Vid2Vid Cameo がよりリアルで鮮明な結果を生成し、これまで最高の精度を持つAIモデルを凌駕することを発見しました。

後者の機能を使用することで、ビデオ会議で話者の顔の動きをデジタル アバター適用して動かしたり、ビデオ ゲームや漫画のキャラクターにリアルな表情や動きを付けたりすることができます。

Vid2Vid Cameo の論文は、NVIDIA の研究者であるティンチュン ワン (Ting- Chun Wang)、アルン マリヤ (Arun Mallya)、ミンユウ リュウによって執筆されています。NVIDIA Research チームには世界中の 200 人以上の科学者が在籍し、AI、コンピューター ビジョン、自動運転車、ロボティクス、グラフィックスなどの分野に焦点を当てて研究を進めています。

なお、Netflix のシリーズ、『La Casa De Papel/Money Heist』の英語版にてThe Professor役の吹き替えを担当した俳優のエダン モーゼズ (Edan Moses) 氏が、NVIDIAの最新 のAI 研究を紹介するビデオにご協力いただいたことに感謝の意を表します。