VMware vSphereで動作し、NVIDIAが最適化、認証、サポートする NVIDIA AI Enterpriseスイートが、AI アプリケーションやデータ サイエンス アプリケーションに役立つスケールアウト パフォーマンスや互換性をハイブリッド クラウドにもたらす

企業がデータセンターを刷新して AI 主導のアプリケーションやデータ サイエンスの強化を進めている今、NVIDIA と VMware は、最新のハイブリッド クラウド内におけるさまざまな AI ワークロードの開発、導入をこれまで以上に簡単にします。

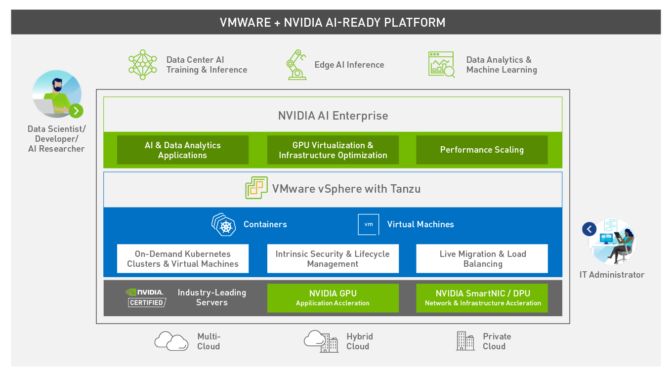

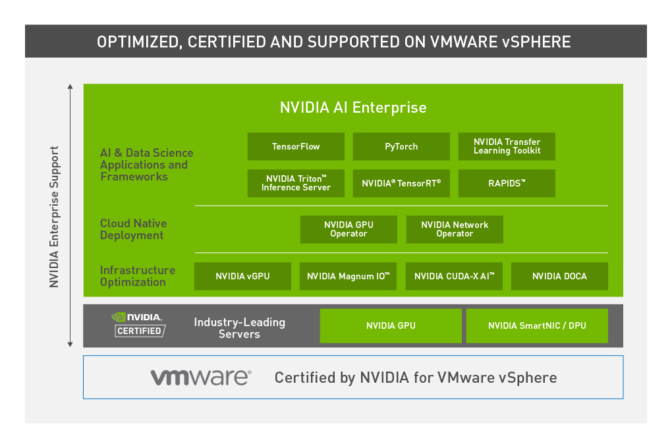

NVIDIAとVMwareはチームを組み、発表されたばかりのvSphere のアップデート版 (VMware vSphere 7 Update 2) が、NVIDIA AI Enterprise ソフトウェア スイート(以下図1を参照)を使用した AI アプリケーション向けに最適化されたことを発表しました。

この組み合わせにより、膨大な数の高速化されたCUDA アプリケーション、AI フレームワーク、AI モデル、SDK に対するスケールアウト、マルチノード パフォーマンス、互換性が実現し、サーバー仮想化に vSphere を使用する数十万社の企業が活用できます。

業界で類を見ないコラボレーションを通じて、AI 研究者やデータ サイエンティスト、開発者は AI プロジェクトの成功に欠かせないソフトウェアを獲得することになり、企業のIT 部門は大規模なデータセンターを管理するための慣れ親しんだツールをそのまま使って、AI に対処できるようになります。

図 1: VMware vSphere 向けのNVIDIA AI Enterpriseは NVIDIA-Certified Systems(NVIDIA認証システム)上で実行され、IT管理者は仮想化された AI を大規模かつ簡単に導入できるようになります。

図 1: VMware vSphere 向けのNVIDIA AI Enterpriseは NVIDIA-Certified Systems(NVIDIA認証システム)上で実行され、IT管理者は仮想化された AI を大規模かつ簡単に導入できるようになります。単一のスイートでエンタープライズ AI に対応

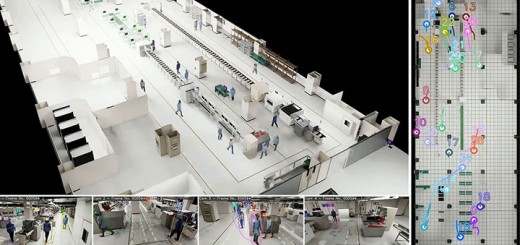

NVIDIA AI Enterprise は、ビジネス プロセスを最適化し、製造、物流、金融サービス、小売、ヘルスケアといった幅広い基幹産業の効率を高める、エンタープライズグレードの AI ツールとフレームワークから成る包括的なスイートです。NVIDIA AI Enterprise を使用することで、科学者や AI 研究者は、NVIDIA の主要な AI ツールに簡単にアクセスし、ヘルスケアにおける先進的な診断、製造業でのスマート ファクトリー、金融サービスでの不正検知など、さまざまなプロジェクトにおける AI 開発を強化できます。

このソリューションは、個々の AI アプリケーションをそれぞれ導入する煩わしさを解消し、互換性がないことが多い、さまざまなアプリケーションやインフラストラクチャ ソフトウェアの手動でのプロビジョニングや管理の必要性により発生する障害を克服します。

vSphere 上で NVIDIA AI Enterprise を実行することで、お客様は管理と安全性確保が難しい AI 固有のシステムのサイロ化を回避できます。また、データ サイエンティストや機械学習エンジニアが IT エコシステムの外部でリソースを調達するシャドウ AI の導入に付随するリスクを軽減することもできます。

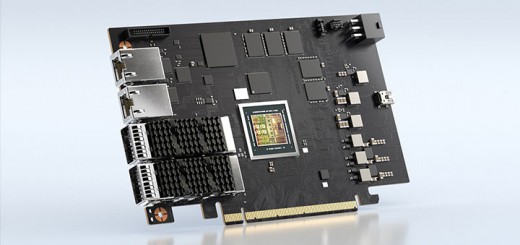

vSphere 向けのAI Enterprise は NVIDIA によってライセンス供与され、Dell Technologies、HPE、 Lenovo、Supermicroといったメーカーから大量に出荷されているサーバーを含む、NVIDIA-Certified Systems™(NVIDIA 認証システム)でサポートされています。これにより、要求の厳しい最新の AI アプリケーションでも、VMware vCenter などのデータセンター管理ツールを使用することで、一般的なインフラストラクチャ上にある従来のエンタープライズ ワークロードと同様に、簡単にサポートできます。

企業のIT部門 は可用性を管理し、リソース割り当てを最適化し、オンプレミスおよびハイブリッド クラウドで AI ワークロードを実行するための重要な IP データや顧客データのセキュリティを確保します。

スケーラブルかつマルチノードを実現する仮想化された AI パフォーマンス

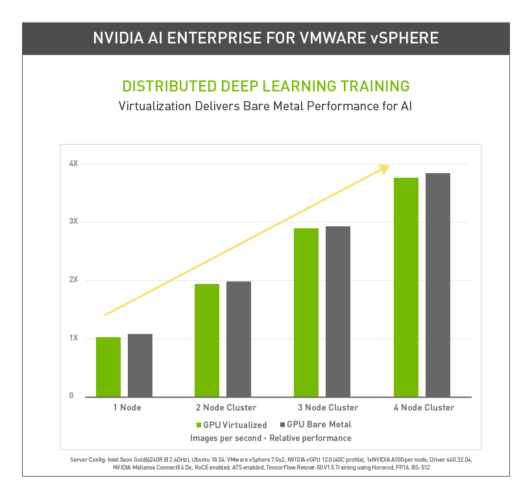

NVIDIA AI Enterprise は AI やデータ サイエンス向けの NVIDIA A100 GPU の記録的なパフォーマンスをサポートしているため、仮想ワークロードは vSphere 上でほぼベアメタルと同じパフォーマンスを実現します (以下の表 1 を参照)。AI ワークロードが複数のノードにまたがってスケールするようになり、大規模なディープラーニング トレーニング モデルも VMware Cloud Foundation でも実行できるようになります。

グラフ 1: vSphere 向けの NVIDIA AI Enterprise により、分散型ディープラーニング トレーニングは複数のノードをまたがって比例的にスケールし、ベアメタルと遜色ないパフォーマンスを実現します。

グラフ 1: vSphere 向けの NVIDIA AI Enterprise により、分散型ディープラーニング トレーニングは複数のノードをまたがって比例的にスケールし、ベアメタルと遜色ないパフォーマンスを実現します。AI ワークロードにはさまざまなサイズがあり、サイズによってデータ要件が異なります。例えばライブ型トラフィック レポート システムやオンライン ショッピングのレコメンデーション システムといった画像処理によるワークロードもあれば、対話型 AI を利用したカスタマー サービス サポート システムのような、テキストベースのワークロードもあります。

AI モデルのトレーニングは非常にデータ集約的であり、複数のノードの複数の GPU におよぶスケールアウト パフォーマンスが必要になります。一方、展開時にモデルで推論を実行する場合は、通常、求められるコンピューティング リソースはより少なく、単一の GPU が持つ性能のすべてが必要になるわけではありません。

NVIDIA と VMware のコラボレーションにより、vSphere は、NVIDIA マルチインスタンス GPU (MIG) テクノロジに対応したライブ マイグレーションのハイパーバイザー サポートを提供する唯一のコンピューティング仮想化ソフトウェアです。MIG により、各 A100 GPU をハードウェア レベルで最大 7 つのインスタンスに分割し、あらゆるサイズのワークロードを最大限に効率化できます。

AI アプリケーションとインフラストラクチャのための豊富なリソース

NVIDIA AI Enterprise には NVIDIA の主要なテクノロジとソフトウェアが備わっており、VMware Cloud Foundation で運用される仮想データセンター内の AI ワークロードの迅速な展開、管理、スケーリングが可能になります。

NVIDIA AI Enterprise は、主要な NVIDIA AI テクノロジと AI アプリケーション、およびエンタープライズ向けサポート サービスがセットになった、認証済みのエンドツーエンド スイートです。

NVIDIA AI Enterprise は、主要な NVIDIA AI テクノロジと AI アプリケーション、およびエンタープライズ向けサポート サービスがセットになった、認証済みのエンドツーエンド スイートです。vSphere 7 U2 へのアップグレード時に NVIDIA AI Enterprise の導入をお考えのお客様は、NVIDIA もしくは VMware にご連絡の上、ニーズについてご相談ください。

VMware ベースのデータセンターに AI を導入する方法の詳細については、NVIDIA 開発者ブログおよび VMware vSphere 7 U2 ブログをお読みください。

NVIDIA と VMware とともに AI の専門知識をさらに深めるために、GTC 2021 への無料登録をご検討ください。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE