新しい NGC コンテナ レプリケータにより、システム管理者が許可することで、ユーザーが最新の HPC および AI ソフトウェアをすぐに利用可能に

薬剤の開発から、ブラックホールの位置特定や安全な核エネルギー源の発見に至るまで、世界中のハイ パフォーマンス コンピューティング システムが、あらゆる科学領域でブレークスルーを実現させています。

NVIDIA Tensor コア GPU を搭載した、日本最速のスーパーコンピュータ ABCI も、AI の活用によって同様のブレークスルーを実現させています。このシステムは、科学の発展を目指す、研究者、エンジニアおよび産業界のユーザーのための、世界初の大規模オープン AI インフラストラクチャです。

発展を促進するために使用されるソフトウェアは、ソフトウェアが動作するサーバーと同じくらい重要です。しかし、HPC クラスタにアプリケーションをインストールするのは、複雑で、時間もかかります。研究者やエンジニアは、ソフトウェアへのアクセスを待つ間、生産的なことはできず、アプリケーションを先にインストールしておいて欲しいという、これら人々の要求は、システム管理者がミッションクリティカルなタスクを完了する妨げともなります。

コンテナとは、ソフトウェアと関連の依存性を含むパッケージであり、これによって、ユーザーは、実際にソフトウェアをインストールしなくても、ソフトウェアを呼び出し、実行させることができます。これは、ユーザーとシステム管理者にとってメリットがあります。

NGC で AI、機械学習および HPC ソフトウェアの利用性を向上

NGC は、ディープラーニング フレームワーク、機械学習アルゴリズム、ならびにHPC アプリケーションのための Docker と Singularity で実行される、50 以上の GPU に最適化されたコンテナを備えています。

HPC アプリケーションは、ノード内ならびにノード間の GPU でスケーラブルなパフォーマンスを提供します。NVIDIA では、主要なディープラーニング フレームワークとライブラリを継続的に最適化し、アップデートを毎月リリースしています。それによって、ユーザーは、自身のすべての AI プロジェクトのためのトレーニングと推論で最高の性能を得ることができます。

NGC コンテナでの ABCI の実行

研究者および産業界のユーザーは、ABCI を活用して、原子核物理学から製造に至る、多様な領域で AI を実装した科学的ワークロードを実行できるようになります。その他の人々も、システムの分散コンピューティングを活用して、AI トレーニングの速度の限界を押し広げることができます。

これを実現するには、ソフトウェアおよびハードウェア ツールの適切なセットが用意されていなければならず、ABCI が NGC を採用した理由もそこにあります。

AIST (産業技術総合研究所) 人工知能研究センターの研究チーム長である小川宏高氏は、次のように述べています。「ディープラーニングのフレームワークをいちからインストールする作業は煩雑で、頻繁にリリースされるソフトウェアアップグレードに都度対応していては、環境構築だけで多くの手間がかかります。NGC を使うと、ユーザーは最新のAIフレームワークの環境構築を簡便に行うことができ、NVIDIA の GPU で得られる性能を十二分に引き出すことができます。」

ABCI は、他のユーザーが求めていること、つまりポータビリティを実現するために、コンテナに着目しました。

「ABCIユーザーの大部分は産業セグメントに所属しており、自社のオンプレミスシステムや商用クラウドと ABCI とのポータビリティを求めています。NGC と Singularity のおかげで、ユーザーは、さまざまなプラットフォームを併用し、大規模に開発、テストおよびデプロイができるようになっています。我々のサンプリングデータによると、Singularity で実行されている 10 万以上のジョブの 80% で、NGC のコンテナが使用されています。」と小川氏は話しています。

NGC コンテナ レプリケータにより、システム管理者およびユーザーの使いやすさを向上

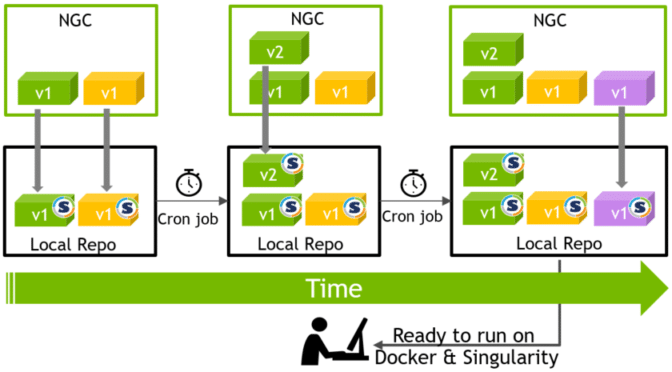

スーパーコンピューティング センターおよび大学で HPC システムを管理しているシステム管理者は現在、それぞれのクラスタで NGC コンテナ をダウンロードおよび保存できるようになります。これによって、ユーザーはソフトウェアにより早くアクセスでき、ネットワーク トラフィックを軽減させ、ストレージのスペースを節約できるようになります。

NVIDIA では、NGC コンテナの最新のバージョンを自動的にチェックおよびダウンロードする、NGC コンテナ レプリケータを提供しています。

これにより、システム管理者はなんの苦労もせずに、ユーザーが最新のソフトウェアから優れた性能と最先端の機能を得られるようにすることができます。

アプリケーション コンテナ以上のもの

ディープラーニング コンテナに加えて、NGC は、物体検知や自然言語処理、テキストから音声への変換といった、一般的なユース ケースのために、トレーニング済みの 60 のモデルと 17 のモデル スクリプトをホストしています。

最初からすべてをやるよりは、ユース ケース向けのトレーニング済みモデルを調整するほうが、時間が大幅に短縮されます。トレーニング済みモデルを使用することで、研究者は、ニューラル ネットワークの迅速な微調整またはすでに最適化されているネットワーク上に特定のユース ケースのニーズに合わせた構築ができるようになります。

モデル トレーニングのスクリプトはベスト プラクティスに基づいたもので、最先端の精度を持ち、優れた性能をもたらします。このようなスクリプトは、ゼロからネットワークを構築し、それをカスタマイズしたいと考えている研究者やデータ サイエンティストにとって理想です。

これらのモデルとスクリプトには、ディープラーニングの速度を前の世代に比べて最大 3 倍スピードアップさせる NVIDIA Tensor コア GPU を活用した、混合精度が採用されています。

NGC を試してみよう

NGC コンテナは、オンプレミスでも、クラウドでも動作するように構築およびテストされています。NGC コンテナは、ハイブリッドおよびマルチクラウドでのデプロイにも対応しています。ngc.nvidia.com では、GPU 搭載のシステムまたは主要なクラウド インスタンスでアプリケーション コンテナを取り出すことができます。次の科学研究で採用したいとお考えならば、how easy it is をご覧ください。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE