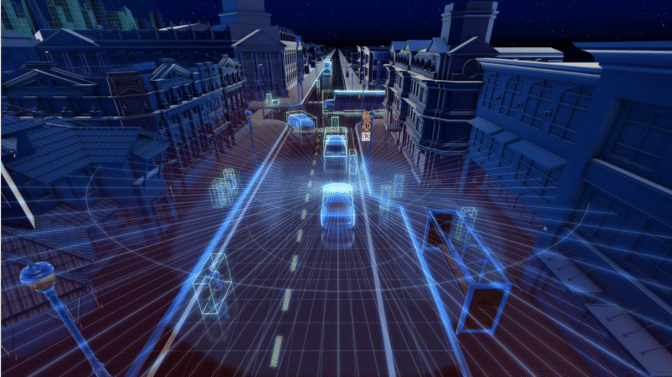

カメラ、レーダー、そしてライダーの各センサーが、人間を凌駕する視力を自律走行車にもたらします。

自律走行車が人間より上手に運転するには、まず人間を上回る視力が必要です。

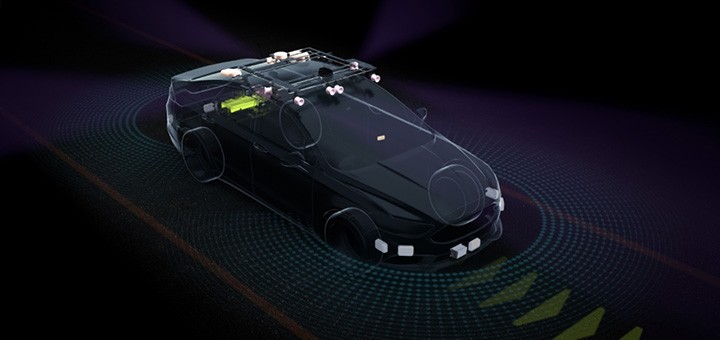

自律走行車向けの信頼度の高い視覚能力を構築することは、開発上の大きな課題でした。しかし、様々なセンサーを組み合わせることで、開発者たちは、人間を上回る視力で車両の周囲を「見る」ことが可能な検知システムを作成できるようになりました。

このシステムの鍵となるのは、さまざまな種類のセンサーによる多様性と、自動車が検知しているものが正確であることが検証できる、機能の重複した複数のセンサーによる冗長性です。

自律走行車の 3 つの主要なセンサーは、カメラ、レーダー、そしてライダーです。これらが協調することで、自動車に周囲の映像が提供され、近くの物体の速度、距離、そして 3 次元形状を検知することができます。

また、慣性計測装置と呼ばれるセンサーによって、車両の加速度と位置を追跡することが可能になります。

これらのセンサーがどのように自律走行車で機能し、運転中の人間の視覚に代わってその向上を図るのかを理解するため、まずはもっとも広く使われているセンサーであるカメラに注目してみましょう。

カメラは決して嘘をつかない

写真からビデオに至るまで、カメラは、特に自律走行車に関して言えば、世界を視覚的に表現するのにもっとも的確な手段です。

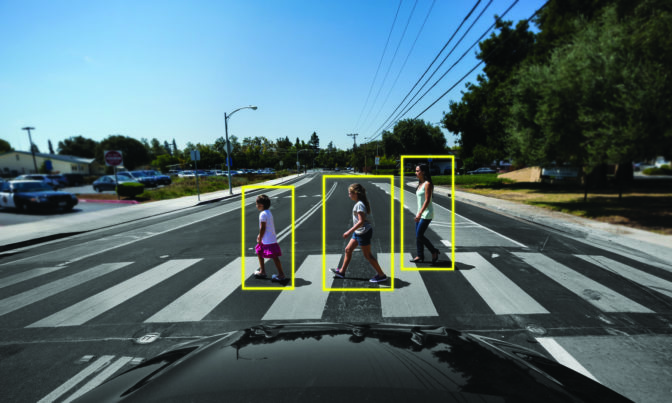

自律走行車は、周囲の 360 度ビューを合成するために、前後左右すべての面に設置されたカメラに依存しています。中には、120 度もの広い画角と短めの撮影距離を持つものもあります。また、長い撮影距離を提供するために狭めの画角に注力しているものもあります。

自動車によっては、自動駐車用に車両後部の全体像を提供するため、パノラマ ビューを提供する超広角レンズを内蔵した魚眼カメラを統合しているものすらあります。

カメラは正確な映像をもたらしますが、限界があります。周辺環境を詳細に感知することができますが、障害物がどこにあるのかを正確に知るには、障害物との距離を計算する必要があります。また、霧、雨、または夜間などの視界不良条件下では、カメラベースのセンサーで物体を検知するのはさらに困難です。

レーダー捕捉

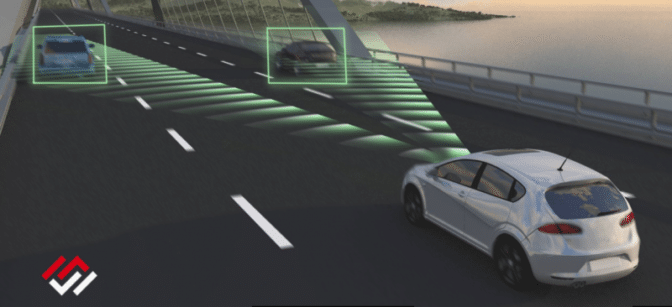

レーダー センサーは、夜間走行などの視界不良時にカメラ映像を補い、自律走行車の物体検知能力を改善します。

従来、船舶、航空機、そして天候の形成を検知するのに使用されてきたレーダーは、電波をパルス状に発射することで機能します。こうした電波は物体に当たるとセンサーに戻り、物体の速度と位置に関するデータをもたらします。

車両のカメラ同様、レーダー センサーは、全方向の物体を検知するために、車両の周囲に設置するのが普通です。レーダー センサーによって速度と距離が測定できますが、車両の種類を区別することはできません。

レーダーとカメラが提供するデータは、下位レベルの自動運転では十分ですが、人間のドライバーがいないとすべての状況に対応できません。そこで登場するのがライダーです。

レーザー焦点

カメラとレーダーは一般的なセンサーであり、今日の新型車の大半で、高度な運転アシストと駐車アシスト用にすでに使用されています。また、人間がシステムを監視する場合、カメラとレーダーで下位レベルの自動運転をカバーすることもできます。

しかし、完全なドライバーレス能力には、パルス状のレーザーによって距離を測定するセンサーであるライダーが非常に有用であることが分かっています。

ライダーによって、自律走行車は周囲の 3D ビューを得ることができます。ライダーは、周囲の自動車と歩行者に形状と奥行きを与え、道路形状データももたらします。また、レーダーと同じく、低光量でもうまく機能します。

目に見えないレーザーを超高速で放出することで、ライダー センサーは、一瞬で戻ってくる信号をもとに詳細な 3D 画像を描画することができます。センサー データの安全性や多様性を向上させるため、こうした信号によって、車両の周辺環境を表現する「点群」が生成されます。

ライダーは、車両の 2、3 の重要箇所に設置しさえすれば効果があります。ただし、ライダー センサーの実装費用はより高額で、カメラとレーダーの 10 倍もの費用がかかる上、有効範囲はこれよりも限定的です。

すべてを組み合わせる

カメラ、レーダー、そしてライダーの各センサーは、自動車の周囲に関する豊富なデータを提供します。しかし、人間の脳が、目から取り込まれた映像データを処理するように、自律走行車はこの絶え間ない情報の流れを理解できなければなりません。

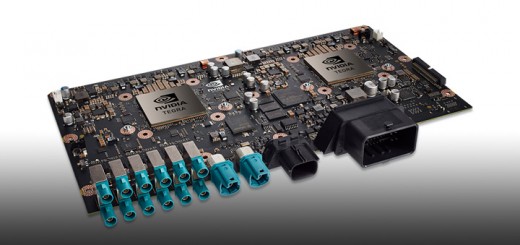

自律走行車は、これをセンサー フュージョンと呼ばれるプロセスで行います。センサーからの入力は NVIDIA DRIVE AGX プラットフォームといった集中型ハイパフォーマンス AI コンピューターに送り込まれ、そこでは、自動車が走行に関する決定を行えるよう、入力データのうち関連のある部分が組み合わされます。

したがって、センサー フュージョンは、特定の瞬間に 1 種類のセンサー データにのみ依存するのではなく、信頼性を確保するため、形状、速度、距離など、センサー一式からの多様な情報を融合することができます。

またセンサー フュージョンは、冗長性ももたらします。車線を変更することを決定した場合、次の車線に移動する前にカメラとレーダーの両センサーからデータを受信することで、現在の死角警告が人間のドライバーのバックアップとして役立っているのと同様に、車線変更の安全性が大幅に上昇します。

DRIVE AGX プラットフォームは、自動車の走行中にこのプロセスを実行するため、常に周辺環境の完全で最新の全体像を持っていることになります。これはつまり、人間のドライバーと違って、自律走行車には死角がなく、しかも車両周辺の移動し変化する環境を常に警戒しているということです。

自律走行車がどのように道路環境を認識して理解するかについてより詳しく知るには、NVIDIA の認識ソフトウェアについてのブログ(英文)、および NVIDIA DRIVE プラットフォーム のページをご参照ください。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE