LIDAR検出器4基。魚眼カメラ4台。狭角カメラ2台。GPS。

あちこちに日が差すシリコンバレーの高速道路を制限速度でゆったり走る――そのあいだも、運転している特別装備のラグジュアリー・スポーツ・セダンは、毎秒毎秒、かなりの量のデータを集めています。

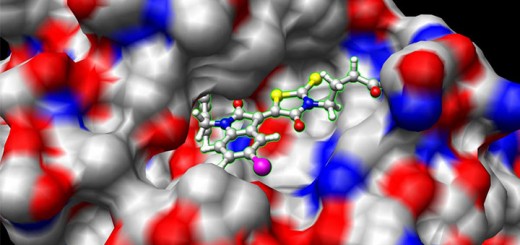

ただ、センサでいくらデータを集めても、まとめることができなければ、なんの役にも立ちません。

事務所について駐車場に入れば、車の全周を見ることができます。このAudi A6に装備されている4台の魚眼カメラを通じた映像がセンターコンソールのディスプレイに表示されるからです。それでも、角を曲がろうとした瞬間、別の車にクラクションを鳴らされることはあるかもしれません。

前を(そしてその先を)見る

ディープラーニングをデータセンタから混雑した道路へ持ちだしているのはなぜか、その理由がこれ以上ないというくらいよくわかる例があります。

今週ラスベガスで開催されているコンシューマー・エレクトロニクス・ショー(CES)で、NVIDIAは、DRIVE PX 2を発表しました。そして、DRIVE PX 2を使ったシステムの模型として、巨大なダッシュボードを展示しています。

車の「フロントガラス」には、特別装備のアウディを走らせて収録した動画を流しています。その下にあるのが、次世代メータパネルのデモで、そこには、車を上から、また、後ろから見ているかのような形で、道路やほかの車、さらには、算出された自車の走行経路が表示されています。

だから、さっと見ただけで状況がつかめます。フロントガラスからドアミラー、ルームミラーと実際に頭を巡らせて見るより、このほうが安心できるはずです。

次世代の運転体験を実現するデジタル・エンジン

自動車関連のディープラーニングについて語るとき、まず取りあげなければならないのがNVIDIA DRIVE PX 2です。DRIVE PX 2には次世代型のパワフルなTegraプロセッサとPascalアーキテクチャのディスクリートGPUが搭載されており、グローブ・ボックスに入るほどの大きさなのに、ディープラーニングの演算を1秒間に24兆回も行うことができます。

展示している車がセンサから受けとる膨大な量のデータを処理するには――しかもリアルタイムに処理するには――このくらいのパワーがなければいけないのです。研究者はサーバを何ラックも重ねてセンサ・フュージョン・システムを作ってきましたが、量産車にさっと組み込めるコンパクトなシステムで同じことをしようというわけです。

24テラフロップスもの処理能力があれば、相互に補完する各種センサで集めたデータをひとつにまとめ、さまざまなアドバンスト・ドライバ・アシスタンス機能をリアルタイムに実現することができます。このデータを短時間に処理し、運転者に提示できれば、全方位モニター、衝突回避、歩行者検出、交差点における交通の監視、居眠り運転防止などの機能が実現できるのです。

もっとディープに

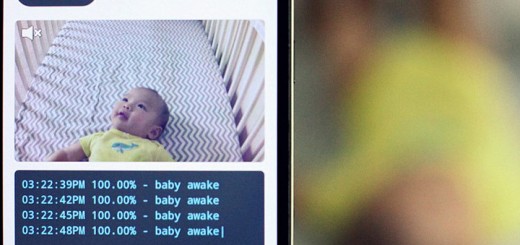

それだけではありません。DRIVE PX 2は、ディープラーニングを活用して膨大な情報から自己学習ができるようになっています。DIGITSというディープ・ニューラル・ネットワークのソフトウェア開発キットも用意されていますし、動画のキャプチャや処理などが行えるライブラリも用意されているのは、そのためです。

ディープ・ニューラル・ネットワークは、人間が経験から学ぶのと同じようなやり方で学んでいくことができます。だから、ここ数カ月にわたり、各種センサ装備のこのアウディを、シリコンバレーのハイウェイ101号線で走らせてきたのです。集めたデータが多いほど、システムは賢くなります。

GPUを使ったディープラーニング・システムでモデルを構築したら、それを自動車に組み込みます。DRIVE PX 2でリアルタイムに処理する形とするのです。データが増えたら、システムのトレーニングをくり返します。

つまり、OTA(Over The Air)ソフトウェア・アップデートで車はどんどん賢くなれるわけです。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE

Pingback: GPSより高度に――HDマップが自律走行車に道を示す | NVIDIA