ニューヨークの人は、よく、「話をしようじゃないか」と声をかけます。でも最近は、音声認識、画像理解、言語翻訳の技術が進んだおかげで、コンピュータもコミュニケーションができるようになりつつあります。

このようなディープラーニングのタスクは難しすぎると思われていましたが、最近は、それをメインストリームにしようという動きが大学や研究機関のあいだに広がっています。そのひとつがニューヨーク大学のデータ・サイエンス・センターです。ここでは、コンピュータ・サイエンスを支えるふたつの重要領域、すなわち、機械学習と並列・分散型のシステムを進歩させることで、それを実現しようとしています。そうすれば、アプリケーションのプログラマが膨大なデータ・セットを簡単かつ効率的に取り扱えるようになるからです。

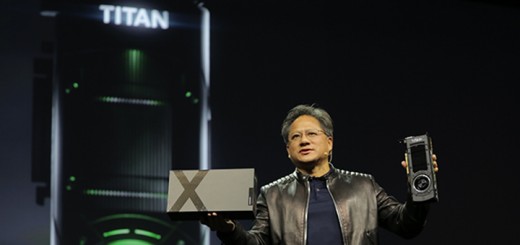

ニューヨーク大学データ・サイエンス・センターは、ディープラーニングのパイオニアで、FacebookでAI研究のディレクタも務めているYann LeCun氏が創設しました。このセンターは、GPUベースのディープラーニングや並列処理の研究および教育を推進しているNVIDIAと緊密な協力関係にあります。

このようなことが背景にあり、NVIDIAは、ニューヨーク大学データ・サイエンス・センターをGPUセンターー・オブ・エクセレンスに選定したわけです。

LeCun氏は、次のように述べています。「今回、GPUセンターー・オブ・エクセレンスに選ばれたことを大変うれしく思っていますし、NVIDIAのサポートにも感謝しております。今後、ディープラーニングに新たな道を切り拓く研究を続け、次世代のデータ・サイエンティストを育てていくにあたり、今回のことは大きな助けになると考えています。」

ボトルネックの解消

取り扱うデータ・セットのサイズが大きくなり、アルゴリズムがどんどん高度になってきた結果、研究にボトルネックが生まれるようになってしまいました。1台のマシンで利用できる計算処理能力とメモリ量に制限があるからです。

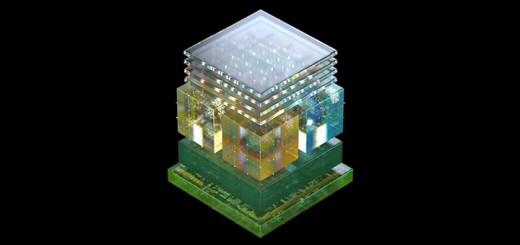

ディープ・ニューラル・ネットワークの研究を進めるためには、1台のマシンの限界を超える方法を見つけなければなりません。そのため、GPUの出番となるわけです。データ・サイエンス・センターと協力し、NVIDIAでは、スケーラブルな学習アルゴリズムと分散型トレーニング・システムの開発に注力していく計画です。

このようなアルゴリズムやシステムがあれば、いままでは人間でなければ認識できなかった物体をコンピュータが認識できるようになります。パターンやオブジェクトを認識できるようにディープ・ニューラル・ネットワークをトレーニングするには膨大な時間がかかるのですが、GPUを活用すれば、その時間を短縮するとともに、データ・インフラストラクチャの使用量も減らすことができます。

今後、NVIDIAでは、データ・サイエンス・センターと協力し、分散型トレーニング・システムの特徴であるスケーラブルなメモリと計算資源を活用できる新しいディープ・ニューラル・ネットワーク・アーキテクチャを開発したいと考えています。共同研究プロジェクトとして、すでに、大規模な学習課題に挑戦する研究プロジェクト4件が計画されています。

コラボレーションのチャンス

研究者にCUDAや並列プログラミング・モデルの使い方を学んでもらい、GPUアクセラレータ搭載システムの高いコンピューティング・パフォーマンスを活用して、データ・サイエンス分野の研究を進めてもらうというのが、データ・サイエンス・センターとコラボレーションする目的です。

このほか、Torchの進化も図りたいと考えています。Torchとはもともとニューヨーク大学が開発した機械学習のフレームワークで、ディープ・ニューラル・ネットワークと最適化をはじめとするモジュールが山のように用意されています。アルゴリズムや分散型トレーニング・システムが進化すればTorchも使いやすくなり、ディープラーニング研究を進めやすくなります。

ニューヨーク大学のデータ・サイエンス・センターは、世界に23カ所あるGPUセンターー・オブ・エクセレンスのひとつとして、今後、研究や高等教育プログラムを支援するためNVIDIAが提供している機器やグラントを活用していくことになります。ニューヨーク大学のデータ・サイエンス・センターにおいて、さらには、クーラント数理科学研究所においても、すでに、NVIDIA GPUを使ったハードウェアおよびソフトウェアのツールキットを活用した講座が提供されています。

今後進められる可能性があるコラボレーションとしては、ディープラーニング・ハッカソン・シリーズや機械学習プロジェクトのサマースクールなど、大規模機械学習に焦点を当てたものが検討されています。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE