来年にデビューが予定されているNVIDIAのPascal GPUアーキテクチャは、ディープラーニングアプリケーションの処理速度が、現行のMaxwellプロセッサに比べて10倍にも達する予定です。

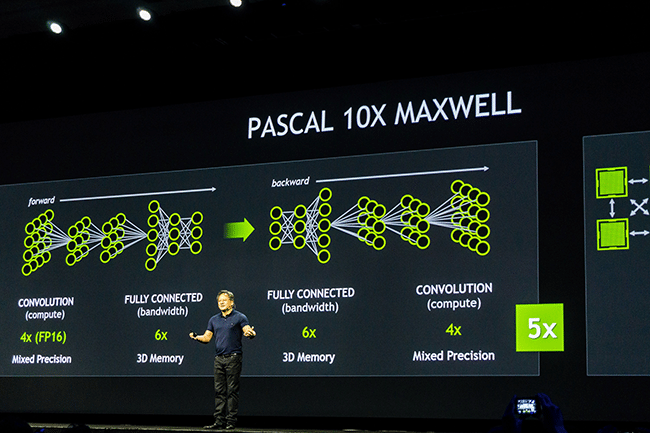

シリコンバレーで開催されたGPU Technology Conferenceの基調講演において、集まった4,000人を前に、NVIDIAのCEO兼共同創立者、ジェンスン・フアン(Jen-Hsun Huang)がプロセッサの最新ロードマップとPascalの詳細を紹介しました。

「この成果は、この3年間、10億ドルもの費用を研究開発に注いで実現したものです」と、ジェンスン・フアンは宣言しました。

ディープラーニングというのはニューラル・ネットワークを使ってコンピュータが自ら学んでいくプロセスのことですが、ディープラーニングの応用が広がっていることをうけ、NVIDIAは、昨年のGTCで発表したPascalの設計改良を進めてきました。

Pascal GPUには特徴的な機能が3つ用意され、そのおかげで、いままでよりリッチなディープ・ニューラル・ネットワーク(人間の大脳皮質とよく似たデータ構造で、ディープラーニング研究の基礎となるもの)のトレーニングを正確かつ高速に行えるようになります。

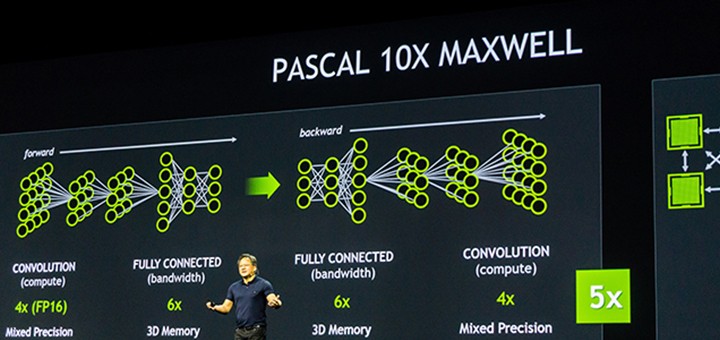

Pascalでは、メモリが最新のNVIDIAフラッグシップ・モデル、GeForce GTX TITAN Xの2.7倍にあたる32GBとなるほか、混合精度演算が可能になります。3Dメモリも用意され、ディープラーニングアプリケーションの実行が最大で5倍に向上します。GPU同士を接続するNVIDIAの高速インターコネクト、NVLinkにも対応しており、ディープラーニングの総合効率が10倍に向上します。

Pascalは、ディープラーニング関連の主要タスクでMaxwellよりも高いパフォーマンスを発揮します。

混合精度演算――精度の向上

混合精度演算に対応したPascalアーキテクチャのGPUでは、16ビット浮動小数点精度の演算を32ビット浮動小数点精度の倍の速度で行うことができます。

浮動小数点演算のパフォーマンスが高くなると、ディープラーニングで特に重要となるふたつの処理、分類と畳み込みについて、必要な精度を確保しつつ速度を上げることが可能になります。

3Dメモリ――通信速度と電力効率の向上

GPUにデータを提供する速度はメモリ帯域幅で決まります。3Dメモリを採用すると、Maxwellに比べて帯域幅が3倍、フレームバッファ容量も3倍近くまで増加します。その結果、構築できるニューラル・ネットワークの規模も大きくなりますし、帯域幅の影響を受けやすいディープラーニング・トレーニングの処理速度も向上します。

通常、メモリ・チップはプロセッサ・ボードでGPUから離れた位置に配置しますが、Pascalでは、メモリ・チップを積み上げ、GPUのすぐ横に配置します。つまり、メモリとGPUのあいだをビットが行ったり来たりする距離がセンチメートル単位からミリメートル単位まで短縮されるわけです。その結果、通信速度が大幅にスピードアップし、電力効率も改善されます。

NVLink――データ移動速度の向上

NVLinkを採用したPascalでは、GPUとCPUのあいだのデータ移動速度が、現在の標準であるPCI-Expressに比べて5倍から12倍にも改善されます。これは、GPU同士の通信が大量に必要となるディープラーニングなどのアプリケーションにとって大きなメリットです。

NVLinkを使うと、ディープラーニングにおいて組み合わせられるGPUの数が倍増します。さらに、CPUとGPUのつながり方もPCI-Eに比べて改善され、柔軟性とエネルギー効率の高いサーバを設計することが可能になります。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE