未来はすでに到来している。ある場所が偏っているだけだ」などと言われたりします。そんなことを言われるのは、トランク一杯のコンピュータが必要だからかもしれません。

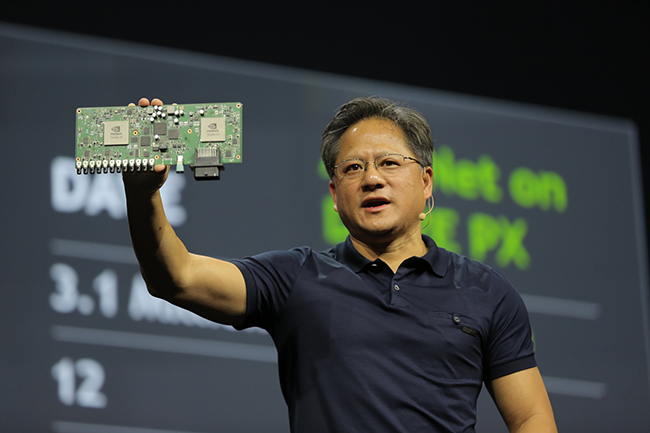

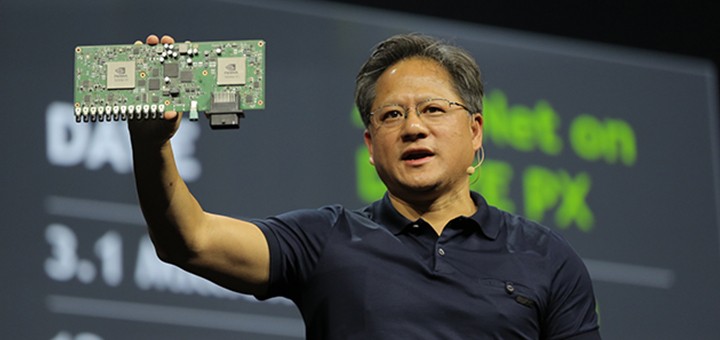

だから、NVIDIAは、本日、NVIDIA PX開発プラットフォームの価格と発売予定を発表したのです。

今年1月のコンシューマー・エレクトロニクス・ショーで発表したNVIDIA DRIVE PXは自律走行自動車用のパワフルなコンピュータで、ディープ・ニューラル・ネットワークのパワーを現実世界の車に応用するためのものです。

NVIDIAでは、自動車メーカー、ティア1の自動車サプライヤ、研究機関に対し、今年5月から、DRIVE PX開発プラットフォームを提供することにしました。自動車が運転をしてくれる時代がすぐそこまで来たのです。

自律走行自動車の走行試験を行っている、あるいはもうすぐ行う予定の自動車メーカーが増えていますが、NVIDIA DRIVE PXは、そのような自動車メーカー向けに開発した製品です。

これらのメーカーは、いずれも、車両各部に配置されたセンサとカメラからストリーミングされるデータをリアルタイムに処理・分析するにあたってNVIDIA GPUテクノロジを活用しています。

提携先のなかには、自律走行の自動車に米国横断旅行をさせる計画を発表したところもあります。

DRIVE PXにはNVIDIA Tegra X1プロセッサが2基搭載されており、その処理能力は2.3テラフロップスに達します。これほどの能力が、1個あたり親指の爪ほどしかないスーパーチップに集約されているのです。

NVIDIA DRIVE PXはTegra X1プロセッサ2個で2.3テラフロップスもの処理能力をたたき出します。

これほどの能力があれば、12台のカメラからストリーミングされるデータをまとめて解析し、さまざまなアドバンスト・ドライバ・アシスタンス機能を同時並行に実現することができます。たとえば、全方位モニター、衝突回避、歩行者検出、サイドミラーレス、交差点における交通の監視、居眠り運転防止といった機能が考えられます。

多ければ多いほどいい

DRIVE PXはもともと高い能力を持っているわけですが、さらに、「ディープラーニング」と呼ばれる新技術を活用し、いまの乗用車では実現不可能な機能各種を実現することができます。

その理由は、いまのアドバンスト・ドライバ・アシスタンス・システムが、周囲のオブジェクトを車載センサで検出し、分類することを基本に進化してきたからです。

この方法はそれなりにうまく行くのですが、十分とは言えません。あらゆる可能性に対応できるレベルまでシステムをトレーニングするのは不可能だからです。

この問題に対処するため開発されたのが、NVIDIAのDRIVE PX開発プラットフォームです。このプラットフォームでは、動画のキャプチャや処理が行えるライブラリのほか、我々がDIGITSと名付けたディープ・ニューラル・ネットワークのソフトウェア開発キットが使えます。

DIGITSはディープラーニング用のトレーニング・システムで、新たに発表されたDIGITS DevBox開発プラットフォームなど、NVIDIAのGPUを搭載したシステムで使うことができます。このシステムを使えば、周囲に存在するオブジェクトの認識方法をコンピュータ自身が学んでいけるのです(詳しくは、NVIDIA Parallel Forallブログの記事DIGITs: Deep Learning Training Systemをご覧ください)。

人間が体験から学ぶのと同じように、ディープ・ニューラル・ネットワークが自ら学ぶのです。オブジェクトを認識できるようにシステムをトレーニングするだけでなく、これからは、挙動のトレーニングもできるようになります(この原理については、Here’s How Deep Learning Will Accelerate Self-Driving Carsをご覧ください)。

DIGITS DevBoxでモデルを構築したら、それを車両にロードし、DRIVE PXでリアルタイムに実行させればいいわけです。

このシステムなら、いったんトレーニングしたあと、データが増えたら再トレーニングすることができます。OTA(Over The Air)アップデートをすると、そのたびに、自律走行自動車がどんどん賢くなっていきます。

その結果、いまの自動車に搭載されているハードウェアでは到底不可能な自動運転システムが完成します。しかも、トランクにわけのわからない電子機器をめいっぱい詰め込む必要もありません。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE

Pingback: 3 都市目の地域 GPU テクノロジー・カンファレンスがまたもや満員―― NVIDIA が発表する最新 AI テクノロジに注目が集まる | NVIDIA