まもなく、画面上にゲームを映し出すための GPU と同じものを使って、AI の能力を利用できるようになります。これにより、ゲームや映画の制作会社の皆さまは、作業時間を短縮し、コストを削減しながらも、より充実した体験を創出できるようになります。

NVIDIA は今週の SIGGRAPH 2017 で、実際の人物の顔をアニメーションに変換する、特定のシーンで光が表面とどのように作用し合うかについてシミュレーションを行う、現実的な画像をより速くレンダリングするといった作業を、はるかに簡単に実行できるようにするための研究をご紹介しています。

NVIDIA は、当社の AI における専門知識とコンピューター グラフィックスにおける長い歴史とを融合させ、ゲーム、仮想現実、映画、製品デザイン用の 3D グラフィックスを進化させるべく取り組んでいます。

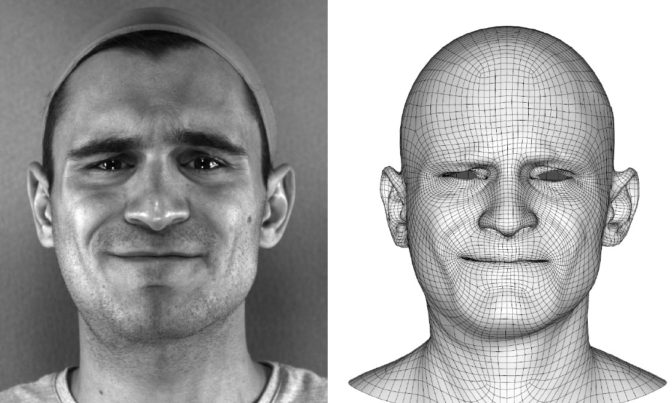

顔アニメーションを次の段階へ

ゲーム スタジオでは、ゲーム内で使われる各キャラクターの台詞すべてを俳優が演じ、それを録画することで顔のアニメーションを作成します。各社とも、ソフトウェアを使ってその動画を俳優のデジタルダブルに変換し、その後、顔のアニメーションに利用します。

既存のソフトウェアでは、アーティストが何百時間もかけてそれらのデジタル化された顔を実際の俳優に似せるための修正を行う必要があります。これは、アーティストにとっては時間のかかる作業であり、スタジオにとってはコストのかかる作業なので、いったん完成させると変更が難しくなります。

顔アニメーションの作成にかかる工数を短縮できれば、ゲーム アーティストがキャラクターの台詞や脇役の数をより充実させることができ、さらに、スクリプトの変更時には、柔軟にすばやく処理を繰り返すことができるようになるでしょう。

NVIDIA リサーチは、『Quantum Break』、『Max Payne』、『Alan Wake』などのゲームで最もよく知られている Remedy Entertainment から、より少ない労力と低コストで現実的な顔アニメーションを作成する技術の開発支援を依頼されました。

人工知能でゲーム キャラクターの顔を生成

NVIDIA の研究者であるサムリ ライネ (Samuli Laine)、テロ カラス (Tero Karras)、ティモ アイラ (Timo Aila)、ヤーコ リュハネン (Jaakko Lehtinen) は、Remedy が保有する膨大なアニメーション データ、NVIDIA の GPU、およびディープラーニングを利用し、俳優の動画から直接顔アニメーションを作成するためのトレーニングをニューラル ネットワークに行いました。

NVIDIA のソリューションでは、多大な労力を要するデータ変換を実行して俳優の動画の手直しを何時間もかけて行う必要はなく、5 分間のデータ トレーニングだけで済みます。トレーニングが済んだネットワークは、シンプルな動画ストリームからゲーム全体に必要なすべての顔アニメーションを自動的に生成します。NVIDIA の AI ソリューションでは、既存の手法と同等の忠実度を保ったまま、より一貫性の高いアニメーションを作成できます。

研究チームはさらに一歩前進し、音声だけを使って現実的な顔アニメーションを生成するためのトレーニングをシステムに行いました。ゲーム スタジオがこのツールを利用すれば、ゲームの脇役を増やしたり、ライブでアニメーション化されたアバターを作成したり、より簡単に多言語でゲームを制作したりすることが可能になります。

ゲーミングの新時代へ

Remedy のリード キャラクター テクニカル アーティストであるアンティ ヘルヴァ (Antti Herva) 氏は、今後これらの新しい手法によって、スタジオは、現在構築できるものよりも多くのキャラクターが登場する、より大規模で濃密なゲームの世界を構築できるようになる、と言います。スタジオでは、すでに質の高い顔アニメーションの作成をこれまでよりもはるかに短時間で進めています。

さらに、ヘルヴァ氏はこう続けます。「AI を利用した顔アニメーションにおいて NVIDIA リサーチの研究を目の当たりにすることで、私たちは、AI がコンテンツ制作を変革するだろうと確信しました。『Quantum Break』で使われたようなデジタル ダブルの複雑な顔アニメーションは、その作成に何人年もの工数がかかることがあります。顔アニメーション用の動画と音声に基づくディープ ニューラル ネットワークを構築する NVIDIA との共同開発が完了すれば、大規模プロジェクトにかかる時間を 80% 短縮することが可能になるため、アーティストは別の作業に集中できるようになるでしょう。」

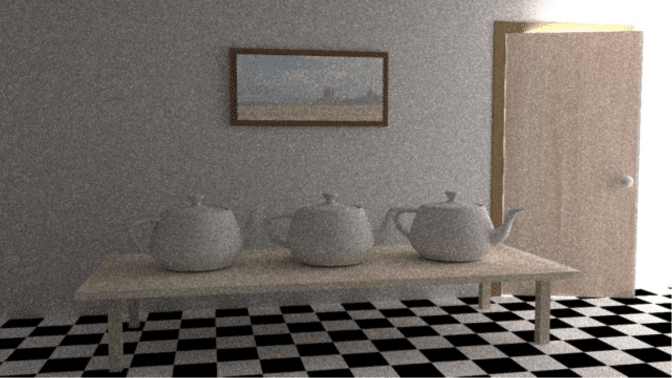

AI による画像の作成

画面上でデジタル世界を現実感のある画像に変換するプロセスである、3D グラフィックスのレンダリングにおいても、AI の活躍が期待されています。映画制作会社やデザイナーは、レイトレーシングと呼ばれる技術を利用し、仮想シーンの表面から反射する光のシミュレーションを行います。NVIDIA は AI を利用し、レイ トレーシングとラスター化 (コンピューター ゲームで使われる比較的低コストのレンダリング技術) の両方の向上を目指しています。

レイ トレーシングでは非常に現実的な画像を生成できますが、画像ごとに何百万本もの仮想光線のシミュレーションを行うには莫大な計算コストがかかります。しかし、処理途中の画像には、光の少ない状況で撮影された写真のようにノイズが発生してしまいます。

そこで、研究チームは、最終的な画像からノイズを除去するために、GPU によるディープラーニングを利用して、処理途中の画像から最終的にレンダリングされた画像を予測させることにしました。マギル大学から参加した NVIDIA の研究インターンであるチャクラヴァルティ R アッラ チャイタニヤ (Chakravarty R. Alla Chaitanya) が率いる研究チームは、ノイズの多い完成途中の入力画像から質の高い画像を従来の手法の数分の 1 の時間で生成できる AI ソリューションを開発しました。

この研究は単なる研究プロジェクトを超え、間もなく製品化される予定です。このたび NVIDIA は、当社のレイ トレーシング エンジンの最新バージョンである NVIDIA OptiX 5.0 ソフトウェア開発キットを発表しました。NVIDIA リサーチの AI ノイズ除去技術を採用した OptiX 5.0 は、登録済み開発者の皆さまを対象に、11 月に無償で提供される予定です。

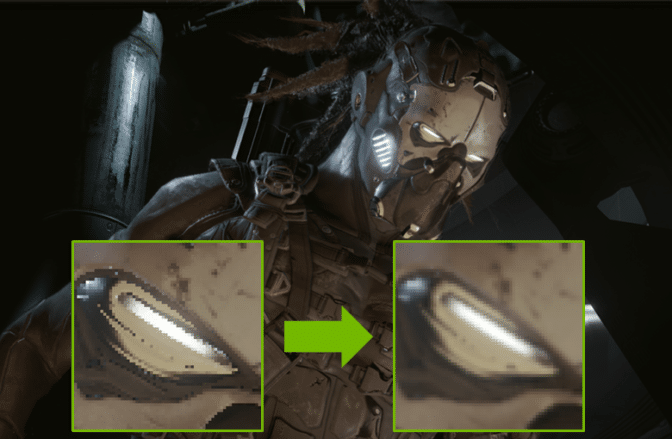

AI が粗いエッジを滑らかに

NVIDIA の研究チームは AI を利用して、アンチエイリアシングと呼ばれるコンピューター ゲームのレンダリングにおける問題に取り組みました。アンチエイリアシングとは、ノイズ (この場合は、レンダリング途中の画像に見られるギザギザのエッジ)を低減するための方法の 1 つです。このノイズは、本来滑らかに見えるはずの直線がギザギザに見えるため、「ジャギー (ギザギザ)」と呼ばれます (下の画像の左側の挿入画像を参照してください)。

NVIDIA の研究者であるマルコ サルヴィ (Marco Salvi) とアンジャル パトニー (Anjul Patney) は、それらのアーティファクトを認識して、そのピクセルをアンチエイリアス処理が行われた滑らかなピクセルに置き換えるためのトレーニングをニューラル ネットワークに行いました。その AI ベースのテクノロジは、既存のアルゴリズムよりもシャープな画像を生成できます。

左側の挿入画像は、エイリアス処理された画像を示しており、ジャギーで、ブロックノイズが発生しています。そこで、NVIDIA の AIによるアンチエイリアシング アルゴリズムが、エイリアス処理された画像からアンチエイリアス処理された画像へのマッピングを学習して、大きな画像と右側の挿入画像を作成しました (画像提供: Epic Games)。

AI が必要な光線をトレースするしくみ

NVIDIA では、より効率的に仮想光線をトレースするための手法の開発を進めています。コンピューターは、写実的な画像を生成するためにさまざまな光線の軌道をサンプリングします。問題は、すべての光線の軌道が最終的な画像で使われるわけではないということです。

研究者のケン ダウム (Ken Daum) とアレックス ケラー(Alex Keller) は、機械学習を利用して光線の軌道の選択を導くことにしました。そこで、光線のトレースに関する計算と AI の強化学習の概念を組み合わせました。

彼らのソリューションは、「役に立つ」軌道 (光と仮想カメラとを結ぶ可能性の高い軌道) と画像で使われない軌道を区別することを学習します。

細く開けられたドアからしか光が入ってこないため、この仮想シーン内で光の反射のシミュレーションを行うことは困難です (ノイズ除去なし)。NVIDIA の AI によって導かれた光のシミュレーションなら、必要な仮想光線の数を減らすことで画像の合成時間が最大 10 分の 1 に短縮されます。

SIGGRAPH での NVIDIA の AI 研究

SIGGRAPH では、AI がコンピューター グラフィックスにもたらす変革についてより詳しく知ることができます。ぜひ、火曜日以降に NVIDIA のブース #403 にお立ち寄りいただくとともに、NVIDIA の AI 研究に関する SIGGRAPH のトーク セッションにもご参加ください。

8 月 1 日 (火) ‐ 終了

- 「ディープラーニング: リアルタイム レンダリングの未来」 (「Open Problems in Real-time Rendering」コースの一環)、ルーム #408AB、午後 2 時~ 5 時 15 分

8 月 2 日 (水) ‐ 終了

- 「Audio-Driven Facial Animation by Joint End-to-End Learning of Pose and Emotion」、ルーム #153、午前 9 時~ 10 時 30 分

- 「Interactive Reconstruction of Monte Carlo Image Sequences Using a Recurrent Denoising Autoencoder」、ルーム #150/151、午前 10 時 45 分~午後 0 時 35 分

8 月 3 日 (木)

- 「Learning Light Transport the Reinforced Way」、ルーム #153、午後 3 時 45 分~ 5 時 15 分

本記事の最上部の画像は、人工知能によってレンダリング途中の画像 (左) を最終的な画像 (右) に変換して画像の合成を加速させた、NVIDIA の研究者らによる SIGGRAPH の論文に使われています。