【プレス リリース】カリフォルニア州サンノゼ — GTC — 2025 年 3 月 18 日ー NVIDIA は本日、AI ファクトリーにおける AI リーズニング モデルの高速化および拡張を、最小限にコストを抑え、効率性を最大限に高めることが可能なオープンソースのリーズニング ソフトウェア、NVIDIA Dynamo を発表しました。

AI ファクトリーの稼働コストを最小限に抑えトークン収益を最大化するには、多数のGPU間で AI 推論リクエストを効率的にオーケストレーションし調整することが極めて重要になります。

AI リーズニングが主流になるにつれ、あらゆる AI モデルが、1 つのプロンプトごとに「思考」するために数万ものトークンを生成するようになります。推論性能を向上させながら、推論コストを継続的に削減することで、サービス プロバイダーの成長が加速し、収益機会が拡大します。

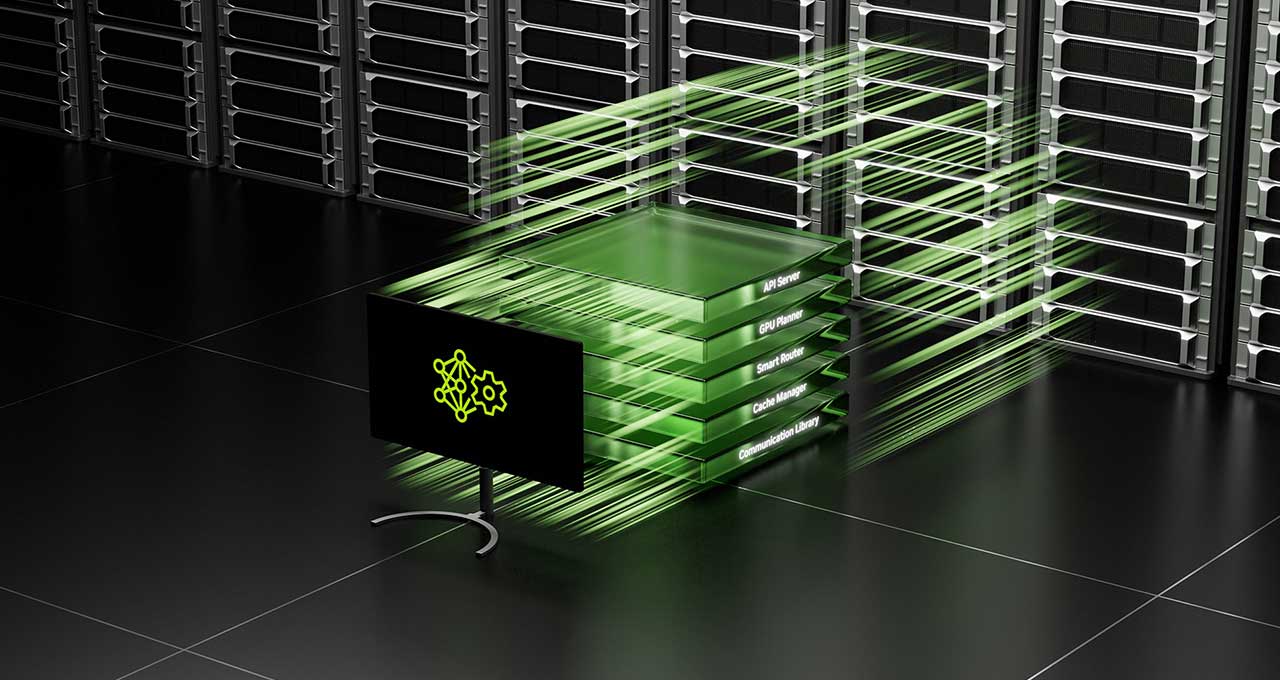

NVIDIA Dynamo は、リーズニング AI モデルを展開する AI ファクトリー向けに、トークン収益の最大化のために設計された NVIDIA Triton Inference Server™ の後継となる新しい AI 推論サービス ソフトウェアです。 数千の GPU 間での推論処理をオーケストレーションおよび高速化し、分散処理をして大規模言語モデル (LLM) の処理フェーズと生成フェーズを異なる GPU に分散します。 これにより、各フェーズがその特定のニーズに合わせて個別に最適化され、GPU リソースを最大限に活用することができるようになります。

NVIDIA の創業者/CEO であるジェンスン フアン (Jensen Huang) は、次のように述べました。「AI モデルは、世界のあらゆる産業において、さまざまな方法で思考し、学習できるようにトレーニングされており、益々高度なものになっています。カスタムのリーズニング AIの未来を実現するために、NVIDIA Dynamo はこれらのモデルを大規模に提供し、AI ファクトリー全般でのコスト削減と効率化を推進します」

同じ数の GPU を使用した場合、Dynamo は現在の NVIDIA Hopper™ プラットフォーム上で Llama モデルを処理する AI ファクトリーのパフォーマンスと収益を 2 倍にします。GB200 NVL72 ラックの大規模クラスター上で DeepSeek-R1 モデルを実行すると、NVIDIA Dynamo のインテリジェントな推論最適化により、生成されるトークンの数が GPU あたり 30 倍以上に増加します。

これらの推論パフォーマンスの向上を実現するために、NVIDIA Dynamo はスループットを向上させ、コストを削減する機能を備えています。リクエストの量や種類の変動に応じて GPU を動的に追加、削除、再割り当てするだけでなく、大規模クラスター内の特定の GPU を指定し、応答時間を最小限に抑え、クエリをルーティングすることもできます。また、推論データをより手頃な価格のメモリおよびストレージ デバイスにオフロードし、必要なときに素早く取得することができるため、推論コストを最小限に抑えることができます。

NVIDIA Dynamo は、完全にオープンソースで、PyTorch、SGLang、TensorRT-LLM、vLLM に対応することで、企業、スタートアップ、研究者が分散された推論全体にわたって AI モデルを提供する方法を探索し、最適化することを可能にします。これにより、AWS、Cohere、CoreWeave、Dell、Google Cloud、Lambda、Meta、Microsoft Azure、Nebius、NetApp、OCI、Perplexity、Together AI、VAST を含むエコシステムが、AI 推論の採用を加速することが可能になります。

推論の高速化

NVIDIA Dynamo は、推論システムが過去のリクエストの処理からメモリに保持する知識 (KVキャッシュ) を、数千もの GPU 間でマッピングします。次に、新しい推論リクエストを、知識の一致レベルが最も高い GPU にルーティングすることで、コストのかかる再計算を回避し、GPU を解放して新しいリクエストに対応できるようにします。

Perplexity AI の最高技術責任者である Denis Yarats 氏は次のように述べています。「毎月数億件のリクエストを処理するために、当社では NVIDIA GPU と推論ソフトウェアを活用して、ビジネスおよびユーザーが求めるパフォーマンス、信頼性、スケールを実現しています。分散処理機能が強化された Dynamo を活用して、推論処理の効率をさらに高め、新しい AI 推論モデルの計算要求に対応できることを期待しています」

エージェント型AI

AI プロバイダーの Cohere は、NVIDIA Dynamo を使用して Command シリーズのモデルにエージェント型 AI 機能を搭載予定です。

Cohere のエンジニアリング担当シニア バイス プレジデントである Saurabh Baji 氏は次のように述べています。 「高度な AI モデルの拡張には、洗練されたマルチ GPU スケジューリング、シームレスな調整、およびリーズニング コンテキストをメモリとストレージ間でシームレスに転送する低レイテンシ通信ライブラリが必要です。企業顧客に最高のユーザー体験を提供する上で、NVIDIA Dynamo が役に立つと期待しています」

分散処理

NVIDIA Dynamo 推論プラットフォームは、分散処理もサポートしており、これは、ユーザーのクエリに対する理解を構築し、最適な応答を生成するなど、LLM のさまざまな計算フェーズを異なる GPU に割り当てるものです。このアプローチは、文脈の理解と応答の生成を向上させる高度な推論技術を使用する新しい NVIDIA Llama Nemotron モデル ファミリーのような推論モデルに最適です。細分化された処理により、各フェーズを個別にファイン チューニングし、リソースを割り当てることが可能になり、スループットが向上し、ユーザーへのレスポンスが高速化します。

AI アクセラレーション クラウドである Together AI は、独自の Together Inference Engine に NVIDIA Dynamo を統合し、GPU ノード全体で推論ワークロードをシームレスに拡張できるようにすることを目指しています。これにより、Together AI はモデル パイプラインのさまざまな段階におけるトラフィックのボトルネックを動的に解決することも可能になります。

Together AI の最高技術責任者である Ce Zhang 氏は次のように述べています。「リーズニング モデルをコスト効率よくスケーリングするには、分散処理やコンテキスト認識ルーティングを含む、新しい高度な推論技術が必要です。Together AI は、独自の推論エンジンを使用して業界トップクラスのパフォーマンスを提供しています。 NVIDIA Dynamo はオープンでモジュール性に優れているため、そのコンポーネントを私たちのエンジンにシームレスに組み込むことができます。これにより、リソースの利用効率を最適化しながらより多くのリクエストに対応できるようになり、アクセラレーテッド コンピューティングへの投資を最大限に活用できます。このプラットフォームの画期的な機能を活用して、オープンソースのリーズニング モデルをユーザーにコスト効率よく提供できることを嬉しく思います」

NVIDIA Dynamo の詳細

NVIDIA Dynamo は、推論処理コストを削減し、ユーザー体験を向上させる4つの主要な画期的機能を提供しています。

- GPU Planner:ユーザー需要の変動に合わせて GPU を動的に追加、削除し、GPU の過剰プロビジョニングや不足を回避するプランニング エンジンです。

- Smart Router:多数の GPU 間でリクエストを振り分け、リクエストの繰り返しや重複のための高コストな GPU 再計算を最小限に抑える LLM 対応ルーターです。これにより、GPU が解放され、新たに届くリクエストに対応できるようになります。

- Low-Latency Communication Library:推論に最適化されたライブラリで、最先端の GPU 間通信に対応し、異種デバイス間でのデータ交換の複雑さを抽象化してデータ転送を高速化します。

- Memory Manager:ユーザー体験に影響を与えることなく、推論データを低コストのメモリおよびストレージ デバイスにインテリジェントにオフロードおよびリロードするエンジンです。

NVIDIA Dynamo は、NVIDIA NIM マイクロサービスで利用可能になり、プロダクション グレードのセキュリティ、サポート、安定性を備えた NVIDIA AI Enterprise ソフトウェア プラットフォームの将来のリリースでサポートされる予定です。

詳細については、NVIDIA GTC の基調講演をご覧いただくかブログをご参照ください。3 月 21 日まで開催される本イベントでの NVIDIA と業界リーダーによるセッションへ登録いただきご確認ください。

NVIDIA について

NVIDIA (NASDAQ: NVDA) はアクセラレーテッド コンピューティングの世界的なリーダーです。

本プレスリリースには、NVIDIAの製品、サービス、およびテクノロジの利点、影響、利用可能性、および性能に関する記述、第三者によるNVIDIAの製品およびテクノロジの採用とその利点および影響、世界中のさまざまな思考および学習方法でAIモデルをトレーニングし、時間をかけてより洗練されたものにする業界、カスタム推論AIの未来を実現するために、NVIDIA Dynamoがこれらのモデルを大規模に提供し、コスト削減とAIファクトリー全体の効率化を推進する将来の見通しに関する記述は、リスクや不確実性を伴うものであり、結果が予想と大幅に異なる可能性があります。実際の結果を大きく変化させる可能性がある重要な要因には、世界経済の状況、NVIDIAが製品の製造、組み立て、梱包、テストを第三者に依存していること、技術開発と競争の影響、新製品や新技術の開発、または既存の製品や技術の改良、NVIDIAの製品またはパートナーの製品の市場の受容度、設計、製造またはソフトウェアの欠陥、消費者の好みまたは需要の変化、業界標準およびインターフェースの変化、NVIDIAの製品または技術がシステムに統合された場合の予期せぬ性能低下、および Form 10-K 年次報告書および Form 10-Q 四半期報告書など、NVIDIA が米国証券取引委員会 (SEC) に適宜提出する最新の報告書に詳しく記載されているその他の要因などが含まれます。SEC に提出された報告書のコピーは、会社のウェブサイトに掲載され、NVIDIA から無料で入手できます。これらの将来の見通しに関する記述は、将来の業績を保証するものではなく、本プレス リリースの日付の時点での見解です。また、法律で義務付けられる場合を除き、NVIDIA は、将来の出来事や状況を反映するためにこれらの将来の見通しに関する記述を更新する義務を一切負いません。

本リリースに記載されている製品や機能の多くはまだ様々な段階にあり、利用可能になった時点で提供される予定です。記述は、コミットメント、約束、または法的義務として意図されたものではなく、またそう解釈されるべきでもありません。また、NVIDIA製品について説明された特徴や機能の開発、リリース、および時期は変更される可能性があり、NVIDIA単独の裁量に委ねられます。NVIDIAは、ここに記載された製品、特徴または機能の不提供または遅延について、いかなる責任も負いません。

© 2025 NVIDIA Corporation. All rights reserved. NVIDIA、NVIDIA ロゴ、NVIDIA Hopper、NVIDIA Triton Inference Server、およびTensorRTは、米国およびその他の国におけるNVIDIA Corporationの商標および/または登録商標です。 その他の会社名および製品名は、それぞれの会社の商標である場合があります。機能、価格、発売状況、仕様は予告なしに変更される場合があります。