NVIDIA GPU が AWS に採用されて10 年を迎え、A100 を搭載した新たな Amazon EC2 P4d インスタンが利用可能に

Amazon Web Service で GPU インスタンスが最初に登場したのは 10 年前で、NVIDIA M2050 が採用されました。その当時、CUDA ベースのアプリケーションが主眼を置いていたのは科学技術シミュレーションの加速で、AI やディープラーニングの登場はまだ先のことでした。

それ以来、AWS は、K80 (p2)、K520 (g3)、M60 (g4)、V100 (p3/p3dn) および T4 (g4) などを加え、クラウド GPU インスタンスを拡充させていきました。

最新のNVIDIA A100 Tensor コア GPU を搭載する新しい P4d インスタンスを本日より一般提供することで、AWS はアクセラレーテッド コンピューティングの新たな 10 年に向けての道を切り開こうとしています。

新しい P4d インスタンスにより、機械学習のトレーニングとハイパフォーマンス コンピューティング アプリケーションにおいて、 AWS で最も高性能かつ最も費用効果の高いGPU ベースのプラットフォームが提供されます。このインスタンスは、機械学習モデルのトレーニング時間をデフォルトのFP32 精度の場合と比べて、FP16 精度で最大 3 倍、TF32 精度で最大 6 倍短縮します。

また、非常に優れた推論の性能も提供します。つい先日には NVIDIA A100 GPU が、MLPerf 推論ベンチマークで新記録を樹立し、CPU と比べて最大 237 倍高速な性能を披露しました。

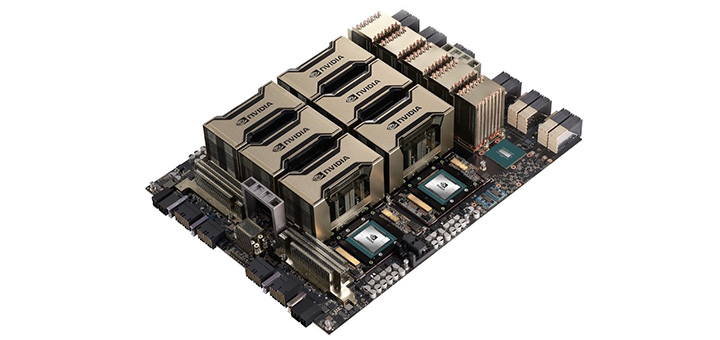

それぞれの P4d インスタンスには、8 基の NVIDIA A100 GPU が搭載されており、お客様は AWS UltraClusters により、AWS の Elastic Fabric Adaptor (EFA) および拡張性が高く、高性能のストレージである Amazon FSx を使用して、一度に 4,000 基を超える GPU にオンデマンドかつスケーラブルにアクセスすることができます。P4d は、400Gbps のネットワーキングを実現し、NVLink や NVSwitch、NCCL、GPUDirect RDMA といった NVIDIA のテクノロジにより、ディープラーニング トレーニングのワークロードをさらに加速します。EFA に実装された NVIDIA GPUDirect RDMA により、データは CPU やシステム メモリを通ることなく、サーバー間の GPU 同士でやりとりされるため、低レイテンシのネットワークが可能になります。

また、P4d インスタンスでは、Amazon Elastic Container Services や Amazon Elastic Kubernetes Service、AWS ParallelCluster、Amazon SageMaker といった数多くの AWS サービスに対応しています。P4d では、HPC アプリケーション、AI フレームワーク、事前トレーニング済みモデル、Helm チャート、ならびにTensorRT および Triton Inference Server のような推論ソフトウェアなど、NGC が提供する最適化およびコンテナ化されたソフトウェアをすべて利用することができます。

現在、P4d インスタンスは米国東部および米国西部の地域で利用可能となっており、まもなく利用可能な地域が追加される予定です。このインスタンスは、オンデマンド インスタンスとして、または Savings Plans、リザーブド インスタンスで、あるいはスポット インスタンスとしてご購入いただけます。

GPU クラウド コンピューティングの最初の 10 年では、100 エクサフロップスを越える AI 演算能力がマーケットにもたらされました。NVIDIA A100 GPU を搭載した Amazon EC2 P4d の登場により、GPU クラウド コンピューティングの次の 10 年に向けて幸先のよいスタートを切りました。

NVIDIA と AWS は、幅広いアプリケーションで AI の限界を絶えず押し広げ続けることを目指しています。お客様がこれをどのように利用なさるのかが、楽しみでなりません。

AWS にアクセスし、P4d インスタンスをご活用ください。