世界的 AI カンファレンスで、NVIDIA Grace Hopper Superchip を搭載した 11 のベンダーのアクセラレーテッド システムが展示予定

ソフトウェア界の伝説である GraceHopper の精神は、NVIDIA GTC でも生き続けます。

プログラミングのパイオニアに敬意を表して名付けられたパワフルなプロセッサを使用したアクセラレーテッド システムが、3 月18 日から 21 日まで開催される世界的なAI カンファレンスにおいて展示予定となっており、コンピューティングを次のレベルに引き上げる準備が整っています。

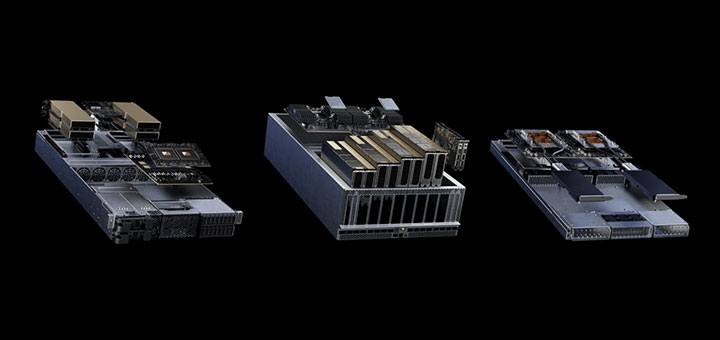

18 ラックにわたる複数構成の500 台を超えるサーバーがシステム メーカーによって展示されます。すべてのサーバーに NVIDIA GH200 Grace Hopper Superchip が搭載されています。MGXパビリオンを埋め尽くすサンノゼ コンベンション センターの NVIDIA ブースでの最大の展示となります。

MGX により市場投入までの時間を短縮

NVIDIA MGX は AI、ハイ パフォーマンスコンピューティング、NVIDIA Omniverse アプリケーション向けに、GPU、CPU、データ処理ユニット (DPU) を任意に組み合わせてアクセラレーテッド サーバーを構築するための青写真です。複数の製品世代とワークロードにわたって使用できるモジュール式のリファレンス アーキテクチャです。

GTC に参加すると、生成 AI の推論、レコメンダー システム、データ分析など、エンタープライズ、クラウド、通信エッジの用途に合わせてカスタマイズされたMGX モデルを詳しく見ることができます。

このパビリオンでは、シングルおよびデュアルのGH200 Superchip を 1Uおよび 2U シャーシに搭載したアクセラレーテッド システムが展示されます。このシステムは、LinkX ケーブルおよびトランシーバー経由で NVIDIA BlueField-3 DPU および NVIDIA Quantum-2 400Gb/s InfiniBand ネットワークを介してリンクされています。

これらのシステムは、業界標準の 19 インチおよび 21 インチのラック エンクロージャに対応しており、その多くは不揮発性ストレージ用のE1.S ベイを提供しています。

注目の的、Grace Hopper

現在提供中の MGX システムのサンプルは以下のとおりです。

- ASRockRACK の MECAI (450 x 445 x87 mm) は、通信ネットワークのエッジ内の限られたスペースでAI および 5G サービスを高速化します。

- ASUS の MGX サーバーであるESC NM2N-E1 は、最大 32 基のGH200 プロセッサを搭載するラックにスライド収納し、空冷および液冷ノードに対応します。

- Foxconn は、最大 8 基のNVIDIA H100 NVL PCIe Tensor コア GPU を搭載する4U モデルをはじめとする MGX システム シリーズを提供します。

- GIGABYTE の XH23-VG0-MGX は、6 個の 2.5 インチ Gen5 NVMe ホットスワップ対応ベイと 2 つの M.2 スロットに大量のストレージを収容できます。

- Inventec のシステムは 19 インチおよび21 インチのラックに組み込むことができ、3 種類の液冷実装を使用できます。

- Lenovo は、直接液冷方式をサポートするモデルを含む、1U、2U、および4U MGX サーバーを多数提供しています。

- Pegatron の空冷の AS201-1N0 サーバーには、ソフトウェアデファインドかつハードウェア アクセラレーテッドのネットワーキング向けのBlueField-3 DPU が搭載されています。

- QCT は、16 台の QuantaGrid D74S-IU システム (各システムにGH200 Superchip を 2基搭載) を 1 台の QCT QoolRack にスタックできます。

- 空冷および液冷の GH200 および NVIDIA Grace CPU システムのポートフォリオの 1 つである Supermicro のARS-111GL-NHR には、ホットスワップ可能なファンが 9 個搭載されています。

- Wiwynn の SV7200H は 1U デュアル GH200 システムで、BlueField-3DPU とリモート管理可能な液冷サブシステムをサポートしています。

- Wistron の MGX サーバーは、AI推論および混合ワークロード用の 4U GPU システムで、1つのシステムで最大 8 つのアクセラレータをサポートします。

新しいサーバーは、昨年 5 月に COMPUTEX で発表されたMGX を使用した 3 つのアクセラレーテッド システム (Grace CPU を使用するSupermicro の ARS-221GL-NR と、GH200を搭載した QCT のQuantaGrid S74G-2U および S74GM-2U) に追加されたものです。

2 in 1 の Grace Hopper

システム ビルダー各社は、強力なハイブリッド プロセッサを採用しています。

GH200 Superchip では、高性能で電力効率の高いGrace CPU とパワフルな NVIDIA H100 GPU が組み合わされており、高速な NVIDIA NVLink-C2C インターコネクトを介して数百ギガバイトのメモリを共有します。

その結果、大規模言語モデルの実行など、現在最も要求の厳しいジョブを実行するのに適したプロセッサとメモリの複合体が誕生しました。生成AI モデルをデータソースにリンクするために必要なメモリとスピードに対応するこのシステムにより、Retrieval-Augmented Generation (RAG) を使用して正確度を向上させることができます。

レコメンダーの実行速度が 4 倍に

さらに、GH200 Superchip は、オンライン ショッピングやメディア ストリーミングのレコメンデーションなどのタスクにおいて、H100GPU と従来の CPU を使用する場合に比べて効率が向上し、最大 4 倍のパフォーマンスを実現します。

GH200 システムは昨年 11 月に MLPerf 業界ベンチマークに初登場した際、すべてのデータセンター推論テストを実行し、すでに優れていたH100 GPU のパフォーマンスをさらに向上させる結果となりました。

70 年以上前に初のメインフレーム コンピューターで幕を開けたコンピューティング革命ですが、その名を冠した GH200 システムはここまでに述べたすべてにおいて、コンピューティング革命を新たな高みに引き上げています。

3 月18 日から 21 日までサンノゼ コンベンションセンターとオンラインで開催される AI とアクセラレーテッド コンピューティングに関するグローバル カンファレンスである、NVIDIA GTC に今すぐ登録しましょう。

また、NVIDIA の創業者兼/CEO であるジェンスン フアン (Jensen Huang) による GTC 基調講演にて、広範な視野から全体像を理解しましょう。