NVIDIA H200 NVL は、低電力の空冷式エンタープライズ ラック設計に最適で、大規模言語モデルの推論を最大 1.7 倍高速化し、ハイパフォーマンス コンピューティング アプリケーションで 1.3 倍のパフォーマンスを実現

その発表以来、NVIDIA Hopper アーキテクチャ は、AI とハイパフォーマンス コンピューティング (HPC) の状況を一変させ、企業、研究者、開発者がより高いパフォーマンスと優れたエネルギー効率により、世界で最も複雑な課題に取り組むことを支援してきました。

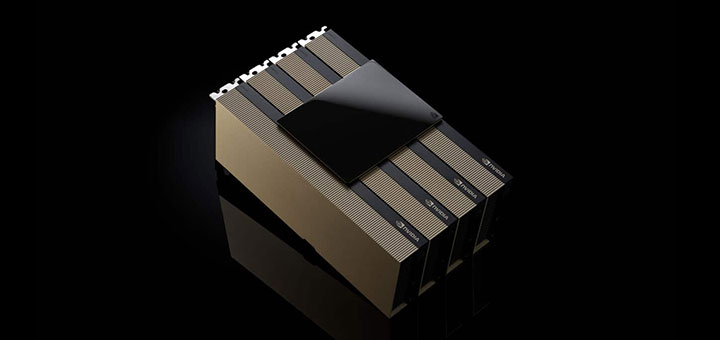

Supercomputing 2024 カンファレンスで、NVIDIA は Hopper ファミリーの最新製品である NVIDIA H200 NVL PCIe GPU の提供を発表しました。H200 NVL は、サイズに関係なく、自社のデータセンターにあらゆる AI および HPC ワークロードを高速化できる柔軟な構成を備えた低電力の空冷式エンタープライズ ラック設計を求める組織に最適です。

最近の調査によると、エンタープライズ ラックの約 70% は 20kW 以下で、空冷を使用しています。このため、PCIe GPU は不可欠であり、1 基、2基、4 基、または 8 基の GPU を使用するかどうかに関係なく、ノード展開の粒度を提供し、データセンターがより多くのコンピューティング能力をより小さなスペースに詰め込むことを可能にします。企業は既存のラックを使用して、ニーズに最適な数の GPU を選択できます。

企業は H200 NVL を使用して AI および HPC アプリケーションを高速化すると同時に、消費電力の削減によってエネルギー効率を向上させることができます。NVIDIA H100 NVL と比較してメモリの容量が 1.5 倍、帯域幅が 1.2 倍増加した H200 NVL を使用すると、企業は数時間以内に LLM をファインチューニングし、最大 1.7 倍の推論パフォーマンスが実現可能です。HPC ワークロードの場合、パフォーマンスは H100 NVL と比較して最大 1.3 倍、NVIDIA Ampere アーキテクチャ世代と比較して 2.5 倍向上します。

H200 NVL の本来のパワーを補完するのが NVIDIA NVLink テクノロジです。最新世代の NVLink は、第 5 世代 PCIe と比較して 7 倍高速な GPU 間通信を提供し、HPC、大規模言語モデルの推論、ファインチューニングのニーズを満たすためにより高いパフォーマンスを提供します。

NVIDIA H200 NVL は、企業が AI から HPC までアプリケーションを高速化できるようにする強力なソフトウェア ツールとペアになっています。これには、本番環境向けのAI の開発と展開のためのクラウドネイティブ ソフトウェア プラットフォームである NVIDIA AI Enterprise の 5 年間のサブスクリプションが付属しています。NVIDIA AI Enterprise には、高性能な AI モデルの推論を安全かつ高い信頼性で展開することを可能にする NVIDIA NIM マイクロサービスが含まれています。

H200 NVL のパワーを活用する企業

H200 NVL により、NVIDIA は企業に AI および HPC ワークロードを開発および展開するためのフルスタック プラットフォームを提供します。

活用企業は、顧客サービス用のビジュアル AI エージェントやチャットボット、金融用の取引アルゴリズム、ヘルスケアにおける異常検出の改善のための医用画像処理、製造業向けのパターン認識、連邦科学機関向けの地震画像処理など、さまざまな業界に渡る複数の AI および HPC ユース ケースに大きな効果があることを実感しています。

大手クラウド ストレージおよびファイル同期サービスである Dropbox は、サービスとインフラに NVIDIA のアクセラレーテッド コンピューティングを活用しています。

Dropbox インフラ事業のバイス プレジデントである Ali Zafar 氏は以下のように述べています。「Dropbox は大量のデータを処理しており、高度な AI と機械学習機能が必要です。Dropbox は継続的にサービスを改善し、顧客にさらなる価値を提供するために H200 NVL を検証しています」

ニューメキシコ大学は、さまざまな研究および学術アプリケーションで NVIDIA アクセラレーテッド コンピューティングを使用しています。

UNM 先端研究コンピューティング センターのディレクターである Patrick Bridges 教授は以下のように述べています。「公立研究大学として、AI への取り組みにより、当大学は科学技術の進歩の最前線に立つことができます。H200 NVL に移行することで、私たちはデータ サイエンスの取り組み、バイオインフォマティクスとゲノミクスの研究、物理学と天文学のシミュレーション、気候モデリングなど、さまざまなアプリケーションを高速化できるようになるでしょう」

エコシステム全体から提供される H200 NVL

Dell Technologies、Hewlett Packard Enterprise、Lenovo、Supermicro は、H200 NVL をサポートする幅広い構成のサーバーを提供する予定です。

さらに、H200 NVL は、Aivres、ASRock Rack、GIGABYTE、Inventec、MSI、Pegatron、QCT、Wistron、Wiwynn のプラットフォームでも利用可能になります。

一部のシステムは NVIDIA MGX モジュラー アーキテクチャに基づいており、これによりコンピューター メーカーは、さまざまなデータセンター インフラ設計を迅速かつコスト効率よく構築できます。

H200 NVL を搭載したプラットフォームは、12 月から NVIDIA のグローバル システム パートナーから利用可能になります。主要なグローバル パートナーからの提供を補完するために、NVIDIA は H200 NVL システム用の Enterprise Reference Architecture も開発しています。

リファレンス アーキテクチャには NVIDIA の専門知識と設計原則が組み込まれており、パートナーと顧客は H200 NVL に基づく高性能 AI インフラを大規模に設計および展開できます。これには、フルスタックのハードウェアとソフトウェアの推奨事項、および最適なサーバー、クラスター、ネットワーク構成に関する詳細なガイダンスが含まれます。ネットワークは、NVIDIA Spectrum-X Ethernet プラットフォームで最高のパフォーマンスが得られるように最適化されています。

NVIDIA のテクノロジは、11 月 17 日から 22 日までジョージア ワールド コングレス センターで開催される SC24 のショールーム フロアで展示されます。詳細については、NVIDIA の創業者/CEO であるジェンスン フアン (Jensen Huang) とハイパースケールおよび HPC 担当バイス プレジデントのイアン バック (Ian Buck) による特別講演のオンデマンド配信ご覧ください。

ソフトウェア製品情報については利用規約をご覧ください。