AI のトレーニングから展開、半導体からソフトウェア ライブラリ、システムからクラウド サービスまで、新世代のブレイクスルーがいかに各地の現場にもたらされるかについてNVIDIA の創業者/CEO であるジェンスン フアンが概説

ChatGPT は始まりに過ぎません。

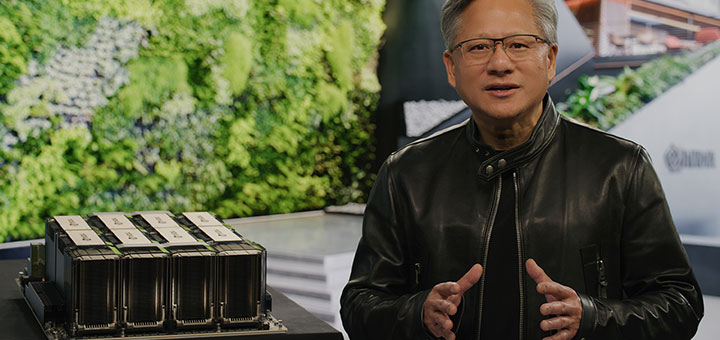

NVIDIA の創業者/CEO であるジェンスン フアン (Jensen Huang) は GTC の基調講演にて、コンピューティングが彼の言うところの「光速」で進歩する中で、Google、Microsoft、Oracle、さまざまな主要企業との広範なパートナーシップにより、あらゆる業界に新しい AI、シミュレーション、およびコラボレーション機能をもたらすと発表しました。

「ワープドライブ エンジンはアクセラレーテッド コンピューティングであり、エネルギー源は AI です」と、フアンはGTC カンファレンスにおける基調講演で述べました。「ジェネレーティブ AI の優れた機能により、企業は自社の製品とビジネスモデルを再考しなければならないという危機感を抱くようになりました」

4 日間のイベントの軸となる 78 分間の包括的なプレゼンテーションで、フアンは、NVIDIA とそのパートナーがトレーニングから最先端の AI サービスの展開まで、あらゆるものをどのように提供しているかを説明しました。さらに彼は、新たなブレイクスルーを可能にする新しい半導体とソフトウェア ライブラリについても発表し、これらのイノベーションを世界規模で機能させるために競争しているスタートアップや企業向けのシステムとサービスのフルセットも明らかにしました。

フアンは、このエコシステムが機能している鮮明な例をいくつか挙げて講演を締めくくりました。さらに、NVIDIA と Microsoft が、数億人もの Microsoft 365 と Azure のユーザーを超現実的な仮想世界を構築、および運用するためのプラットフォームに接続することを発表しました。Amazon が高度なシミュレーション機能を使用して、新しい自律型倉庫ロボットをトレーニングする方法も紹介しました。さらに、ChatGPT など、非常に人気のある新世代のジェネレーティブ AI サービスの台頭にも触れました。

さらに、NVIDIA のイノベーションの基本的な性質を強調し、ASML、TSMC、Synopsis と共に、NVIDIA のコンピュテーショナル リソグラフィのブレイクスルーが、新世代の効率的で強力な 2nm 半導体の実現にいかに役立つかを詳説しました。

アクセラレーテッド コンピューティングと AI の到来は、ムーアの法則が減速し、業界が持続可能性、ジェネレーティブ AI、デジタル化という強力なダイナミクスに取り組む中で、ちょうど間に合うようにやってきた、とフアンは述べています。「各種産業の企業は、デジタル化、そしてソフトウェア ドリブンのテクノロジ企業への再編成を競っています。破壊者になるためで、破壊される方にならないためです」と彼は語ります。

アクセラレーションにより、企業はこれらの課題に対応できます。「アクセラレーションは、パワーを取り戻し、持続可能性とネットゼロを達成するための最良の方法です」とフアンは述べています。

GTC: プレミア AI カンファレンス

今年で 14 年目を迎える GTC は、世界で最も重要な AI のカンファレンスの 1 つになりました。今週、DeepMind の Demis Hassabis 氏、Argonne Labs のValeri Taylor 氏、Adobe の Scott Belsky 氏、Netflix の Paul Debevec 氏、ETH Zurich のThomas Schulthess 氏などのリーダーによる 650 の講演、そしてフアンと、ChatGPT の作成者であり OpenAI の共同創設者である Ilya Sutskever 氏との特別対談が行われました。

25 万人以上の登録参加者が、失われた 2 千年前のローマ時代のモザイクの復元から、未来の工場の建設、新世代の大規模望遠鏡による宇宙の探索、創薬を加速するための分子の再配置から、ジェネレーティブ AI に関する 70 以上の講演まで、あらゆるセッションを掘り下げます。

AI における iPhone の瞬間

NVIDIA のテクノロジは AI の基盤であり、フアンはジェネレーティブ AI 革命の最初期に NVIDIA がどのように存在したかを語りました。さかのぼること 2016 年、彼は OpenAI に最初の NVIDIA DGX AI スーパーコンピューターを手渡しました。これは ChatGPT を強化する大規模言語モデル (LLM) のブレイクスルーを支えるエンジンとなりました。

昨年末に発表された ChatGPT は瞬時に主流となり、1 億人以上のユーザーを引き付け、史上最も急速に成長したアプリケーションになりました。「私たちは今、AI における iPhone の瞬間にいます」とフアンは言います。

NVIDIA DGX スーパーコンピューターは、もともと AI 研究の機器として使用されていましたが、現在、世界中の企業で 24 時間 365 日稼動しており、データを改良して AI を処理していると、フアンは報告します。Fortune 100 の企業の半数が DGX AI スーパーコンピューターを導入しているのです。

「DGX スーパーコンピューターは、最新の AI 工場です」とフアンは語ります。

データ センター向け NVIDIA H100、Grace Hopper、Grace

ChatGPT のような LLM の展開は、重要な新しい推論ワークロードである、とフアンは言います。ChatGPT のような大規模言語モデルの推論用に、フアンはデュアル GPU NVLink を備えた新しい GPU、H100 NVL を発表しました。

NVIDIA の Hopper アーキテクチャをベースとした H100 は、ChatGPT を強化する GPT モデルなどのモデルを処理するように設計された Transformer Engine を備えています。GPT-3 の処理を HGX A100 と比較した場合、デュアル GPU NVLink を備えた 4 組の H100 を備えた標準サーバーは最大 10 倍高速です。

「H100 は、大規模言語モデルの処理コストを桁違いに削減できます」とフアンは語ります。

一方、過去 10 年間で、クラウド コンピューティングは年間 20% 成長し、1 兆ドルの産業になったとも述べています。NVIDIA は、AI ワークロードが GPU で高速化される AI およびクラウド ファーストの世界に向けて Grace CPU を設計しました。Graceは現在サンプル提供中です。

NVIDIA の新しいスーパーチップである Grace Hopper は、Grace CPU と Hopper GPU を毎秒 900GB のコヒーレントな高速チップ間インターフェイスで接続します。Grace Hopper は、レコメンダー システム用の AI データベースや大規模言語モデルなどの巨大なデータセットを処理するのに理想的である、とフアンは説明します。

「顧客は、数桁大きい AI データベースを構築したいと考えています。Grace Hopper は理想的なエンジンです」とフアンは言います。

AI インフラストラクチャの青写真である DGX

DGX の最新バージョンは、8 基の NVIDIA H100 GPU が相互接続されており、1 つの巨大な GPU として機能します。「NVIDIA DGX H100 は、世界中で AI インフラストラクチャを構築している顧客にとっての青写真です」とフアンは述べ、NVIDIA DGX H100 が現在量産されていることを共有しました。

H100 AI スーパーコンピューターはすでに稼働を開始しています。

Oracle Cloud Infrastructure は、H100 GPU を搭載した新しい OCI Compute ベアメタル GPU インスタンスの限定提供を発表しました。

さらに、Amazon Web Services は、相互接続された H100 GPU を最大 2万基まで拡張できる P5 インスタンスの EC2 UltraClusters を発表しました。

これは、Microsoft Azure が先週発表した H100 仮想マシン ND H100 v5 のプライベート プレビューの発表に続くものです。

Meta は現在、H100 を搭載した Grand Teton AI スーパーコンピューターを AI の生産および研究チーム向けに社内で展開しています。

また、OpenAI は Azure スーパーコンピューターで H100 を使用して、継続的な AI 研究を強化しています。

H100 を提供している他のパートナーには Cirrascale と CoreWeave があり、どちらも本日一般提供を発表しました。 さらに、Google Cloud、Lambda、Paperspace および Vult が H100 を提供する予定です。

さらに、NVIDIA H100 GPU を搭載したサーバーとシステムは、Atos、Cisco、Dell Technologies、GIGABYTE、Hewlett Packard Enterprise、Lenovo、Supermicro などの主要なサーバー メーカーから入手できます。

DGX Cloud: すべての企業に AI を即座に導入

さらに、新製品の構築や AI 戦略の開発を急ぐスタートアップや企業に DGX の機能を迅速に提供するために、フアンは、Microsoft Azure、Google Cloud、および Oracle Cloud Infrastructure とのパートナーシップを通じて、NVIDIA DGX AI スーパーコンピューターを「ブラウザーからあらゆる企業に」提供することができる NVIDIA DGX Cloud を発表しました。

DGX Cloud は、AI のエンドツーエンドの開発と展開のための世界最先端のアクセラレーション ソフトウェア スイートである NVIDIA AI Enterprise を実行できるように最適化されています。「DGX Cloud は、最高の NVIDIA AI と、世界をリードする最高のクラウド サービス プロバイダーを顧客に提供します」とフアンは述べています。

NVIDIA は、DGX Cloud インフラストラクチャをホストする主要なクラウド サービス プロバイダーと提携しました。Microsoft Azure は次の四半期に DGX Cloud のホストを開始する予定であり、サービスはまもなく Google Cloud などに拡大されます。

このパートナーシップにより、NVIDIA のエコシステムがクラウド サービス プロバイダーにもたらされると同時に、NVIDIA の規模とリーチが拡大されるとフアンは語ります。企業は月単位で DGX Cloud クラスタをレンタルできるため、大規模なマルチノード トレーニング ワークロードの開発を迅速かつ簡単にスケールできます。

ジェネレーティブ AI の拡大

ジェネレーティブ AI を利用したいすべての人々の仕事を加速するために、フアンは、カスタムの LLM とジェネレーティブ AI を独自のデータでトレーニングし、ドメイン固有のタスクのために構築、改良、運用する必要があるお客様向けの一連のクラウド サービスである NVIDIA AI Foundations を発表しました。

AI Foundations サービスには、カスタム言語の text-to-text ジェネレーティブ モデルを構築するための NVIDIA NeMo、ライセンスされたコンテンツまたは独自のコンテンツでトレーニングされたカスタム モデルを構築したい顧客向けのビジュアル言語モデル作成サービスである Picasso、そして 2 兆ドル規模の創薬業界の研究者を支援する BioNeMo が含まれています。

Adobe は NVIDIA と提携して、未来のクリエイティブのための一連の次世代 AI 機能を構築しています。

Getty Images は NVIDIA と協力して、責任あるジェネレーティブな text-to-image および text-to-video の基盤モデルをトレーニングしています。

Shutterstock はNVIDIA と協力して、詳細な 3D アセットの作成を簡素化するために、ジェネレーティブな text-to-3D の基盤モデルをトレーニングしています。

医療の進歩を加速

さらに NVIDIA は、Amgen が BioNeMo で創薬サービスを加速していることを発表しました。ちなみに Alchemab Therapeutics、AstraZeneca、Evozyne、Innophore、Insilico はすべて BioNemo の早期アクセス ユーザーです。

BioNeMo は、研究者が独自のデータを使用してカスタム モデルを作成、ファインチューン、および提供するのに役立つ、とフアンは説明しました。

フアンはまた、NVIDIA と世界最大のヘルスケア テクノロジ プロバイダーである Medtronic が、ソフトウェア デファインドの医療機器向けの AI プラットフォームを構築するために提携していることを発表しました。この提携により、手術のナビゲーションからロボット支援手術まで、Medtronic システムの共通プラットフォームが構築されます。

そして、Medtronic は、結腸癌の早期発見のための AI を備えた同社の GI Genius システムが、リアルタイム センサー処理システム用のソフトウェア ライブラリである NVIDIA Holoscan 上に構築されており、今年末頃に出荷されることも発表しました。

「世界の 2,500 億ドル規模の医療機器市場が変革しています」とフアンは述べています。

ジェネレーティブ AI アプリケーションの迅速な展開

企業が急速に台頭するジェネレーティブ AI モデルを展開するのを支援するために、フアンは AI ビデオ、画像生成、LLM 展開、レコメンダー推論のための推論プラットフォームを発表しました。これらは、NVIDIA のフルスタックの推論ソフトウェアを、今回新たに発表された NVIDIA L4 Tensor コア GPU および NVIDIA H100 NVL GPU を含む最新の NVIDIA Ada、Hopper、および Grace Hopper プロセッサと組み合わせます。

- AI ビデオ用の NVIDIA L4 は、CPU の 120 倍の AI ビデオ性能を提供し、エネルギー効率を 99% 向上させます。

- 画像生成用の NVIDIA L40 は、グラフィックスおよび AI 対応の 2D、ビデオ、および 3D 画像生成用に最適化されています。

- 大規模言語モデル展開用の NVIDIA H100 NVL は、ChatGPT のような大規模な LLM を大規模に展開するのに理想的です。

- また、レコメンダー モデル用の NVIDIA Grace Hopper は、グラフ レコメンダー モデル、ベクトル データベース、およびグラフ ニューラル ネットワークに最適です。

Google Cloud は、プライベート プレビューで利用できるようになった新しい G2 仮想マシンの立ち上げにより、顧客に L4 を提供する最初のクラウド サービス プロバイダーです。Google はまた、L4 を Vertex AI モデル ストアに統合しています。

Microsoft と NVIDIA が「数億人」に Omniverse をもたらす

フアンは、NVIDIA が Microsoft と提携して、フル マネージドのクラウド サービスである NVIDIA Omniverse Cloud を世界中の業界にもたらすことを発表しました。これは、前例のないシミュレーションとコラボレーション機能を企業向けに高速化する 2 つ目のクラウド サービスです。

「Microsoft と NVIDIA は、数億もの Microsoft 365 と Azure ユーザーに Omniverse をもたらします」とフアンは述べ、NVIDIA Omniverse 向けに最適化された NVIDIA RTX Ada 世代 GPU と Intel の最新 CPU を搭載した新しい NVIDIA OVX サーバーと新世代のワークステーションも発表しました。

3D デザイン コラボレーションとデジタルツイン シミュレーション用に構築された NVIDIA のオープン プラットフォームである Omniverse の並外れた機能を示すために、フアンは、Omniverse 上に構築された NVIDIA のロボティクス シミュレーションおよび合成生成プラットフォームである NVIDIA Isaac Sim が、完全に忠実なデジタル ツインによって Amazon が時間と予算を節約するのにどのように役立っているかを示すビデオを共有しました。

そこでは、Amazon が自社の最初の完全自律型倉庫ロボットである Proteus を動かすために取り組んでいる様子が示されています。Proteus は、人間や他のロボットとともに、Amazon の広い倉庫内で製品が積まれたカゴ台車をある場所から別の場所に移動します。

3 兆ドル規模の自動車産業のデジタル化

Omniverse の範囲と能力の規模を説明しながら、フアンは 3 兆ドル規模の自動車産業のデジタル化における Omniverse の役割を掘り下げました。フアンによると、2030 年までに、自動車メーカーは 300 の工場を建設して 2 億台の電気自動車を製造し、バッテリー メーカーはさらに 100 のメガファクトリーを建設します。「デジタル化は、業界の効率、生産性、スピードを向上させます」と述べています。

業界全体での Omniverse の採用に触れながら、フアンは、Lotus が Omniverse を使用して仮想的に溶接ステーションを組み立てていると述べました。メルセデス・ベンツ は Omniverse を使用して、新しいモデルの組立ラインを構築、最適化、計画しています。Rimac と Lucid Motors は、Omniverse を使用して、自社の車を忠実に表現する実際の設計データからデジタル ストアを構築しています。

BMW は Idealworks と協力して、Omniverse で Isaac Sim を使用して合成データとシナリオを生成し、工場のロボットをトレーニングしています。また、BMW は Omniverse を使用して世界中の工場の運用計画を立てており、新たな電気自動車工場が物理的にオープンする 2 年前にOmniverse 内で工場の完全なデジタル ツインを建設中である、とフアンは述べました。

また、NVIDIA は本日、世界をリードする新エネルギー車のメーカーである BYD が、NVIDIA DRIVE Orin 集中型コンピューティング プラットフォームの使用を、より広範な NEV に拡大することを発表しました。

半導体のブレイクスルーを加速

現在の半導体製造プロセスが物理学の限界に近づく中で、ASML、TSMC、Synopsis などの半導体業界のリーダーが新世代のチップの設計と製造を加速できるようにするため、フアンは NVIDIA cuLitho を発表しました。これは、アクセラレーテッド コンピューティングをコンピュテーショナル リソグラフィの分野にもたらすブレイクスルーです。

コンピュテーショナル リソグラフィ向けの新しい NVIDIA cuLitho ソフトウェア ライブラリは、世界をリードするファウンドリである TSMC と、電子設計自動化のリーダーである Synopsys によって、最新世代の NVIDIA Hopper アーキテクチャ GPU 向けのソフトウェア、製造プロセス、およびシステムに統合されています。

チップ製造装置プロバイダーの ASML は、GPU と cuLitho で NVIDIA と緊密に連携しており、GPU のサポートをすべてのコンピュテーショナル リソグラフィ ソフトウェア製品に統合する予定です。リソグラフィが物理学の限界に達している中、NVIDIA が cuLitho を導入したことで、業界は 2nm を超えて前進することができるとフアンは述べています。

「チップ産業は、ほぼすべての産業の基盤です」とフアンは言います。

世界最大の企業を加速

世界中の企業がフアンのビジョンに賛同しています。

通信大手の AT&T はNVIDIA AI を使用してデータをより効率的に処理し、Omniverse ACE と Tokkio AI アバターのワークフローをテストして、カスタマー サービスと従業員のヘルプ デスク用の仮想アシスタントを構築、カスタマイズ、展開しています。

American Express、米国郵政公社、Microsoft Office および Teams、Amazon など 4 万にのぼる顧客が、高性能の NVIDIA TensorRT 推論オプティマイザーとランタイム、およびマルチフレームワーク データ センター推論サービス ソフトウェアである NVIDIA Triton を使用しています。

Uber は Triton を使用して、毎秒数十万件の到着予想時間の予測を提供しています。

また、毎日 6,000 万人を超えるユーザーを抱える Roblox は、Triton を使用して、ゲームのレコメンデーション、アバターの構築、コンテンツとマーケットプレイスの広告を管理するモデルを処理しています。

Microsoft、Tencent、Baidu はすべて、AI コンピューター ビジョンに NVIDIA CV-CUDA を採用しています。オープン ベータ版のこのテクノロジは、前処理と後処理を最適化し、コストとエネルギーを 4 倍節約します。

不可能を可能にする

フアンは講演の締めくくりとして、NVIDIA のシステム、クラウド、ソフトウェア パートナー、研究者、科学者、そして社員に感謝の意を表しました。

NVIDIA は、量子コンピューティング用の cuQuantum と新しくオープン ソース化された CUDA Quantum、組み合わせ最適化用の cuOpt、コンピュテーショナル リソグラフィ用の cuLitho を含む、100 のアクセラレーション ライブラリを更新したことを、フアンは発表しました。

世界の NVIDIA エコシステムは、現在 400 万人の開発者、4 万社もの企業、NVIDIA Inception の 14,000 のスタートアップまでもが含まれると、フアンは報告しています。

「私たちは一丸となって、世界が不可能を可能にする手助けをしているのです」とフアンは述べています。