開発者やクリエイターは、キャラクターやバーチャル アシスタント、パーソナライズされたアバターの声を生成する際、最先端の対話型 AI モデルにアクセスし、表現力豊かな音声合成が実現可能に。

AI は、ロボットのような自動音声の電話や数十年も前からある GPS ナビゲーション システムなどの単調な合成音声を一変し、スマートフォンやスマート スピーカーのバーチャル アシスタントが洗練された話し方へと変化してきました。

しかし、AI で合成された音声と、日常的な会話やメディアから聞こえてくる自然な音声の間にはまだ隔たりがあります。人間の話し方には複雑なリズムや抑揚に加えて独特の声色があり、AI が模倣するのは困難だからです。

この隔たりが急速に解消しつつあります。NVIDIA の研究者たちは、人工的な音声ではなく、人間の声が持つ豊かな表現力を取り込んだ、高品質で制御可能な音声合成用のモデルとツールの作成を進めています。これらの最新のプロジェクトは、9 月 3 日まで開催される INTERSPEECH 2021 カンファレンスのセッションで紹介されています。

このようなモデルによって、銀行や小売業のカスタマー サービス用自動音声電話を支援したり、ビデオゲームや本のキャラクターを生き生きと描写したり、リアルタイムの音声合成をデジタル アバターに提供することができます。

NVIDIA 社内のクリエイティブ チームでも、AI のパワーを紹介するビデオ シリーズのナレーションを豊かに表現するために、このテクノロジを採用しています。

表現力の豊かな音声合成は、対話型 AI に関する NVIDIA Research の研究の ひとつの要素に過ぎません。この分野には他にも、自然言語処理、自動音声認識、キーワード検出、オーディオ エンハンスメントなど、さまざまな要素が含まれています。

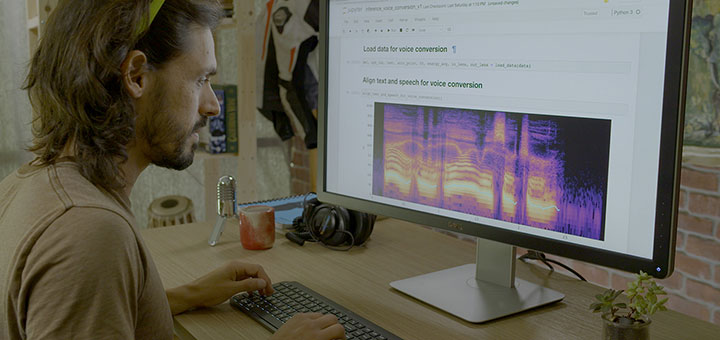

この最先端の研究成果の一部は、NVIDIA GPU で効率的に実行できるよう最適化されており、NVIDIA NeMo ツールキットを通じて利用できるオープン ソースとして作成されています。このツールキットは、コンテナーやその他のソフトウェアを提供する NGC ハブから利用できます。

I AM AI の舞台裏

NVIDIA の研究者やクリエイティブ プロフェッショナルたちは、対話型 AI について語るだけでなく、実際に実行に移しています。NVIDIA の I AM AI ビデオ シリーズでは、画期的な音声合成モデルを活用し、考え得るあらゆる業界を変革する世界の AI イノベーターを取り上げています。

最近まで、このビデオ シリーズのナレーションは人間が担当していました。以前の音声合成モデルでは、合成された音声のテンポやピッチの制御に限界があったため、AI ナレーションを試みても、スキルのある人間が話すように視聴者の感情に訴えることはできませんでした。

この状況は、ここ 1 年ほどで変化しています。NVIDIA の Text-to-Speech (文字音声変換) の研究チームが、RAD-TTS などの強力で制御可能な音声合成モデルを開発したためです。このモデルは、SIGGRAPH リアルタイム ライブ コンテストで優勝したデモで使用されました。RAD-TTS では、個人の音声で Text-to-Speech モデルをトレーニングすることで、任意のテキストを話し手の音声に変換できます。

もう 1 つの機能である音声変換を利用すると、ある話し手の言葉や歌声を、別の話し手の声にすることができます。人間の声を楽器として利用するアイデアからヒントを得た RAD-TTS のインターフェイスでは、合成された音声のピッチ、長さ、強さに対して、フレームレベルの詳細な制御が可能です。

NVIDIA のビデオ プロデューサーはこのインターフェイスを利用して、自分で朗読したビデオ スクリプトを録音し、AI モデルを使用して女性ナレーターの声に変換しました。続いてこのナレーションをベースに、AI を声優のように演出することができました。つまり、合成音声を微調整して特定の言葉を強調したり、ナレーションの速さを修正してビデオの雰囲気をより適切に表現したりするようにしたのです。

この AI モデルの機能は、ナレーション以外の場面に拡がっています。Text-to-Speech は、ゲームの中で、また、話すことが困難な障がい者の支援や、話し言葉の翻訳に活用できます。有名な歌手のパフォーマンスを再現し、歌のメロディーだけではなく、歌を彩る感情表現をも一致させることもできます。

AI の開発者や研究者に音声を提供する

NVIDIA NeMo は、GPU で加速された対話型 AI を実現する、オープンソースの Python ツールキットです。研究者、開発者、クリエイターは、独自のアプリケーション向けに音声モデルを試用や微調整を行って、スムーズに開発を開始できます。

研究者は、使いやすい API と NeMo で事前学習させたモデルを使って、Text-to-Speech、自然言語処理、リアルタイムの自動音声認識用のモデルを開発し、カスタマイズできます。いくつかのモデルは、NVIDIA DGX システムで何万時間分もの音声データを使用してトレーニングされています。開発者は、NVIDIA Tensor コア GPU の混合精度コンピューティングを使用してトレーニングを高速化することで、ユースケースに合わせてモデルを調整することが可能です。

NVIDIA NeMo では、Mozilla Common Voice で学習したモデルをNGC を通じて提供しています。Mozilla Common Voice は、約 14,000 時間に上る、クラウドで収集された 76 言語の音声データによるデータセットです。このプロジェクトは、世界最大のオープン データである音声データセットによって、誰もが音声技術を利用できるようにすることを目的としており、NVIDIA も支援しています。

ボイス ボックス: NVIDIA の研究者が AI の音声について解説

INTERSPEECH では、1,000 人を超える研究者が集まり、音声技術の画期的な研究を紹介します。今週のカンファレンスでは、NVIDIA Research が対話型 AI モデルのアーキテクチャや、完全にフォーマットされた開発者向け音声データセットについて発表します。

NVIDIA の講演者が登壇するのは以下のセッションです、ぜひご覧ください。

日程は現地中央ヨーロッパ時間(CET)です。

- Scene-Agnostic Multi-Microphone Speech Dereverberation (場所に依存しない複数マイクによる音声の残響抑圧) — 8 月 31 日 (火)

- SPGISpeech: 5,000 Hours of Transcribed Financial Audio for Fully Formatted End-to-End Speech Recognition (完全にフォーマット化されたエンドツーエンドの音声認識を実現する、5,000 時間分の金融関連の音声の書き起こし) — 9 月 1 日 (水)

- Hi-Fi Multi-Speaker English TTS Dataset (高品質の複数の話者による英語の TTS データセット) — 9 月 1 日 (水)

- TalkNet 2: Non-Autoregressive Depth-Wise Separable Convolutional Model for Speech Synthesis with Explicit Pitch and Duration Prediction (明示的に音の高さと長さを予測する音声合成のための、非自己回帰深度分離畳み込みモデル) — 9 月 2 日 (木)

- Compressing 1D Time-Channel Separable Convolutions Using Sparse Random Ternary Matrices (スパース ランダム 3 元行列を用いた、1 次元時間チャネル分離畳み込みの圧縮)— 9 月 3 日 (金)

- NeMo Inverse Text Normalization: From Development to Production (NeMo の逆テキスト正規化: 開発から運用へ) — 9 月 3 日 (金)

NVIDIA NeMo のモデルは NGC catalogを通じて提供しています。INTERSPEECH で NVIDIA の研究者による講演をご視聴ください。