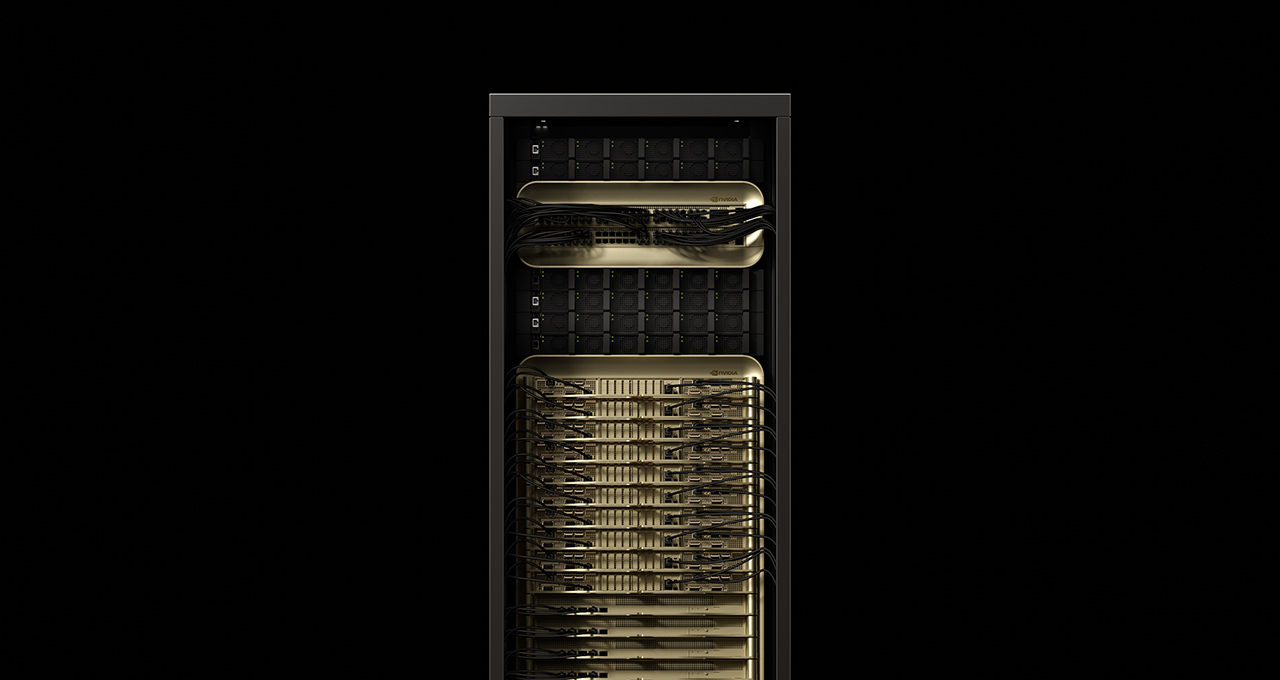

最も困難な推論シナリオのいくつかを反映した最新の MLPerf Inference V5.0 ベンチマークで、NVIDIA Blackwell プラットフォームが記録を樹立しました。そして、NVIDIA が AI 推論用に設計されたラックスケール ソリューションである NVIDIA GB200 NVL72 システムを使用して MLPerf にエントリーしたのはこれが初めてです。

最先端の AI を実現するには、AI ファクトリーという新たなタイプのコンピューティング インフラストラクチャが必要です。AI ファクトリーは従来のデータ センターとは異なり、データを保存、処理するだけでなく、生データをリアルタイムの洞察に変換することで、大規模にインテリジェンスを生み出します。AI ファクトリーの目標は、クエリに対する正確な回答を可能な限り多くのユーザーに迅速かつ最小限のコストで提供するというシンプルなものです。

これを実現するには非常に複雑な処理が必要で、そうした処理はバックグラウンドで行われています。AI モデルは、よりスマートな応答を提供するために、数十億から数兆のパラメータを持つようになっており、各トークンの生成に必要な計算量も増加しています。この要件により、AI ファクトリーが生成できるトークンの数が減り、トークンあたりのコストも増加しています。推論スループットを高く保ち、トークンあたりのコストを低く抑えるには、シリコン、ネットワーク システム、ソフトウェアにまたがるテクノロジー スタックのすべてのレイヤーで迅速なイノベーションが必要です。

推論性能に関するピアレビューによる業界ベンチマークである MLPerf Inference の最新アップデートには、最大規模かつ最も実行が難しいオープン ウェイト モデルの 1 つである Llama 3.1 405B の追加が含まれています。新しい Llama 2 70B Interactive ベンチマークでは、元の Llama 2 70B ベンチマークと比較してレイテンシ要件がはるかに厳しくなっており、可能な限り最高のユーザー エクスペリエンスを提供する上での本番環境での制約がより正確に反映されています。

Blackwell プラットフォームに加えて、NVIDIA Hopper プラットフォームも全般的に優れたパフォーマンスを示しており、フルスタックの最適化により、Llama 2 70B ではこの 1 年でパフォーマンスが大幅に向上しています。

NVIDIA Blackwell が新記録を樹立

72 基の NVIDIA Blackwell GPU を接続して 1 つの巨大な GPU として機能する GB200 NVL72 システムは、今回のラウンドで提出された NVIDIA H200 NVL8 と比較して、Llama 3.1 405B ベンチマークで最大 30 倍のスループットを実現しました。この快挙は、GPU あたりのパフォーマンスが 3 倍以上になり、NVIDIA NVLink の相互接続ドメインが 9 倍になったことで達成されました。

多くの企業が自社のハードウェアで MLPerf ベンチマークを実行してパフォーマンスを測定していますが、Llama 3.1 405B ベンチマークの結果を提出し、公開したのは、NVIDIA とそのパートナーだけでした。

本番環境での推論の展開では、多くの場合、2 つの主要な指標においてレイテンシの制約があります。1 つ目は最初のトークンまでの時間 (TTFT) で、大規模言語モデルに与えられたクエリに対する応答がユーザーに表示され始めるまでの時間を指します。2 つ目は出力トークンあたりの時間 (TPOT) で、トークンがユーザーにどれだけ速く配信されるかを示します。

新しい Llama 2 70B Interactive ベンチマークでは、TPOT が従来の 5 分の 1、TTFT が 4.4 分の 1 に短縮されており、より応答性の高いユーザー体験を再現しています。このテストで NVIDIA が提出したのは、8 基の Blackwell GPU を搭載した NVIDIA DGX B200 システムで、8 基の NVIDIA H200 GPU を使用した場合と比べて、パフォーマンスが 3 倍になっています。Llama 2 70B ベンチマークの難易度が上がったバージョンに高い基準を設定しました。

Blackwell アーキテクチャと最適化されたソフトウェア スタックを組み合わせることで、推論パフォーマンスが新たなレベルに引き上げられ、AI ファクトリーにおいて、インテリジェンスおよびスループットの向上、トークン レートの高速化が実現可能になります。

NVIDIA Hopper AI ファクトリーの価値は高まり続けている

2022 年に登場した NVIDIA Hopper アーキテクチャは、今日の AI 推論ファクトリーの多くに採用され、モデルのトレーニングにも引き続き活用されています。NVIDIA は、継続的なソフトウェア最適化を通じて Hopper ベースの AI ファクトリーのスループットを向上させ、より大きな価値を生み出しています。

1 年前に MLPerf Inference v4.0 で初めて導入された Llama 2 70B ベンチマークでは、H100 GPU スループットが 1.5 倍に向上しました。同じ Hopper GPU アーキテクチャをベースとし、さらに大容量かつ高速な GPU メモリを搭載した H200 GPU では、このスループットがさらに向上し、1.6 倍に達しています。

また、Hopper は、新たに追加された Llama 3.1 405B、Llama 2 70B Interactive、グラフ ニューラルネットワークの各テストをはじめ、すべてのベンチマークを実行しました。この汎用性により、Hopper は幅広いワークロードを実行でき、モデルや使用シナリオがより複雑になっても対応することができます。

エコシステムの力

今回の MLPerf ラウンドでは、ASUS、Cisco、CoreWeave、Dell Technologies、富士通、Giga Computing、Google Cloud、Hewlett Packard Enterprise、Lambda、Lenovo、Oracle Cloud Infrastructure、Quanta Cloud Technology、Supermicro、Sustainable Metal Cloud、VMware の 15 社のパートナーが NVIDIA プラットフォームで素晴らしい結果を提出しました。

幅広い応募は、世界中のすべてのクラウドサービスプロバイダーおよびサーバーメーカーで利用可能なNVIDIAプラットフォームの普及を反映しています。

MLCommons は、最新の AI 開発に遅れを取らないように MLPerf 推論ベンチマーク スイートを継続的に進化させるとともに、IT 意思決定者が最適な AI インフラを選択する上で不可欠であるピアレビュー済みの厳密なパフォーマンス データをエコシステムに提供するという取り組みを行っています。

MLPerf について詳しくはこちらをご覧ください。

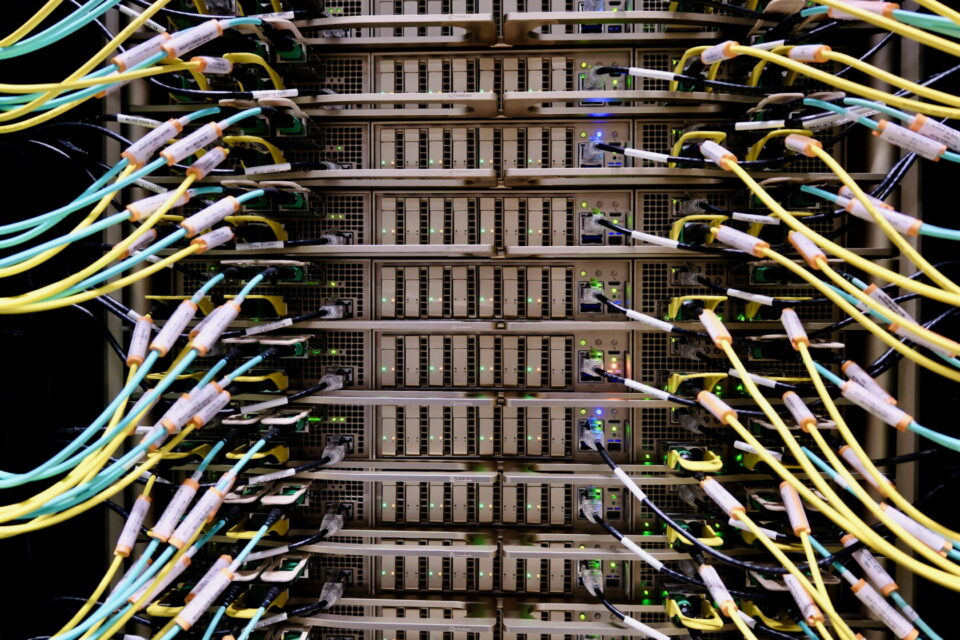

画像と動画は、シリコンバレーの Equinix データセンターで撮影されたものです。