AI の力を活用しようとする企業は、業界固有のニーズに合った、カスタマイズ モデルを必要としています。

NVIDIA AI Foundry は、企業がデータ、アクセラレーテッド コンピューティング、ソフトウェア ツールを使用して、生成 AI イニシアチブを強化できるカスタム モデルを作成および展開できるようにするサービスです。

TSMC が他社の設計したチップを製造するのと同じように、NVIDIA AI Foundry は、DGX Cloud、基盤モデル、NVIDIA NeMo ソフトウェア、NVIDIA の専門知識、エコシステム ツールとサポートを使用して、他社が AI モデルを開発およびカスタマイズするためのインフラとツールを提供します。

主な違いは製品です。TSMC は物理的な半導体チップを製造する一方で、NVIDIA AI Foundry はカスタム モデルの作成を支援します。どちらもイノベーションを可能にし、ツールとパートナーの広大なエコシステムに接続します。

企業は AI Foundry を使用して、新しい Llama 3.1 コレクション、NVIDIA Nemotron、CodeGemma by Google DeepMind、CodeLlama、Gemma by Google DeepMind、Mistral、Mixtral、Phi-3、StarCoder2 など、NVIDIA およびオープン コミュニティ モデルをカスタマイズできます。

業界の先駆者が AI イノベーションを推進

業界のリーダーである Amdocs、Capital One、Getty Images、KT、Hyundai Motor Company、SAP、ServiceNow、Snowflake は、NVIDIA AI Foundry を最初に使用した企業の一部です。これらの先駆者は、エンタープライズ ソフトウェア、テクノロジ、通信、メディアにおける AI 主導のイノベーション新時代の基盤を築いています。

ServiceNow の AI 製品担当バイス プレジデント、Jeremy Barnes 氏は次のように述べています。「AIを導入する組織は、業界やビジネスの知識を取り入れたカスタム モデルで競争上の優位性を獲得できます。ServiceNow は、NVIDIA AI Foundry を使用して、顧客の既存のワークフローに簡単に統合できるモデルをファインチューニングし展開しています」

NVIDIA AI Foundry の柱

NVIDIA AI Foundry は、基盤モデル、エンタープライズ ソフトウェア、アクセラレーテッド コンピューティング、専門家によるサポート、幅広いパートナー エコシステムという重要な柱によってサポートされています。

そのソフトウェアには、NVIDIA と AI コミュニティの AI 基盤モデルのほか、モデル開発を迅速に進めるための完全な NVIDIA NeMo ソフトウェア プラットフォームが含まれています。

NVIDIA AI Foundry のコンピューティングの強みは、世界有数のパブリック クラウドである Amazon Web Services、Google Cloud、Oracle Cloud Infrastructure と共同で設計されたアクセラレーテッド コンピューティング リソースのネットワークである NVIDIA DGX Cloud です。DGX Cloud を使用すると、AI Foundry の顧客は、これまでにない容易さと効率でカスタム生成 AI アプリケーションを開発およびファインチューニングし、ハードウェアへの多額の先行投資をすることなく、必要に応じて AI イニシアチブを拡張することができます。この柔軟性は、急速に変化する市場で俊敏性を維持しようとする企業にとって非常に重要です。

NVIDIA AI Foundry の顧客がサポートを必要とする場合、NVIDIA AI Enterprise の専門家が支援します。NVIDIA の専門家は、独自のデータを使用してモデルを構築、ファインチューニング、展開するために必要な各手順を顧客に説明し、モデルが顧客のビジネス要件に厳密に適合していることを保証します。

NVIDIA AI Foundry の顧客は、包括的なサポートを提供できるパートナーのグローバル エコシステムにアクセスできます。Accenture、Deloitte、Infosys、Wipro は、AI 主導のデジタル トランスフォーメーション プロジェクトの設計、実装、管理を含む AI Foundry コンサルティング サービスを提供する NVIDIA パートナーの一部です。Accenture は、カスタム モデル開発向けの独自の AI Foundry ベースのサービスである Accenture AI Refinery フレームワークを提供する最初の企業です。

さらに、Data Monsters、Quantiphi、Slalom、SoftServe などのサービス提供パートナーは、企業が AI を既存の IT 環境に統合する際の複雑さを乗り越えるのを支援し、AI アプリケーションが拡張性、安全性、ビジネス目標との整合性を確保するのを支援します。

顧客は、Cleanlab、DataDog、Dataiku、Dataloop、DataRobot、Domino Data Lab、Fiddler AI、New Relic、Scale、Weights & Biases などの NVIDIA パートナーの AIOps および MLOps プラットフォームを使用して、本番用の NVIDIA AI Foundry モデルを開発することができます。

顧客は、カスタムモデル、最適化されたエンジン、標準 API を含む NVIDIA NIM 推論マイクロサービスとして AI Foundry モデルを出力し、好みのアクセラレーテッド インフラで実行可能です。

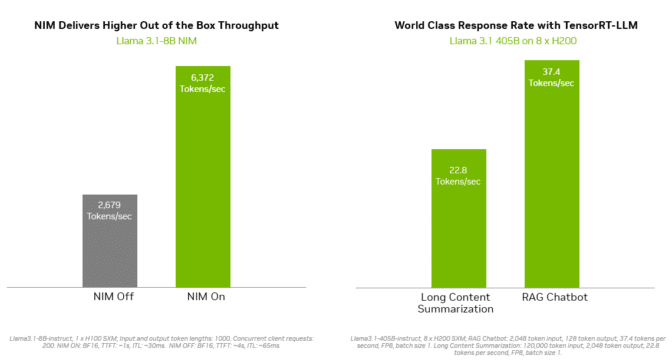

NVIDIA TensorRT-LLM などの推論ソリューションは、Llama 3.1 モデルの効率を向上させ、遅延を最小限に抑え、スループットを最大化します。これにより、企業はトークンをより速く生成しながら、生産環境でモデルを実行する総コストを削減できます。NVIDIA AI Enterprise ソフトウェア スイートによって、エンタープライズ グレードのサポートとセキュリティが提供されます。

幅広い展開オプションには、Cisco、Dell Technologies、Hewlett Packard Enterprise、Lenovo、Supermicro などのグローバル サーバー製造パートナーの NVIDIA-Certified Systems や、Amazon Web Services、Google Cloud、Oracle Cloud Infrastructure のクラウド インスタンスが含まれます。

さらに、大手 AI アクセラレーション クラウドの Together AI は、10 万人を超える開発者と企業のエコシステムが NVIDIA GPU アクセラレーテッド推論スタックを使用して、Llama 3.1 エンドポイントやその他のオープンモデルを DGX Cloud に展開できるようになることを発表しました。

Together AI の創設者兼 CEO である Vipul Ved Prakash 氏は次のように述べています。「生成 AI アプリケーションを実行しているすべての企業は、効率性を高め、コストを削減しながら、より高速なユーザー エクスペリエンスを望んでいます。現在、Together Inference Engine を使用する開発者と企業は、NVIDIA DGX Cloud で性能、拡張性、安全性を最大限に高めることができます」

NVIDIA NeMo がカスタムモデルの開発を高速化かつ簡素化

NVIDIA NeMo が AI Foundry に統合されているため、開発者はデータのキュレーション、基盤モデルのカスタマイズ、パフォーマンスの評価に必要なツールをすぐに利用できます。NeMo テクノロジには次のものが含まれます:

- NeMo Curator は、GPU アクセラレーテッド データ キュレーション ライブラリで、事前トレーニングとファインチューニング用に大規模で高品質のデータセットを準備することで、生成 AI モデルのパフォーマンスを向上。

- NeMo Customizer は、ドメイン固有のユースケースに合わせて LLM のファインチューニングと調整を簡素化する、高性能でスケーラブルなマイクロサービス。

- NeMo Evaluator は、高速化されたクラウドまたはデータセンター上の学術ベンチマークとカスタム ベンチマーク全体で生成 AI モデルの自動評価を提供。

- NeMo Guardrails はダイアログ管理を調整し、大規模言語モデルを備えたスマート アプリケーションの精度、適切性、セキュリティをサポートして、生成 AI アプリケーションに保護を提供。

NVIDIA AI Foundry の NeMo プラットフォームを使用すると、企業はニーズに正確に合ったカスタム AI モデルを作成することができます。このカスタマイズにより、戦略目標との整合性が高まり、意思決定の精度を向上させ、運用効率が強化されます。例えば、企業は業界固有の専門用語を理解し、規制要件に準拠し、既存のワークフローとシームレスに統合したモデルの開発が可能になります。

SAP の最高 AI 責任者である Philipp Herzig 氏は次のように述べています。「パートナーシップの次のステップとして、SAP は NVIDIA の NeMo プラットフォームを使用して、SAP Business AI を活用した AI 主導の生産性を企業が加速できるように支援します」

企業は、NVIDIA NeMo Retriever NIM 推論マイクロサービスを使用して、カスタム AI モデルを本番環境に展開することができます。これにより、開発者は RAG (検索拡張生成) で AI アプリケーション用の知識豊富な応答を生成するために、独自のデータを取得することが可能になります。

Snowflake の AI 責任者である Baris Gultekin 氏は次のように述べています。「生成 AI を活用する企業にとって、安全で信頼できる AI は譲れないものであり、検索精度は RAG システムで生成される応答の関連性と品質に直接影響します。Snowflake Cortex AI は、NVIDIA AI Foundry のコンポーネントである NeMo Retriever を活用し、カスタム データを使用して、簡単かつ効率的で信頼できる回答を企業に提供します」

カスタム モデルが競争優位性を高める

NVIDIA AI Foundry の主な利点の 1 つは、企業が AI を導入する際に直面する固有の課題に対処できることです。汎用の AI モデルでは、特定のビジネス ニーズやデータ セキュリティ要件を満たせない場合があります。一方、カスタム AI モデルは優れた柔軟性、適応性、パフォーマンスを提供するため、競争優位性を獲得したい企業に最適です。

NVIDIA AI Foundry によって企業の生産性とイノベーションがどのように向上するかについての詳細をご覧ください。